--------點擊屏幕右側或者屏幕底部“+訂閱”,關注我,隨時分享機器智能最新行業動態及技術乾貨----------

數字經濟時代的人工智能發展現狀

上海臨港的一片原生態海灘已經成為上海觀賞日出日落的“網紅”地標,但在欣賞日出日落的時候,一些來這裡“打卡”的遊客會發現,有時頭頂會出現無人機,播放勸說遊客遠離海灘的提醒:無人機會根據每天的潮汐時刻表,提前 20 分鐘“出勤”,沿著海岸線在 30 米高的半空中巡檢飛行,提醒遊客不要停留在即將漲潮的海灘上。

更厲害的是,基於機器視覺,無人機能識別滯留遊客,在其頭頂繞飛並實時喊話,緊急情況下直接報警請求進一步干預,直到消除安全隱患,無人機才會飛離。

如今,臨港地區的無人機能實現 5 分鐘內出勤、每天飛行 100 公里以上的“工作量”,要比人力巡檢高效得多。除了高效,人工智能還助力城市精細化管理“防範於未然”。在臨港,從“主動發現”到“智能派單”再到“處理完畢”的閉環案例已有不少。

不止是在上海臨港,在全球範圍內,人工智能的應用已經非常普及。根據 Statista 預計,人工智能市場增速將保持年均 50.7% 的增速增長,到 2025 年,全球人工智能市場規撗將高達 369 億美元,隨若人工智能在圖像(包括人臉)識別、語音識別、工業/製造業大腦、預測分析、自動化(包括自動駕駛)等方面的能力不斷提升,數字經濟時代的發展與人工智能應用的推進已經密不可分,零售業、醫療健康、金融行業、交通行業、教育行業、商業服務業、安全行業、農業等行業都將被人工智能深度滲透。

但對於整個人工智能產業來看,在行業領域的高度滲透性並非是全部,人工智能發展存在著其獨特並持續動態變化的發展現狀。

一、人工智能投資逐步降溫

根據中國信息通信研究院數據研究中心在 2019 年 04 月發佈的《全球人工智能產業數據報告》顯示,2018 年第二季度依賴,全球人工智能領域投資熱度逐漸下降,2019 年第一季度,全球融資規模 126 億美元,環比下降 7.3%,融資筆數 310 筆,同比下降44.1%,其中,中國人工智能領域融資金額 30 億美元,同比下降 55.8%。

與過去風險投資家正紛紛為那些在 PowerPoint 演示文件中植入“人工智能”這個神奇詞彙的初創企業融資不同,人工智能投資正逐步降溫。事實上,在解決實際複雜問題方面,人工智能的最新化身並不比 30 年前的先行者好很多。經過大量量身定製的系統能夠在圍棋、象棋或《危險邊緣》等狹窄挑戰中勝出。但是,要從人體顯示出的複雜且矛盾的症狀中診斷疾病,是它們現在還做不到的事情。

二、 人工智能企業盈利仍然困難

人工智能企業盈利仍然困難,以知名企業 DeepMind 為例,其 2018 年財報顯示營業額為 1.028 億英鎊, 2017 年為 5442.3 萬英鎊,同比增長 88.9%,但DeepMind在 2018 年淨虧損 4.7 億英鎊,較 2017 年的 3.02 億英鎊增加 1.68 億英鎊,虧損同比擴大 55.6%。

不單是 DeepMind,有報告顯示,2018 年近 90% 的人工智能公司處於虧損狀態,而 10% 賺錢的企業基本是技術提供商,換句話說,人工智能公司仍然未能形成商業化、場景化、整體化落地的能力,更多的只是銷售自己的算法,比如,每一次刷臉支付時,獲得很可能只有幾分錢的“算法使用費用”。

三、 無監督學習正在突破通用智能

過去十年,機器學習在圖像識別、自動駕駛汽車和圍棋等領域取得了前所未有的進步。這些成功在很大程度上是靠監督學習和強化學習來實現的,這兩種方法都要求由人設計訓練信號並傳遞給計算機:

在監督學習的情況下,這些是“目標”(例如圖像的正確標籤);在強化學習的情況下,它們是成功行為的“獎勵”(例如在 Atari 遊戲中獲得高分)。因此,強化學習也可以被認為是一種監督學習,這兩者構成了當前機器學習的主要學習方式,也為機器學習構建了一個極限:人類訓練師和數據量決定了機器學習的深度和精度。

很顯然,機器學習如今遇到了瓶頸,無論是人類訓練師還是數據量,都難以支撐機器學習更進一步地發展出高水平的人工智能,更不用提通用智能,人類和數據成為了通用智能發展的阻礙,無監督學習則是這一難題當前唯一的解決途徑。

無監督學習就像是幼兒學習,不僅有指導(監督學習) 和鼓勵(強化學習),還應該有自由探索世界的能力,不需要人為的干預,這就是無監督學習。這就是為什麼,如果要讓 AI 脫離人類發展出通用智能,必須要讓它掌握無監督學習的技能。

無監督學習的收益是巨大的,加州大學伯克利分校(UC Berkeley)人工智能研究院(BAIR)所公佈的一項研究成果顯示,通過讓機器人在無監督學習的情況下與環境交互,進而建立一個可預測因果關係的視覺模型,可以讓機器人具備一種“通過模仿及互動模式來學會如何使用工具”的能力,在訓練之後,機器人儘管遇到先前從沒見過的工具,一樣會知道如何使用。

這意味著未來機器人能夠使用多個物體來完成複雜的多對象任務,甚至可以在新場景下使用即興工具,從而構建起真正具有通用智能的機器人。

四、實時強化學習受到追捧

實時機器學習是一項前沿的人工智能研究項目,2017 年才由加州大學伯克利分校教授 Michael I. Jordan 等人給出較為清晰的實時機器學習解決方案,實時強化學習是其中的一個分支,實時強化學習能夠為推薦、營銷系統帶來強大的技術升級,用戶反饋分鐘級回流回來,在線更新模型。

實時強化學習的應用領域非常廣泛,比如說,新聞網站或是電商促銷,每天都有新資訊、新促銷,用戶還在不斷創造內容,可供推薦的內容既在不斷累積,也在不斷變化。模型的準確率來自於對數據的學習,數據變了,自然模型就要變,否則給出的智能推薦,提供的 AI 服務,用戶肯定不滿意,但如果現在還只是 10~30 分鐘做一次的模型更新,未來能做到 1 分鐘之內就更新一次,用戶的滿意度將獲得極大的提高。

隨著實時強化學習的逐漸成熟,未來商業領域能夠做出效益最高的模型,效率最好的架構,而且,以後這些橫型的生成都是機器自動實現的,不需要人工干預,當然,現在的人工智能還都只是“數據智能”,遠未達到“知識智能”的階段,機器還做不了基於知識推理(即缺乏常識),這是做人工智能的人未來幾年要突破的方向。

五、對實時決策的需求推動邊緣人工智能發展

NVIDIA、高通、蘋果及若干初創企業均在開發用於邊緣的人工智能專用芯片,而更多的企業都在試圖在智能手機、汽車甚至可穿戴設備等邊緣設備上運行人工智能算法,而不是跟中心雲平臺或服務器通信,使得邊緣設備具備了在本地處理信息的能力,並且可以更快速地對情況做出響應。

邊緣人工智能對消費者電子、電信、醫療影像等主流行業均有應用意義。比如說在監控攝像頭上運行人臉識別、肩頸識別等人工智能算法,可以快速提供安防威脅識別,如果結合本地數據存儲,則能夠更進一步發現和定位安全威脅嫌疑人,此外,邊緣人工智能在即時駕駛決策、嬰兒監視器、無人機、機器人視覺能力(無互聯網連接)等方面也具有非常積極的價值。

需要指出的是,邊緣人工智能具有減少延遲、快速做出決策的優勢,但也存在計算和存儲能力受限的問題,因此邊緣人工智能未來將與雲端人工智能構成混合模式,從而提供更好的人工智能服務。

六、人工智能正變得性能更高和理解人類

根據斯坦福百年研究(AI 100)發佈的全球“2018 年人工智能指數”(AI Index)報告顯示,就人工智能性能而言,“能力持續飆升”,特別是在計算機視覺等領域。

通過測量廣泛使用的圖像訓練數據庫 ImageNet 的基準性能,該報告發現,啟動可以按照最新精度對圖片進行分類的模型所需的時間從“大約一小時到大約 4 分鐘”下降在短短 18 個月內。這相當於訓練速度大約提高了 16 倍。其他領域,如對象分割,這是軟件區分圖像的背景和主題,在短短三年內,精度提高了 72%。對於機器翻譯和解析等領域,軟件可以理解語法結構,更容易回答問題,準確性和熟練程度越來越高,但隨著算法越來越接近人類對語言的理解,回報越來越低。

與此同時,MIT 媒體實驗室數據顯示,在識別表情方面,計算機已經可以超越人類,對於真笑和苦笑的實驗中,機器學習的成功率是 92%,大幅優於人類。不過雖然情感計算已經深入生活,而要讓機器人更加懂你卻並非易事,還需要人機交互、心理學、認知學等多學科領域共同努力。

基於神經網絡系統的人工智能算法趨勢演進

算法的定義

算法名字的由來源於中世紀一位名叫花拉子米的波斯著名學者。他在 825 年寫成的《印度數字算術》(On the Calculations with Hindu Numbers)對於印度 - 阿拉伯數字系統概念在中東以及歐洲的傳插和推廣起到了關鍵作用。花拉子米拉丁語的譯名為 Algoritmi,算法 algorithm 一詞由此演變而來。

中世紀的拉丁語‘algorismus’指的是四個基本的數學運算:加、減、乘和除法的運算程序和方法體系,但其實早期廣義上的算法並不侷限於數學領域裡的應用實踐,舊時人們用它們來制定各個領域的策略、規則,甚至用於預測未來。例如中國早期歷史裡,“術數”或“數術”,是中華古代神祕文化的精髓所在。

中國古人將自然環境所觀察的變化,與時事、政治和社會的振盪相結合相聯繫,認為兩者之間有著某種內在的關係,而這種關係可以用數術的方法進行歸納和推理。而到了現代社會,由於計算機的發明,術語“算法”的定義與過程、方法和技術這類術語間的模糊概念逐步地區別開來,隱喻地表示遞進的邏輯過程,併成為計算邏輯的核心。

現代算法是從不斷重複出現的現象裡抽象得出的描述事物變化特徵的理想化模型,是一個對空間、時間、資源和運算方法之間的組織;算法是一個問題的解決方案,並把過程拆解劃分成有限地步驟進行方案的實施;更重要的是,算法是一個高度經濟化的過程,它必須要在有限的時間、空間上使用最少量的資源解決問題,同時卻不失其高效和靈活性。

人工智能算法的重要進程(基於神經網絡)

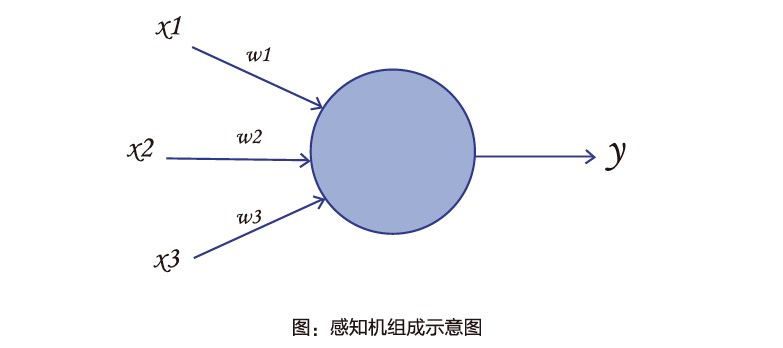

今天,隨著人工智能的廣泛普及和應用,人們傾向於將算法視為以數據為中心的抽象數學思想的應用。在第一次 Al summer 來臨前的黎明期,20 世紀 50 年代,在康奈爾航天航空實驗室裡,科學家 Frank Rosenblatt 設計併發明瞭一款名叫感知機(Perc印tron)的機器學習矩陣神經網絡系統。感知機是一種用於二元線性分類器的監督式學習算法,即是一種可以決定由數字向量表示的輸入是否屬於某種特定分類的函數。

感知機的第一款原型機叫 Mark 1 感知機器,由 20 x 20 組硫化鎘光電池的輸入設備組成,這組輸入設備模擬了類似人類‘視網膜’的作用,目的是通過燈泡的打開或關閉組成一個 400 像素的圖像。機器通過電線連接到一層人工神經元,分解成一個獨立的輸入主體,中間的配置面板基於輸入特徵進行不同權重組合的調節,權重通過電位計進行解碼,並在後續的訓練期間通過電動機進行迭代更新。Perceptron 可以用於訓練識別特定的圖像構造,諸如字母或者三角形等的簡單幾何形狀,確定識別的模式是否屬於特定類別。感知機的出現使單個神經元的訓練得到了可能,為後期神經網絡學習和目前非常流行的深度學習算法的發展方向奠定了重要的基礎。

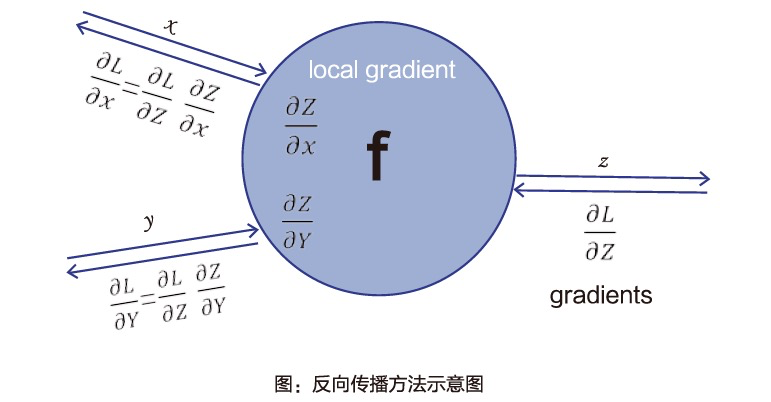

單層的感知機解決了簡單的輸入和輸出線性配對關係的學習問題,但是一個最重要的缺陷是這種低維度的特徵關係抽取無法表徵兩者之間非線性的關係模式。為了解決這個難題 Hinton 在 1986 年提出了分佈式表示(Distributed Representation)的概念。

其核心思想指每一個輸入單元都應該由多個特徵所表示,並且每一個特徵都應該和其他可能輸入的表示產生聯結作用,描述特定特徵的神經元應該從所有相關的輸入單元(圖像)中進行學習而不僅僅是從一個特定類別的單元(圖像)中訓練而來。為了達到這種基於深層次網絡內部表示作用的學習效果,反向傳播算法(BackwardPropagation)應運而生,它是一種高效地訓練多層神經網絡的方法,學習合適的內部表示進而學習任意的輸入到輸出的映射關係。

反向傳播方法一經發表就得到了學術界的關注和廣泛應用,並在多向任務建模的方面取得了重要的進展。然而彼時人工智能正處於其歷史進程中第二次浪潮的尾期,隨著 90 年代初期 Apple 和 IBM 通用計算機的興起,以 XCON 為首的 AI 為主程序的專家系統的沒落,人工智能商業界高投資、高期望、低迴報、低交付的現象愈發嚴重,整個投資和媒體界人士紛紛表示對人工智能的失望,導致該領域的大量撤資。到了 21 世紀初,互聯網的高速發展成功激活了人工智能第三次浪潮迴歸的 3 個重要因素,它們分別為:

- 海量數據積累和指數級數據體量增長;

- 數據存儲成本的大幅下降;

- 處理器產業不斷成熟導致算力性能的明顯提升。

不同於前兩次 AI ‘春天’,深度學習網絡在模型表現和商業應用都遠遠優於與之競爭的基於其他機器學習技術或手動設計功能的 AI 系統,亦稱為了第三次 AI 浪潮發展最顯著特徵之一。關於深度學習的發展和應用,我們會在下一小節做著重探討。

以深度學習為主特點的人工智能第三次浪潮

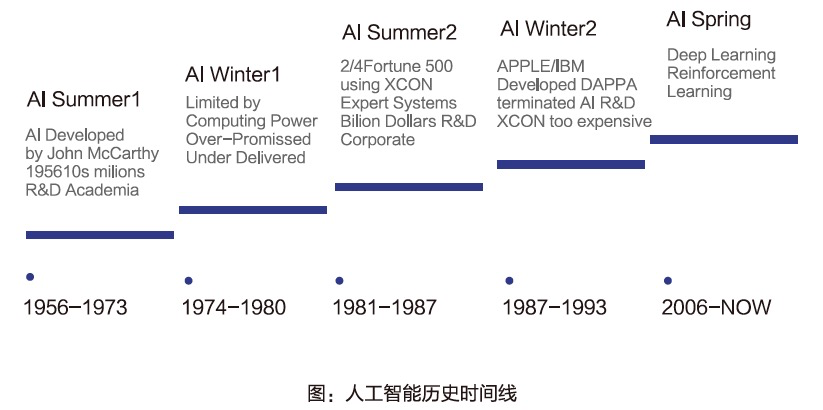

追溯人工智能的現代史,'ArtificiaIlntelligence'這一術語是在 1956 年達特茅斯學院夏季學術大會上,由美國計算機和認知科學家 John McCarthy 第一次提出,研討會本身意義重大,被業內普遍視為人工智能作為一門研究學科的創立,1956 年也稱為 AI 元年。早期開創 AI 的先驅者對 AI 的定義、研究方法和發展方向展開了極其熱烈的討論,他們認為 AI 的初衷是由機器模擬人類、動植物和物種種群的演變行為,任何領域的學習過程或任何智能的表徵特點理論上都可以被機器精準地模擬出來。

英國計算機與人工智能鼻祖 Alan Turing 提出了機器智能領域裡兩個重要的學術問題:

- 機器能否模仿人腦的認知、思考、推理和解決問題的能力?

- 如果可以,如何判斷機器具備以上所述的所有能力?

同時還提出了非常有益的人工智能發展建議,他認為與其設計類似於成人 IQ 思維的機器體系,不如製造一個更簡單的系統,類似孩童一般,通過不斷地學習、不斷地成長,從而被一步步訓練成更智能的綜合系統,而這一理念深深嵌入到現代人工智能、機器學習算法的核心設計思想裡。

歷史上,人工智能歷經了兩次跌宕起伏的發展時期,分別為 1956一1987 年,1981一1987 年,AI 發展的兩次上升期;及 1974一1980 年,1987一1993 年,AI 發展的兩次寒冬期。第一次寒冬期始於英國萊特希爾教授(SirJames LighthiII)在 1973 年其人工智能普育報告的發佈,報告中表達了對先前的 AI 投資未能產生預期收益的失望並呼籲人們終止對 AI 的過度期望和無理性的資本輸入2。第二次寒冬期源於桌面電腦的迅速崛起,工業界、產業界對 AI 的興趣衰減,同時 AI 系統升級維護成本又過於昂貴,導致 AI 產業投資性價比的顯著下降。然而一線的科研仍在繼續,提及 AI 的人越來越少,取而代之的是機器學習、基於知識的模式識別等學術術語開始湧現。然而在 90 年代開始,人工智能已經開始無聲無息地成功翮入到成千上萬的系統中去。

以深度學習為主特點的 AI 第三次浪潮

關於第三次 AI 浪潮迴歸的起點眾說紛紜,學界認為人工智能第三次浪潮源於 2006 年 Geoffery Hinton 表明“深度信念網絡”(Deep BeIieve Network)可以被一種名為“貪婪逐層預訓練(Greedylayer—wisepre-training)”的策略進行高效訓練快速收斂的理論。這種訓練策略的出現使得之前不可能被有效訓練地深度神經網絡變得可被訓練,大大提升了模型訓練效率和輸出的準確性,從而認證了深度學習,這一概念的可行性。

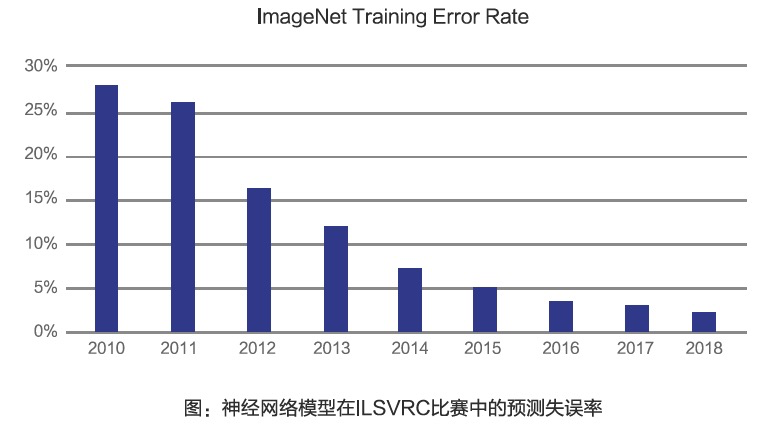

行業界認為人工智能的第三次復興應追溯到 2012 年的《mageNet 挑戰賽,GeofferyHinton 和其學生 AIex Knzhevsky 研發了一種名叫 AlexNet 的深度神經網絡,在挑戰賽中成功地將圖片識別錯誤率降低了 10.8 個百分點。

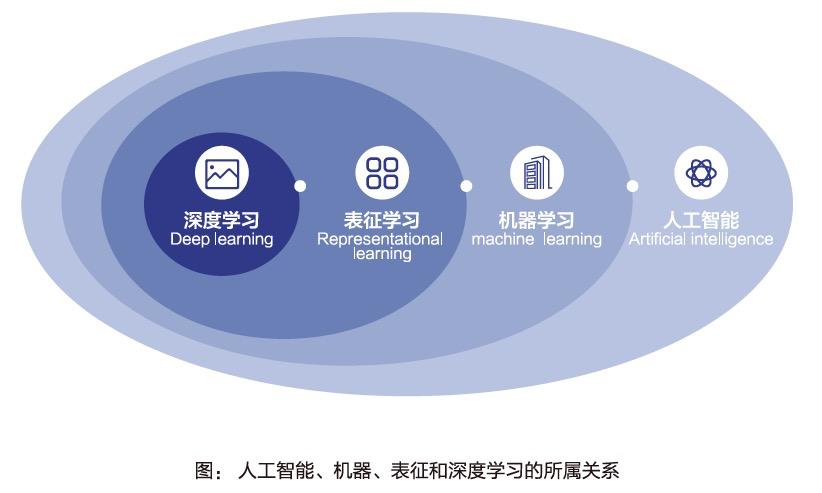

深度學習又是如何定義呢?它是機器學習中一種基於對數據進行表徵學習的方法。表徵學習指使用機器學習的方法挖掘定義輸入數據特性的表示特徵本身,而不僅僅只是簡單地提取表示做輸入和輸出之間的關係映射。人工智能、機器學習、表徵學習和深度學習之間是包含與被包含的所屬關係。

和 20 世紀 90 年代的系統做對比,21 世紀的深度學習模型有著三個顯著特點,

- 系統規模及複雜性;

- 過程訓練高效性,

- 結果預測準確性。

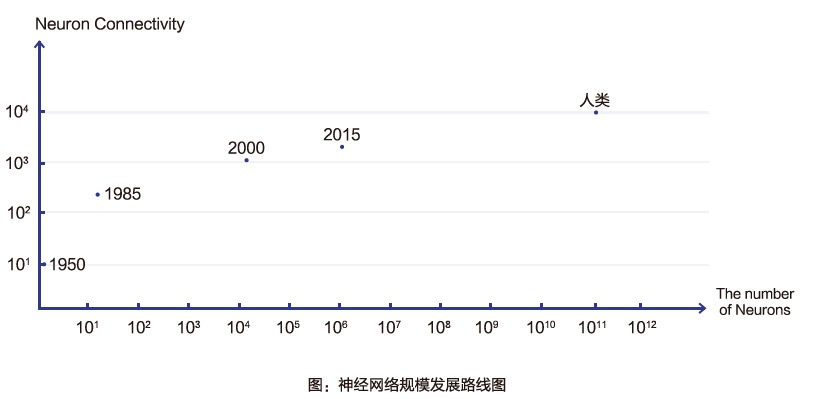

2000 年以後深度學習模型的總體規模經過 50 年的迭代後發生了很大程度的躍遷。除了上文所述的“貪婪逐層預訓練”的機制讓深度學習網絡的訓練變得更可行之外,第三次浪潮中深度學習的成功很大程度上依賴於其算法模型的規模指數級升級。模型規模取決於深度學習中層體(隱藏層)的深度以及每層神經元的聯結綢密度。2015 年後,模型中神經元連接的數量級(10 的三次方)已經可以匹配於較小的哺乳動物(老鼠),離人類神經元的規模(>10 的四次方)還有一定距離。而就神經元總數來說,深度模型目前從 1985 的蛔蟲水平(>10 的二次方)跨越到了蜜蜂的量級(10 的六次方),但與人類規模還相差甚遠(>10 的十一次方)。更大體量的網絡、更高密度的系統可以在真實環境中處理更復雜的問題並得出更精準的結論。這種規模的增長是以更大的存儲空間、更快的計算速度作為底層技術支撐和驅動的。從 20 世紀 50 年代開始,系統通過不斷地演化提高性能(下圖),科學家推測按照目前這種進化速度,到本世紀 50 年代,神經網絡能具備與人腦相同數量級別的神經元與連接稠密程度。

隨著深度學習模型越來越複雜,其識別、分類和預測的精確度也得到顯著提升。在大型視覺識別挑戰賽(ILSVRC)中,深度學習模型取得了引人注目的成功,圖像識別錯誤率也從 2010 年的 28% 下降到如今的 23%,於 2015 年後就超過了人為識別錯誤率(5%)。與此同時,整體模型的訓練時間也大幅度縮減,短短 1 年半左右的時間就從 60 分鐘下降到 4 分鐘左右,提升了接近 15 倍左右的程序運行效能。

深度學習不僅僅在機器視覺應用中起到了關鍵性作用,也在人工智能的其他領域產生了巨大的影響,如語音識別、機器翻譯和強化學習等其他複雜的學習任務。因為其出色的表現,深度學習已經成為現今人工智能學者主要的研究領域;我們可以預料到在未來深度學習的發展機遇與挑戰並存,模型的進一步提升、如何與垂直行業知識融合進而更廣泛應用於其他新型領域,是深度學習未來幾年時間裡的重點發展方向。

人工智能算力的發展趨勢與洞察

在數字經濟時代,技術的革新與承載它的算力密切相關,人工智能也不例外,數據、算法和算力構成了人工智能的三大要素,而正是算力上的爆發,讓人工智能在 1956 年達特茅斯會議之後近 60 年,形成了如今的第三次爆發。

1986年,DavidE.Rumelhart,GeoffreyE.Hinton和RonaldJ.Williams 發表文章《Learningrepresentationsbyback—propagatingerrors》,在時隔 12 年後重提 BP 神經網絡學習算法(BP 即反向傳播,Backpropaga-tion,BP,這是一種與最優化方法(如梯度下降法)結合使用的,用來訓練人工神經網絡的常見方法。

BP 算法是如今人工智能領域深度學習神經網絡的重要突破之一,被谷歌高級研究員 JeffDean 稱之為“深度神經網絡是現代計算機科學一些重大進步的促成因素,幫助計算機視覺、語音識別和自然語言理解方面的長期問題上取得了實質性進展,深度神經網絡不僅改變了計算領域,而且幾乎改變了科學和人類努力的每一個領域。

但無論是 BP 算法還是十年後與卡斯帕羅夫展開歷史上首次“人機大戰"的 Deep Blue,人工智能在當時嚴審的受到了算力不足的影響,事實上,即使是 20 年Geoffrey E.Hinton 正式提供深度學習並進行實證,算力不足仍然困擾著人工智能業界。

很多人工智能業界的專家認為.在弱人工智毹時代(現階段),算力是最重要的人工智能發展影響因素,DeepMind 傑出研究科學家 RichardS.Sutton 就認為,利用算力才是王道,在其基礎上搜索和算法才能帶來技術水平的長期提升。

他認為,AI 研究人員常常試圖在自身智能體中構建知識,從短期看,這通常是有幫助的,能夠令研究人員滿意,但從長遠看,這會令研究人員停滯不前,甚至即制進一步發展,突破性進展最終可能會通過一種相反的方法一一基於以大規模計篡為基礎的搜索和學習。最後的成功往往帶有絲苦澀,並且無法完全消化,因為這種成功不是通過一種令人喜歡、以人為中心的方法獲得的:“通用方法非常強大,這類方法會隨著算力的增加而繼續擴展,即使可計算變得非常大。搜索和學習似乎正是兩種以這種方式隨意擴展的方法。

當然,許多業界專家與 RichardS.Sutton 的想法存在差異,但算力的重要性毋庸置疑,而近年來,與人工智能相關的算力也確實得到的長足的進展,並呈現出一定的趨勢。

人工智能算力需求暴,異構計算成為主流

根據 IDC 公佈的《2018 年中國 AI 基礎架構市場調報告》顯示,2018 年中國 AI基架構市場銷同比增幅高達 132%,整體售達到 13.18 億芰元。此外,根據 OpenAl 的分析報告,從 2012 年開始,AI 訓練所用的計算量呈現指數長,平均每 3.43 個月便會翻倍,截止目前計算量擴大了 30 萬倍。到 2020 年前,AI 需的計算量預計還會繼續增長 12 倍。

隨著算力求的暴增。對算力的合理利用和不同計算單元的協作就變得日益重要,將CPU、DSP、GPU、ASIC、協處型器、FPGA 等各種計單元、使用不同的類型指令集、不同的體系架構的計算單元組成一個混合的系統執行計算,計每一種不同類型的計算單元都可以執行自己最擅長的任務,從而大度提高人工智能計算的效率和速度。

總的來說,不同處理器芯片在構建異構計算方面有著自己的鮮月特點。CPU、GPU 領域存在大量的開源軟件和應用軟件,任何新的技術首先會用 CPU 實現算法,因此 CPU 編程的資源豐富而且容易獲得,開發成本低而開發週期。

FPGA 的實現採用 Verilog/VHDL 等底層硬件描述語言實現,需要開發者對 FPGA 的芯片特性有較為深入的瞭解,但其高並行性的特性往往可以使業務性能得到量級的提升;同時 FPGA 是動態可重配的,當在數據中心部署之後,可以根據業務形態來配置不同的邏輯實現不同的硬件加速功能。

ASIC 芯片可以獲得最優的性能,即面積利用率高、速度快、功耗低:但是 ASIC 開發風險極大,需要有足夠大的市場來保證成本價格,而且從研發到市場的時間週期很長,不適合例如深度學習 CNN 等算法正在快速迭代的領域。

GPU 仍然是人工智能計算的主要算力供給

同樣據《2018 年中國 AI 基礎架掬市場調點報告》顯示,2018 年 GPU 服務器繼續保持高速增長,銷售同比大增 131.2%, 仍然是 AI 基礎架構領域的主流,銷售額佔比達到99%。

其中,近 8 成銷售額來自於 4 卡以上 GPU 服務器,佔比達到 80.4%;16 卡 GPU 服務器亳長迅猛,銷售額從 2017 年的 2090 萬美元增長到 2018 年的 2.63 億美元,同比增速高達 1161.7%,在 GPU 服務器整體份額中的比例從 2017 年的 3.7% 快速攀升至 2018 年的 20.4%。

值得注意的是,越來越多的人工智能計算服務器開始試用 8 GPU 甚至 16 GPU 卡,這意味著隨著數據的爆發式增長、深度神經網絡日趨複雜,單系統可提供更高密度、更高性能的 AI 基礎架構,將在 AI 線下訓練場景中得到更廣泛應用。此外,IDC 的數據顯示,用於線上推理場景的加速卡在 2018 年實現了快速長。IDC 數倨顯示,GPU 中的 M4、P4、T4 銷售額從 2017 年的 4810 萬美元,增長到 2018 年的 3.6 億美元,份額佔比從 8.5% 提升到 27.6%。

此外,GPU 計算正朝著"Non — CPU"方向發展,即不需要計算系統中使用 CPU,用戶可構建起完全由 GPU 組成的計系統。

傳統高性能計算正在與人工智能合為“先進計算”

Hyperion Research 的分析師 Steve Conway 認為,以深度學習為代表的人工智能研究和應用正在將那些“並不真正瞭解 HPC 的公司和組織,推向 HPC 的領域,而他們對此一無所知”。

事實上,現在有可用的大型數椐集合(由於我們社會的數字化)和強大的計算資源,這樣的組合允許這個領域取得很大的進步。人工智能(特別是機器學習和深度學習)需要龐大的計算資源,隨著數椐的長,計算力變得越來越要,只有擁有更好的、與人工智能計算(特別是深度學習計算)相匹配的計的系統(比如提供 GPU 計算能力或是深度學習算法架平臺)才能更好的訓練(深度學習)模型。這一計算系統正是先進計的系統。

因此,AI 需要藉助先進計算力量,或者說“AI 站在先進計算的肩膀上會走的更遠”,事實上,類以的嘗試早在傳統超算領域就已經被證明是可行的:20 世紀 90 年代初,美國華盛頓的喬治梅森大學醫院就經常使用他們的 Cray 超級計算機來幫助監測乳腺癌,經過訓練,在傳統超算上能夠針對 × 光片識別出被稱為“微鈣化“的早期指標,而且優於人的能力—針對傳傳統算、大數據分析處理和人工智能計算的新一代先進計算中心,顯然會是更好的支撐。

此外,荑國計劃在 2021 年建成的 E 級計算系統Aurora 據 DOE 所披露的信息顯示,就已經是一個先進計算系統,它不僅僅是隻支持運行計算密集型應用的傳統超算,它也將支持或者說針對數據密集型分析應用進行優化(預計也會包括針對深度學習的優化),渙句適說,Aurora 是一個可以支持 AI 代碼的先計算系統,它將支深度學習工乍負載。

邊緣人工智能算力持續提升

隨著聯網邊緣設備對人工智能能力的要求不斷提升,對即時、高吞吐量的邊緣人工智能算力的需求也在持續增加,邊緣設備需要藉助人工智能及與之相匹配的算力,及時做出分析、判斷和決策。與此同時,2025 年,預計將會有 1500 億臺機器傳感器和物聯網設備持續輸出數據,這比當今使智能手機的個人用戶所產生的數要高出幾個數量級,因此,無論是市場規模還是算力需求規模都極為龐大。

希捷在製造工廠部署了基於 GPU 的智能邊緣視覺解決方案,以對硬盤讀寫磁頭的質量進行檢測。其所部署的NVIDIA EGX 平臺能夠在邊緣實現推理的大幅加速,使希捷的工廠管理人員能夠看到過去人類操作員無法看到的細微缺陷。高性能的邊緣人工智能算力讓希捷的工廠有望通過更高的效率和質量,實現高達 10% 的製造吞吐量提升和高達 300% 的投資回報率。

第三次人工智能浪潮的主流就是基於大數據量,利用深度學習(包括機器學習,以下同)算法,挖掘數據中存在的有用信息,並找到深層的邏輯關係,其處理的數據越多,深度學習就越能體現出優勢,特別是在算法還未完全成熟、仍然處在持續迭代的階段(比如弱人工智能),以前很多用機器學習解決不了或處理不好的問題,通過提供大數據能夠得到很好解決或性能的大幅提升。

隨著信息化、數字化,以及物聯網、智能設備、移動互聯網的深入推進,越來越多的物理世界和數字世界的數據被沉澱出來,讓深度學習有了足夠多的數據樣本,從而能夠不斷的從數據中學習知識,提升智能水平。毫無疑問,在數據量非常小的時候1深度學習的複雜網絡往往無法取得很好的效果。

但數據卻並非一種取之不盡用之不竭的資源,即使是數據具備可再生性(即源源不斷的產出),人工智能所需要的數據仍然相當昂貴和耗時,一方面,深度學習需要準確標記的圖像或文本訓練數據,而數據標記需要大量的人力工作;另一方面,許多數據存在著隱私和安全風險,比如說醫療、教育和公共事務數據,就存在著數據獲取難的問題。

隨著深度學習技術的發展與應用,數據孤島、數據隱私(數據安全)、小數據集和數據缺失(數據集不完整及數據標記缺失)等問題變得日益凸顯,當前人工智能進一步發展,必須要解決數據的挑戰,找到在當前的數據狀態下持續發展的方法一一這就是人工智能專家吳恩達所提出的問題:“數據當然是越多越好,我也並沒有說許多數據是無用數據。但是,在農業、製造、醫療等領域的部分應用場景中,如果你手頭只有 100 張照片,怎麼辦呢?”

“小數據,大智能”,是用小數據集準動人工智能技術能力提升和產業應用發展是一個非常重要的課題,在這一領域已經有了一定的探索。

一、聯邦學習(FederatedLearning)

2016 年由谷歌提出,當時主要是為了解決 Android 智能手機用戶在本地的模型更新挑戰,其設計目標是在保障大數據交換時的信息安全、保護終端數據和個人數據隱私、保證合法合規的前提下,在多參與方或多計算結點之間開展高效率的機器學習,即在用敏感用戶數據訓練人工智能的同時保護隱私。

在谷歌所提出的聯邦學習中,用戶的數據仍然保留在用戶的智能手機上,不會存儲或發送到外部,而是由雲服務器將最新版的算法(算法的“全局狀態”)發往機選擇的用戶設備上,用戶的手機做出改進然後基於本地化的數據對模型進行更新。之後只有這種更新(以及來自其他戶的更新)會回傳給雲服務器以改善該“全局狀態”,然後再不斷重複這一過程。聯邦學習所要達成效果,就是在不共享隱私數據的情況下,進行協同的訓練,而且實現與過去相同的訓練水平。

簡單來說,聯邦學習不需要匯聚模型訓練所需的數據進行集中計算,而是分散學習的計算到參與各方的數據庫上進行加密的分佈式計算。數據持有方 A 和數據持有方 B 共同擁有模型的一部分,模型 A 和模型 B 加起來,才是一個完整的模型,通過加密模型訓練(包括傳遞關遭參數)得最終的優化模型。

在這其中,同態加密技術是聯邦學習的關誕,它確保整個模型訓練過程自始自終、沒有任何原始數據和原始數據的加密/脫敏數據被傳輸,從而保護了數據擁有者各自的隱私。很顯然,如果能夠保證個人及企業的數據隱私,那麼更多的數據就能夠被“釋放”出來用以進行深度學習訓練,因此,雖然聯邦學習並非百分百意義上的“小數據集訓練”,但仍然能夠在一定程度上解決人工智能的數據需求問題。

二、合成訓練數據

沒有訓練數據,沒有大規模的標籤數據集,那麼就儘可能逼真的仿造數據,這就是合成訓練數據,但這並非是毫無根據的仿造,合成的訓練數據一定是高精度、高可信度的,可以精確地模擬現實場景和現實事物。

英偉達在 2018 年 3 月推出 DRIVE ConstelIation 仿真系統,用以生成在虛擬世界中車輛行駛的傳感器結果。該系統所運行的模擬軟件,可以模擬從攝像頭到激光雷達和普通雷達均包括在內的自動駕駛汽車的各種傳感器,利強大的計算力生成逼真數據流,從而創建各種測試環境和場景。這意味著您可以在晝夜不同時間針對罕見和難以實現的條件〔暴雨、暴風雪和強烈眩光)以及不同的路面和周圍環境輕鬆地進行測試。

比如說,在模擬器中,可以設置模擬車輛遇到極端天氣,這一系統就會模擬所有車載傳感器在當時所有可能產生的數據,這些數據被當做真實發生的數據進行合成並提供給自動駕駛車輛的決策系統,從而測試自動駕駛車輛對數據的反饋及駕駛行為。

此外,利用生成對抗網絡(GAN)生成或增強現實世界數據,利用混合現實世界和模擬數據來進行訓練,從而形成更大規模更多樣化的數據集,也是當前合成訓練數據領域正在進行的工作。

三、遷移學習

“觸類旁誦”可能是最適合描述遷移學習的成語,這是一種誦過從已學習的相關任務中轉移知識來改進學習的新學習方式,比如說,用於識別蘋果的訓練成果可能會有助於識別梨,遷移學習強調不同領域之間誦過知識遷移,來完成原本較難完成的任務,從而在缺乏已標記數據時,利用遷移學習藉助於其他相關領域的知識,來幫助訓練更具有泛化能力的模型。

傳統的訓練過程,更像是“單打獨鬥”,試圖單獨學習每一個任務,建立獨立的知識體系,並會生成多個具有縱向垂直能力的學習模型;在遷移學習中,是試圖將在前幾個任務上學到的知識轉移到目前的學習任務上,從而將其結合起來。2016 年,吳恩達在 NIPS 2016 大會上提出遷移學習是機器學習獲得商業上的成功的下一個動力。

雲計算,基礎設施與能力賦能平臺

雲計算成為數字經濟發展的重要基礎設施,也是人工智能發展的重要基礎。相比工業經濟,新數字經濟的重要特徵是以數據為重要的生產資料,以雲計算、大數據和人工智能技術為主要生產力,以互聯網和移動互聯網為主要生產關係,以數字世界的數據智能技術與物理世界和實體經濟的深度合,讓數據創造出新價值。雲計算作為驅動數字經濟技術發展的心贓,作為數字經濟的基礎設施,併為人工智能發展提供強大的算力支持以及數據存儲資源。

雲計算成為各行業數字化轉型的重要賦能平臺。近 10 年來,我們看到以雲計算為基礎的技術浪潮,裹挾著人工智能,大數據,區塊鏈、邊緣計算,工業互聯網,互聯網汽車,新智慧城市等新技術和新應用席捲而來,驅動各行各業數字化轉型。根據艾媒諮詢發佈的《2018 年中國雲計算行業發展報告》預測,到 2019 年,中國雲計算行業的產業規模將達 4300 億元。

當前,雲原生架構基本完成了 IT 架構在雲計篡時代的進化升級。以輕量級的容器、鬆散耦合的微服務、通過 API 進行交互協作,通過 DevOps 流程進行管理的為代表的雲原生技術以其高效定、快速響應的特點驅動引領企業的業務發展,幫助企業構建更加適用於雲上的應服務。對企業而言,新舊 IT 架構的轉型與企業數字化的迫切需求也為雲原生技術提供了很好的契機,雲原生技術在行業的應用持續深化。

在工業領域,依託雲計算的工業互聯網平臺加涑製造企業數字化轉型。數據智能技術以雲計算為載體,加速工業互聯網的發展。2017 年,國務院發佈《關於深化“互聯網+先進製造業”發展工業互聯網的指導意見》,指出工業互聯網作為新一代信息技術與製造業深度合的產物,日益成為新工業革命的關鍵支撐和深化“互聯網+先進製造業”的重要基。從產業發展來看,至 2020 年,政府和傳統企業的數字化轉型仍將是 IT 產業的主旋律,從消費互聯網到產業互聯網的演進是數字經濟的創新主戰場。層出不窮的創新技術將漸次入科技浪潮中,轉化成無數靈活可用的新產品,雲計算作為信息科技領域的水電煤,其公共屬性將愈發明顯,在這場科技變革中將發揮更為關鍵的作用。

在智慧城市領域,以雲計算作為基礎設施的城市智能化轉型進入爆發階段,類腦巨系統的應用在中國突然爆發。進入集中建設階段的智慧城市建設為雲計算帶來廣活市場,同時推動電子政務、民生應等領域的雲計算應用。以阿里雲城市大腦為例,經過 2016一2018 的發展,阿里城市大腦已經在杭州、蘇州、上海、衢州、澳門、海南等地相繼落地智慧城市項目。

雲計算根據服務交付 IT 資源的不同,包括計算、存儲、網絡、數據、應用等,可以分成三種服務形態:基礎架構即服務(IaaS)、平臺即服務(PaaS)和軟件即服務(SaaS)。

IaaS 是用戶利用軟件虛擬化和自動化部署等技術,通過高速互聯網遠程訪問雲服務商提供的計算、儲存和網絡資源。用戶可以免去機房場地,計算機維護的麻煩,降低原始的 IT 軟硬件投資和人力成本。“飛天"就是阿里雲自主研發的雲計算操作系統,可將全球數百萬臺服務器連成一臺超級計算機,經受住“雙11”海量訪問需求的考驗,為社會提供普惠的計算能力。

PaaS 是用戶利用 PaaS 平臺的資源就可以創建自己的應用軟件,開發後的軟件可以直接運行在 PaaS 平臺上。由於無需自己購買硬件搭建開發平平臺,可以縮減軟件開發的週期和成本。阿里雲機器學習平臺PA《(Patform of ArtificiaI lntelligence)就是一種人工智能的 PaaS 平臺,為傳統機器學習和深度學習提供了從數據處理、模型訓練、服務部署到預測的一站式服務,打造人人都能用得起的機器學習平臺。

SaaS 是用戶通過互聯網瀏覽器直接獲得軟件應的服務,大大壓縮了安裝和維護成本,為用戶提供終極的便利體驗。GoogIe 的 GmaiI、SaIesforce 的在線 CRM 都是這種模式的典型應用。淘寶平臺上商家直接訂購的軟件服務商的各種店鋪應用,也是一種 SaaS 應的模式。釘釘也是一種為中小企業提供移動辦公和組織協同的企業即時通信 SaaS 應用。

從物理服務器的所屬權來區分,雲計算還可以分為公共雲,專有云和混合雲。公共雲就是戶不擁有云計算的物理服務器,直接使雲服務。專有云是企業在組織內部構建的雲計算服務,擁有物理服務器的所有權。混合雲則是上述一種二者兼而有之的融合狀態。

公有云是真正具備的成本相對低廉、按需使用、即插即用和彈性擴容的這雲計算的優點。從長遠來看,雲計算的發展會像電力的發展進程一樣,企業的專有云就像工廠自建的發電站只是作為應急之用,公有云就像現在的發電廠為正整個社會提供廉價稔定的普惠計算服務。

在數字經濟時代,任何人、任何行業都需要用雲計算。今天,我打開手機淘寶,用支付寶掃二維碼都是雲計算再給我們提供服務。沒有云計算就沒有今天普惠的數據智能服務。同樣,雲計算帶來數字生產力的提升,不用雲計算就像在工業時代不電一樣,會在數字經濟時代的市場竟爭中處於劣勢地位。