今年因為廣州疫情爆發,沒能到現場參加阿里雲峰會,只能線下看直播,從雲原生,數據治理到AI開發範式,智能運維,低代碼開發,無不揭示了雲給大家帶來的價值。可以看到今年所有主題的核心都是圍繞如何為開發者構建高效的範式和架構支撐軟件開發迭代,這也算是迴歸了雲的初心。

從阿里一站式AI平臺看清MLOps

雖然這次峰會涉及的主題很多,但最讓我感興趣的還是賈老師的“雲上大數據與AI開發範式的演進”,因為AI後半段是拼地是工程落地能力,如何快速並準確地完成數據治理和模型迭代不僅需要NB的算法人員和方法輪,還需要有完善基礎設施,不然只能是小作坊式作業。

學過近代史的都知道,小作坊的效率是永遠比不過工業化革命的大工廠的,那麼如何從小作坊變成高效的算法工廠呢?拆解開來,核心是三大塊:

- 數據治理

- 算法探索

- 流程範式

為什麼是這三塊呢?其實從阿里雲AI平臺的佈局可以看到,通過大數據與AI一體化平臺來推動作為一起模型訓練根源的數據治理工作,通過推出快速體驗的雲端 Jupyter 平臺為算法人員快速探索算法,和通過打通機器學習全鏈路的PAI平臺將AI工程化能以一種標準的流程範式的形式進行快速落地。

全鏈路數據治理

數據治理可以說是AI大規模落地的最大障礙也不為過。每個公司做算法工程落地地時候發現最多的工作都耗費在各種 kafka 的對接,數據集成,數據加工,數據清洗,數據核驗上面,而圍繞著開發效率優先的工作模式下數據體系快速腐化就變成了一個不可避免的事實了。

數據治理核心是提升數據服務的效率,將工程人員從數據的漩渦中拯救出來,而不是每天面對數據做各種低價值工作。

算法探索神器notebook

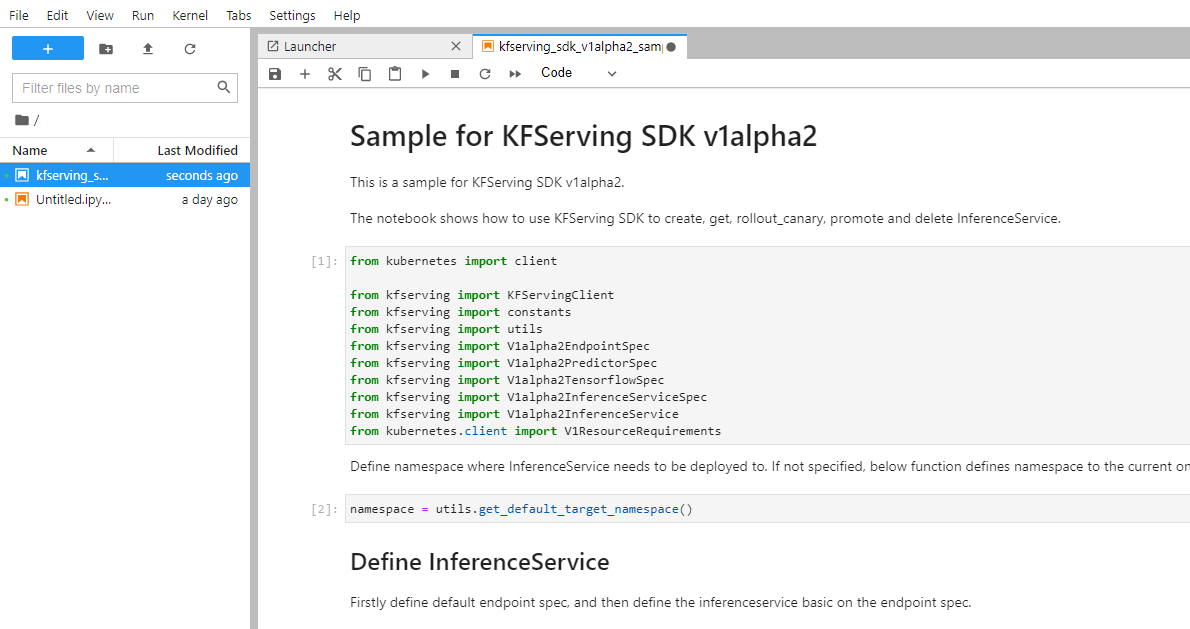

相信每個算法開發,甚至大部分 python 開發人員都使用過 jupyter notebook 這款 web IDE,可以說這款 IDE 把交互式地優勢發揮到極致了,

今天賈老師提出 jupyter web server 的概念其實一點都不奇怪,不管是 google 一直在推的 colab,還是kubeflow 的 jupyter server,本質都是這樣的產品,甚至jupyter server 的功能很早就作為 kubeflow 其除 pipeline 工作流以外最核心的賣點。

一個隨時能使用的算法開發環境,這一定是每個算法人員的剛需,同時也是最適合和雲技術結合的,利用雲原生技術可以為算法人員在任何時候提供一個具有足夠資源的完整開發環境,快速開始開發。這確實切入了很多算法人員的痛點。

AI流程範式

說到PAI平臺,其實還瞞感慨的,因為16年的時候當時自己也帶團隊做過一個大數據的可視化建模平臺,當時就是參照了PAI平臺的界面進行的產品設計,不過這幾年 PAI 平臺的快速發展已經完全不是當年那個只是具有拖拉拽功能的大數據機器學習建模平臺了,逐漸變成一個集可視化建模、交互式建模、彈性推理服務為一體的 MLOps 平臺。

特別是和雲原生的結合,讓她在給開發者賦能上提供了更多地可能性,其實當年在做可視化平臺的時候這個問題就暴露出來,就是完全的可視化操作在靈活性上和適應性上是很差的,這也是為什麼這幾年低代碼平臺興起的緣故。

這裡做個大膽地預測,後面阿里雲 PAI 平臺應該會引進 git 的版本管理,徹底將算法工程化全流程打通,通過提供全流程的高效開發為AI工程化鋪路。