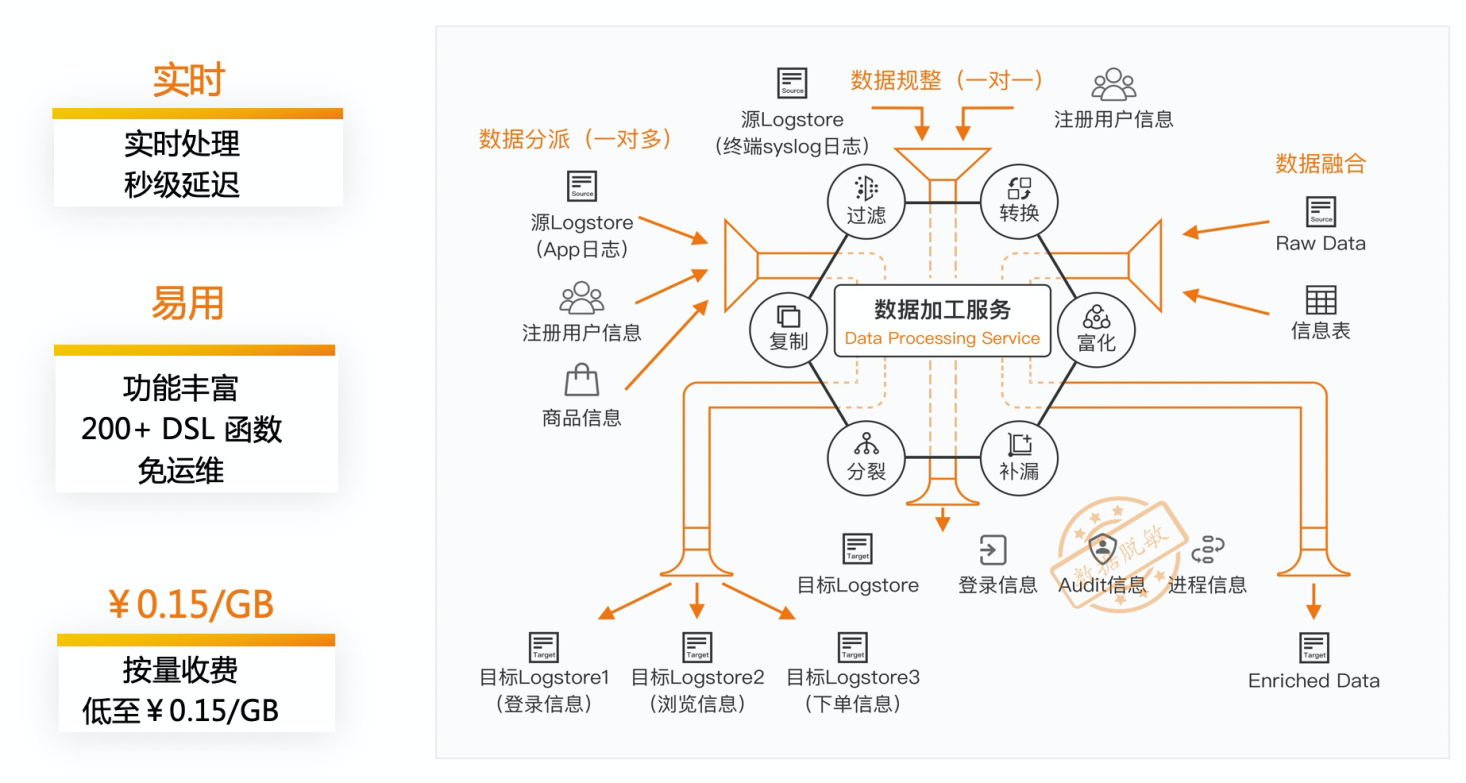

數據加工簡介

數據加工是阿里雲SLS推出的一項Serverless的功能,主要解決日誌行實時處理的場景,目前提供了200+的DSL算子。 詳細的加工介紹請參考https://help.aliyun.com/document_detail/125384.html

Logstore日誌流轉常見的場景

日誌流轉案例 - logstore日誌字段過濾複製

案例

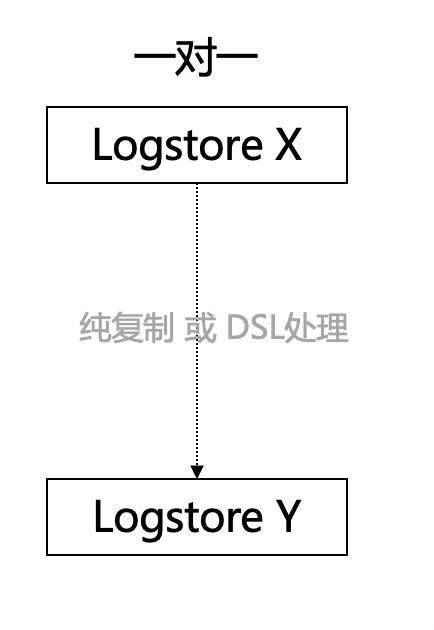

A部門有一份敏感日誌,由於業務需要, B部門需要訪問A部門的日誌中的部分字段。為了安全起見,A部門可以使用數據加工實現Logstore對拷, 並過濾掉敏感字段,並且使用RAM授權的方式,給B部門授權

解決方案

使用數據加工 一對一拷貝的功能,並且使用DSL語句進行一定字段的過濾

加工語句範例

e_keep_fields("filed1","field2",regex=False)日誌流轉案例 - 多種格式揉雜的logstore,日誌拆分

案例

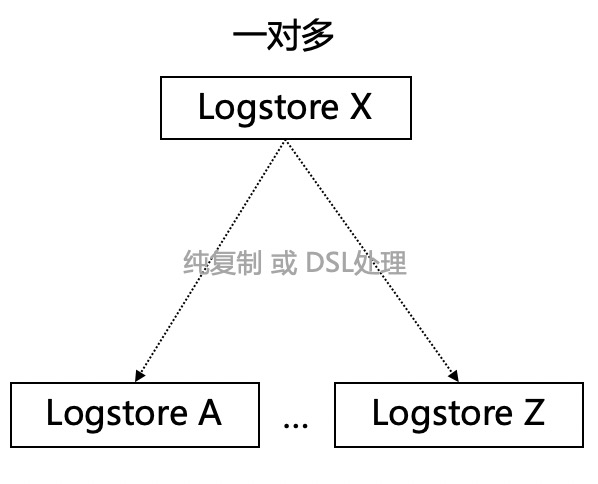

服務A有一份日誌,應用程序打的日誌格式並不統一。

當有關鍵詞xx的時候,具備格式 x

當有關鍵詞yy的時候,具備格式 y

由於格式差異較大,冗雜在一個logstore裡不利於搜索查詢; 比如最後需要投遞到oss數據湖進行進一步查詢分析

解決方案

使用數據加工一對多的分發能力可以解決以上問題

加工語句範例

e_if(e_match("http_code", "500"), e_output(name="logstore1"))

e_if(e_match("http_code", "200"), e_output(name="logstore2"))

e_drop()日誌流轉案例 - 跨Region複製

案例

公司的業務在各個Region都有部署,查詢logstore的時候,需要到不同Project下進行查詢,給開發運維帶來不便。

使用數據加工將logstore 跨Region寫出到中心化的logstore

解決方案

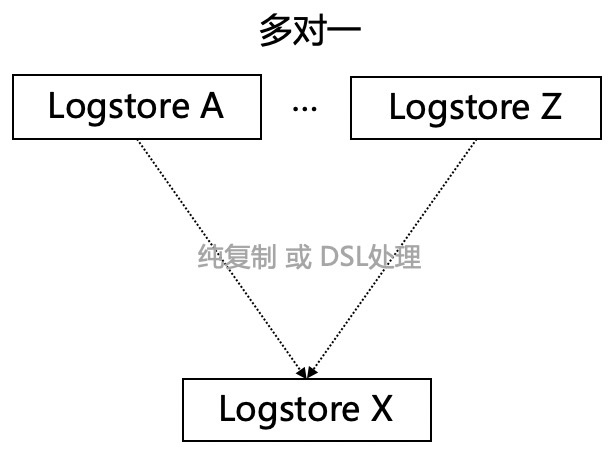

使用數據加工跨Region傳輸的能力,進行多對一的logstore複製

加工語句範例

加工語句直接為空,配置時設定好目標logstore即可

小結

使用數據加工對logstore進行數據流轉,具備以下幾點能力(可根據業務場景進行任意組合)

- 支持流轉時數據處理(轉化、過濾、富化等,200+DSL函數)

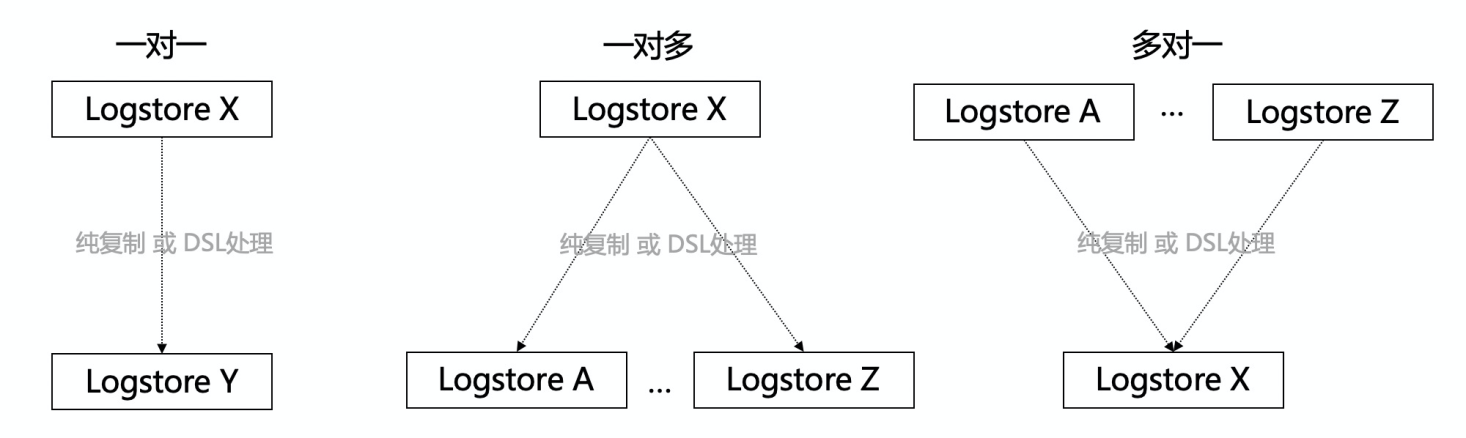

- 支持一對一、一對多、多對一進行流轉

- 支持同一個賬號、跨賬號的場景

- 支持同Region、跨Region的場景

- 支持一次性 數據服務, 也支持流式持續複製