智能系统与技术丛书

点击查看第二章

点击查看第三章

深入理解AutoML和AutoDL:构建自动化机器

学习与深度学习平台

王健宗 瞿晓阳 著

第1章

人工智能概述

本章主要是人工智能的基本概述,包括人工智能的起源和发展,以及人工智能的两个重要组成部分:机器学习和深度学习。深度学习一直在持续发展,我们将用两小节来介绍深度学习的崛起和重要应用领域,在最后一节中,我们引出了人工智能未来的重要发展方向—自动化机器学习技术(AutoML)。

1.1 全面了解人工智能

1.1.1 人工智能定义

在计算机科学领域中,人工智能是一种机器表现的行为,这种行为能以与人类智能相似的方式对环境做出反应并尽可能提高自己达成目的的概率。

人工智能这个概念最早于1956年8月的达特茅斯会议上由约翰·麦卡锡(John McCarthy)、马文·明斯基(Marvin Minsky)、克劳德·香农(Claude Shannon)、纳撒尼尔·罗切斯特(Nathaniel Rochester)等人提出。在此之前,人工智能有着许多种叫法,如“自动机理论”“复杂数据处理”等。

会议召开的两年前,也就是1954年,达特茅斯学院数学系有4位教授退休,这对于达特茅斯学院这样的小学校来说无疑是巨大的损失。刚上任的系主任约翰·克门尼(John Kemeny)赶忙向母校普林斯顿大学求援,从母校数学系带回4位刚毕业的博士来任教,而麦卡锡就是其中之一。1955年夏,麦卡锡应邀参与IBM的一个商业项目,邀请他的人是罗切斯特。罗切斯特是IBM第一代通用机701的主设计师,并且对神经网络表现出极大的兴趣。俩人一拍即合,决定发起一个将于次年夏天举办的研讨会,还说服了香农和在哈佛做研究员的明斯基来共同提议。麦卡锡给这个研讨会起了个别出心裁的名字—“人工智能夏季研讨会”(Summer Research Project on Artificial Intelligence)。同年9月2日,麦卡锡、明斯基、香农和罗切斯特正式发出提案引入“人工智能”一词,该提案的主要内容如下:

“我们提议于1956年夏,在新罕布什尔州汉诺威的达特茅斯学院进行一项10人、为期两个月的人工智能研究。这项研究基于这样一个猜想,即原则上,我们可以足够精确地描述学习或智能的任何其他特征的各个方面,从而能够让机器来进行模拟。我们试图找到方法让机器使用语言、形成抽象和概念、解决人类尚未解决的各类问题以及自我改进等。我们认为,一群经过精心挑选的科学家一起努力一个夏天,就可以在上述的一个甚至多个问题上取得重大进展。”

会议于1956年6月开始,同年8月结束。会议讨论了人工智能相关问题的各个方面,如自动化计算机、如何通过编程让计算机使用语言、神经网络、计算规模的理论、自我改进、随机性和创见性等。

明斯基认为,设计出一种具备某种特定学习能力的机器并非不可能,机器的本质是通过某种转换将输入变成输出的过程。机器的这种反应能力可以通过不断的“试错”过程训练获得。例如我们可以将这样的一台机器放置在某种特定的环境中,不断给予它“成功”和“失败”的判据来训练它达成某种目标的能力。更进一步,如果机器能通过学习使自身形成感知和运动抽象能力,那么它就会进行内部探索找寻解决问题的方案。

罗切斯特分享了关于机器性能的独创性话题。在为自动计算器编写程序时,人们通常会向机器提供一套规则,这些规则涵盖了机器可能会面对的各种意外情况。机器遵守这一套规则但不会表现出独创性或常识。此外,只有当机器因为规则矛盾而变得混乱时,人们才会对自己设计出糟糕的规则感到恼火。最后,在编写机器程序时,有时人们必须以非常费力的方式解决问题,然而,如果机器有一点直觉或者可以做出合理的猜测,问题就可以直接被解决。

会议进行了两个月,虽然每个人对AI的定义都不尽相同,但它却具有重要的开创意义和深远影响。由于会议上提出了人工智能(Artificial Intelligence)这一概念,因而1956年被称作“人工智能元年”。

1.1.2 弱人工智能、强人工智能与超人工智能

人工智能大体上可以分为3类:弱人工智能、强人工智能和超人工智能。

1.弱人工智能

弱人工智能(Weak AI),也被称为狭隘人工智能(Narrow AI)或应用人工智能(Applied AI),指的是只能完成某一项特定任务或者解决某一特定问题的人工智能。苹果公司的Siri就是一个典型的弱人工智能,它只能执行有限的预设功能。同时,Siri目前还不具备智力或自我意识,它只是一个相对复杂的弱人工智能体。

2.强人工智能

强人工智能(Strong AI),又被称为通用人工智能(Artificial General Intelligence)或全人工智能(Full AI),指的是可以像人一样胜任任何智力性任务的智能机器。这样的人工智能是一部分人工智能领域研究的最终目标,并且也作为一个经久不衰的话题出现在许多科幻作品中。

对于强人工智能所需要拥有的智力水平并没有准确的定义,但人工智能研究人员认为强人工智能需要具备以下几点:

- 思考能力,运用策略去解决问题,并且可以在不确定情况下做出判断;

- 展现出一定的知识量;

- 计划能力;

- 学习能力;

- 交流能力;

- 利用自身所有能力达成目的的能力。

3.超人工智能

哲学家、牛津大学人类未来研究院院长尼克·波斯特洛姆(Nick Bostrom)把超级智能定义为“在几乎所有领域都大大超过人类认知表现的任何智力”。;

超人工智能(Artificial Super Intelligence,ASI)正是超级智能的一种。首先,超人工智能能实现与人类智能等同的功能,即可以像人类智能实现生物上的进化一样,对自身进行重编程和改进,这也就是“递归自我改进功能”。其次,波斯特洛姆还提到,“生物神经元的工作峰值速度约为200 Hz,比现代微处理器(约2 GHz)慢了整整7个数量级”,同时,“神经元在轴突上120 m/s的传输速度也远远低于计算机比肩光速的通信速度”。这使得超人工智能的思考速度和自我改进速度将远远超过人类,人类作为生物上的生理限制将统统不适用于机器智能。

1.1.3 人工智能三大主义

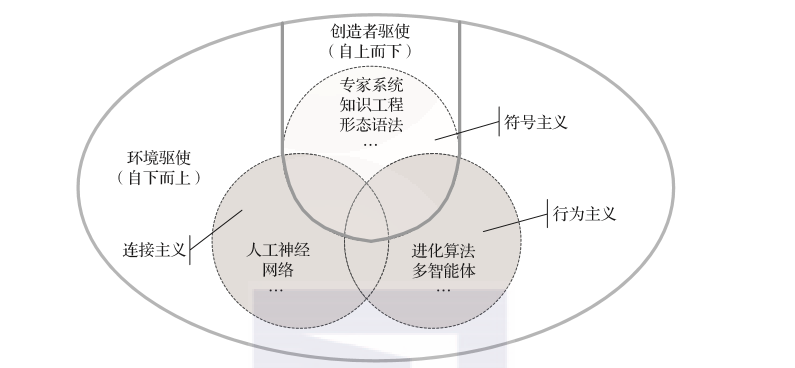

简要回顾人工智能的发展历史,我们会发现它主要由3个方面相互交织发展:符号主义、连接主义和行为主义。

- 符号主义:旨在用数学和物理学中的逻辑符号来表达思维的形成,通过大量的“如果-就”(if-then)规则定义,产生像人一样的智能,这是一个自上而下的过程,包括专家系统、知识工程等。

- 连接主义:主张智能来自神经元之间的连接,它让计算机模拟人类大脑中的神经网络及其连接机制,这是一个自下而上的过程,包括人工神经网络等。

- 行为主义:指的是基于感知行为的控制系统,使每个基本单元实现自我优化和适应,这也是一个自下而上的过程,典型的代表有进化算法、多智能体等。

由这3个方面构成的人工智能设计模型如图1-1所示。

图1-1 人工智能设计模型

在人工智能设计模型中,“创造者驱使”是一个自上而下的过程,这里的“创造者”不仅指的是创造者,也可以是一些其他的高级角色,如开发者,甚至可以是设计规范和材料属性。而“环境驱动”是一个自下而上的过程,其中“环境”可以是交互约束,如行为规则;也可以是外部因素,如位置和气候。总之,“创造者驱使”指明了一个宏观层面的方向,而“环境驱使”允许智能体自由发展,甚至可以改变它们的行为规则,从而实现自身的变化性和多样性。

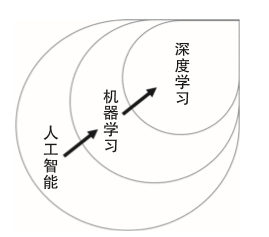

1.1.4 机器学习与深度学习

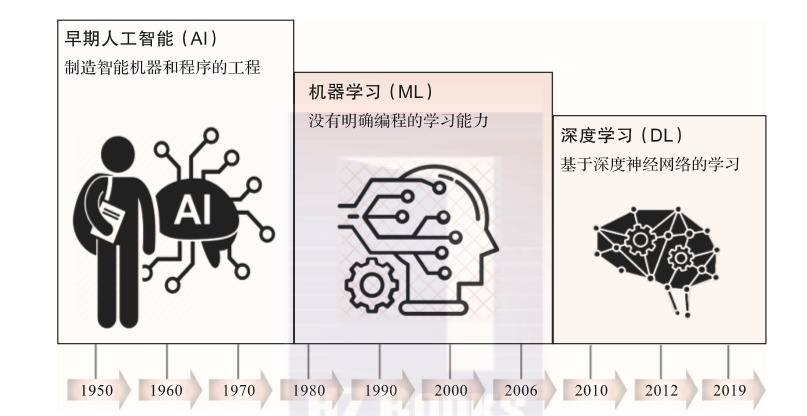

我们在前文介绍了人工智能的定义以及基本概念,下面将介绍人工智能发展的主要分支:机器学习和深度学习。如图1-2所示,人工智能发展的一个很重要的分支便是机器学习,由人工智能的连接主义发展形成的一个重要领域分支,它的核心目的是让计算机拥有像人一样的学习能力。而在机器学习中的一个庞大分支就是神经网络,严格来说深度学习属于机器学习的一个类别,但是随着近年来深度神经网络的发展,特别是深度学习应用范围的不断扩展,深度学习已经成为机器学习领域的一个重要部分。

图1-2 人工智能、机器学习、深度学习三者之间的关系

机器学习(Machine Learning)是关于计算机系统使用的算法和统计模型的科学研究,这些算法和统计模型不使用明显的指令,而是依靠模式和推理来有效地执行特定的任务。它被视为人工智能的一个子集。机器学习算法是建立在一个样本数据集(称为“训练数据”)上,在没有明确编程指示下根据任务的情况做出预测或决策的数学模型。机器学习算法被广泛应用于各种各样的应用中,如电子商务中的智能推荐和垃圾邮件判定等,在这些应用中对每一条数据编写特定指令是不切实际的。机器学习与计算统计学密切相关,计算统计学主要用于解决计算机的预测问题。数学优化的研究为机器学习领域提供了方法、理论和应用领域。数据挖掘是机器学习中的一个研究领域,其重点是通过无监督学习进行探索性数据分析。

“机器学习”这个名词是由阿瑟·塞缪尔于1959年提出的。汤姆·M·米切尔给机器学习领域中所研究的算法下了一个被广泛引用、更为正式的定义:“如果一个计算机程序在任务T(由P来度量)中的表现随经验E而改善,那么我们称该程序从经验E中学习。”这个对机器学习所涉及任务的定义提供了一个基础的操作定义而非认知上的定义。

深度学习,也称“阶层学习”或“分层学习”,是基于学习数据表征的更广泛的机器学习方法系列的一部分,而不是基于特定任务的算法。深度学习通过组合低层特征形成更加抽象的高层表示属性类别或特征,以发现数据的分布式特征表示。深度学习的优势是用非监督式或半监督式的特征学习和分层特征提取高效算法来替代手工获取特征。其中深度指的是网络中最长的输入输出距离。

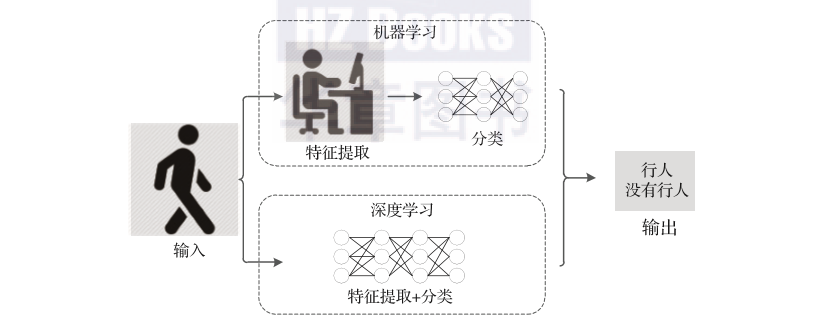

那么深度学习和机器学习的区别是什么呢?如图1-3所示,机器学习,即所谓的统计机器学习,在处理问题时,首先需要人工进行特征提取,然后根据提取后的特征进行分类问题求解。而深度学习的强大之处在于,将特征提取和分类问题求解汇总在一个神经网络模型中,只需一次输入即可得到最终的输出结果。

图1-3 机器学习与深度学习之间的差异及联系

1.2 人工智能发展历程

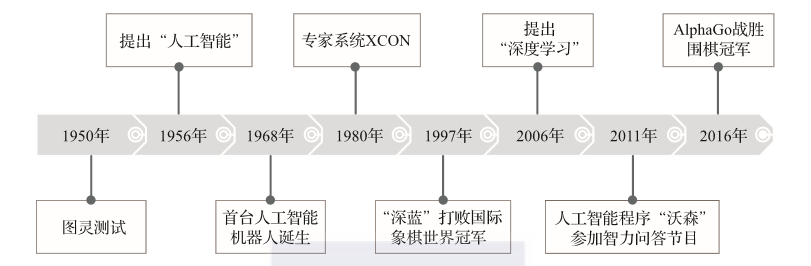

图1-4是人工智能发展情况概览。人工智能的发展经历了很长时间的历史积淀,早在1950年,阿兰·图灵就提出了图灵测试机,大意是将人和机器放在一个小黑屋里与屋外的人对话,如果屋外的人分不清对话者是人类还是机器,那么这台机器就拥有像人一样的智能。随后,在1956年的达特茅斯会议上,“人工智能”的概念被首次提出。在之后的十余年内,人工智能迎来了发展史上的第一个小高峰,研究者们疯狂涌入,取得了一批瞩目的成就,比如1959年,第一台工业机器人诞生;1964年,首台聊天机器人也诞生了。但是,由于当时计算能力的严重不足,在20世纪70年代,人工智能迎来了第一个寒冬。早期的人工智能大多是通过固定指令来执行特定的问题,并不具备真正的学习和思考能力,问题一旦变复杂,人工智能程序就不堪重负,变得不智能了。

图1-4 人工智能起源及发展

虽然有人趁机否定人工智能的发展和价值,但是研究学者们并没有因此停下前进的脚步,终于在1980年,卡内基梅隆大学设计出了第一套专家系统—XCON。该专家系统具有一套强大的知识库和推理能力,可以模拟人类专家来解决特定领域问题。从这时起,机器学习开始兴起,各种专家系统开始被人们广泛应用。不幸的是,随着专家系统的应用领域越来越广,问题也逐渐暴露出来。专家系统应用有限,且经常在常识性问题上出错,因此人工智能迎来了第二个寒冬。

1997年,IBM公司的“深蓝”计算机战胜了国际象棋世界冠军卡斯帕罗夫,成为人工智能史上的一个重要里程碑。之后,人工智能开始了平稳向上的发展。2006年,李飞飞教授意识到了专家学者在研究算法的过程中忽视了“数据”的重要性,于是开始带头构建大型图像数据集—ImageNet,图像识别大赛由此拉开帷幕。同年,由于人工神经网络的不断发展,“深度学习”的概念被提出,之后,深度神经网络和卷积神经网络开始不断映入人们的眼帘。深度学习的发展又一次掀起人工智能的研究狂潮,这一次狂潮至今仍在持续。

图1-5列出了人工智能发展史上的一些重要事件。从诞生以来,机器学习经历了长足发展,现在已经被应用于极为广泛的领域,包括数据挖掘、计算机视觉、自然语言处理、生物特征识别、搜索引擎、医学诊断、检测信用卡欺诈、证券市场分析、DNA序列测序、语音和手写识别、战略游戏、艺术创作和机器人等,鉴于篇幅有限,本书将侧重讲述机器学习和深度学习未来发展的一大趋势—自动化机器学习和深度学习(AutoML及AutoDL)。

图1-5 人工智能发展重大事件

1.3 深度学习的崛起之路

1.3.1 人脸识别的起源

2012年,Alex Krizhevsky等人提出了AlexNet网络结构模型,以一种结构上轻巧简单但计算量上远超传统模型的方式轻易战胜了传统的机器学习模型,并凭借它在ImageNet图像分类挑战赛上赢得了冠军。自此,在图像领域点燃了深度学习的热潮,无数公司与学者纷纷转向该领域,并在短短几年内就取得了大量的突破性进展,其中包括何凯明等人提出的残差神经网络、谷歌提出的GoogLeNet等。这些新的研究成果使得人脸识别等过去不可能实现的场景拥有了落地的可能。

1.3.2 自动驾驶的福音

巧合的是,同样在2012年,图像分割领域也通过深度学习的应用取得了历史性突破,那就是全卷积网络(FCN)的出现。在另一个图像领域的著名图像分割任务数据集VOC上,FCN刷新了该数据集的最优指标,引爆了深度学习在图像分割领域的应用。

图像分类与图像分割的突破带来了另一个行业的突破,那就是自动驾驶。早在2009年,谷歌就已经成立了负责自动驾驶业务的子公司Waymo,也是目前自动驾驶的巨头之一,其估值顶峰达到了1700多亿美元,可见自动驾驶行业在投资人心中的分量。在国外,除谷歌外,特斯拉、苹果公司等科技巨头,奥迪、德尔福、通用汽车等汽车行业巨头,Uber、Lyft等网约车领域巨头也都在做自动驾驶研究。在国内,百度、Momenta、Pony.ai、地平线、驭势科技、图森未来等公司也在这一领域不断发力。

在深度学习出现之前,自动驾驶的水平主要停留在基于毫米波雷达及其他传感器的低阶水平,这个水平的自动驾驶是不可能真正解放司机注意力的;深度学习的出现带来了图像识别与图像语义分割理解的突破,让人们看到了实现L5级别完全自动驾驶的希望,也由此引起了自动驾驶行业的爆发。

1.3.3 超越人类的AI智能体

2016年发生了另一起点燃深度学习浪潮的事件,那就是谷歌DeepMind研发的AI围棋手AlphaGo异军突起。2016年3月,AlphaGo与围棋世界冠军、职业九段棋手李世石进行围棋人机大战,以4﹕1的总比分获胜;2016年年末至2017年年初,该程序以Master为注册名与中日韩数十位围棋高手进行快棋对决,连续60局无一败绩,被称为Alpha Master;2017年5月,在中国乌镇围棋峰会上,它与当时排名世界第一的世界围棋冠军柯洁对战,以3﹕0的总比分获胜。围棋界公认AlphaGo的棋力已经超过人类职业围棋顶尖水平,在GoRatings网站公布的世界职业围棋排名中,其等级分曾超过排名人类第一的棋手柯洁。

AlphaGo的出现让人们进一步意识到了深度学习的无限可能。2019年3月,ACM正式宣布将2018年图灵奖授予Yoshua Bengio、Geoffrey Hinton和Yann LeCun,以表彰他们提出的概念和工作使得深度学习神经网络有了重大突破。这也使得人们对深度学习的热情进一步发酵,让更多的研究开始往这个领域倾斜与投入。

1.3.4 懂你的AI

近几年,深度学习领域的热门研究主要集中在以下几个方向:生成对抗网络、迁移学习、强化学习、联邦学习以及本书的主题—AutoML。其中,在算法方面,谷歌提出的注意力机制以及基于该思想衍生出的BERT模型大幅刷新了自然理解领域所有数据集的评价指标,业内对此做出这样的评价:“自然语言处理是未来深度学习领域皇冠上的明珠。”基于底层语言理解模型的突破,让机器翻译、人机对话、文本分析、AI音乐、AI写作等许多过去不可想象的任务都成为可能。

1.3.5 奔跑、飞行以及玩游戏的AI

让机器为人类服务是人类一直以来的美好梦想,随着深度学习的发展,这个梦想正在逐渐实现。过去为了要让机器具有智能,需要人为赋予其大量的逻辑判断命令;而如今伴随着图像技术的成熟以及深度强化学习的应用,机器人在路上飞速奔跑、识别并跨越障碍物,乃至花式跳舞都已经成为现实。除此之外,AI机器人还能够与玩家联机对战《星际争霸》,并且一般的职业选手都没法战胜它。另一个值得关注的是京东正在打造的无人送货机,它能够自动规划路线、躲避障碍、识别目标客户并完成货物投递,是非常值得期待的一项新型服务。

1.3.6 人人都可以创造属于自己的AI

以上的种种发展都证明了,AI是这个时代不可阻挡的一个趋势。然而就当下而言,由于AI是一个较为新潮的事物,实现起来的技术难度较大,因此在各行各业的普及难度也较大,但是能够让AI开花结果的正是非IT领域的各行各业。另外,目前拥抱AI的都是主流的大公司或者科技含量较高的创业公司,而传统的行业则缺乏相应的资源及人才。为了普及人工智能,降级人工智能的门槛,并且方便人工智能的开发,实现人人都会人工智能,自动化机器学习(AutoML)这个概念应运而生。

AutoML是一个自动模型学习的平台,其核心思想是自动化创造AI模型,把中间的复杂流程与烦琐的步骤都交给机器来自动完成,使用者只要指定输入的数据和任务类型即可。当前许多企业通过这种技术自动化生成了许多优秀的模型,例如小米公司通过神经架构搜索技术得到了最优的图像超分辨率模型,用于在手机端提升图像质量。除此之外,微软、亚马逊、谷歌、Salesforce等公司也都为顾客提供了类似的平台,使得对AI不那么熟悉的人也可以方便地应用AI技术并使其在自己的行业内落地。

1.4 深度学习的发展

随着深度学习的应用越来越广泛,3个成熟的研究领域逐渐形成,分别是计算机视觉、自然语言处理以及语音领域,目前AI创业公司也主要集中在这些领域。下面我们就重点展开来介绍这3大应用领域。

1.4.1 计算机视觉

计算机视觉(Computer Vision,CV),顾名思义就是计算机拥有像人类一样“看”的能力。在这里“看”的具体含义是指:不仅要将当前的图像输入到计算机中,计算机还应该具有智力,可以根据要求针对当前图像输出一定的分析结果。这个过程可以定义为几个核心任务:目标分类、目标检测、目标分割以及目标跟踪。

目标分类(Target Classification)就是基于分类任务的目标识别问题,即计算机根据给定的数据,找出这些数据中哪些是所需的目标。例如,猫狗分类问题或者花草分类问题。这也是深度学习领域中最简单的一类任务,根据最后的分类函数可以将此任务分为二分类问题和多分类问题。目标分类任务是其他任务的基础,也是很多初学者的入门级任务。

目标检测(Target Detection)可以看成是分类和回归问题的统一。该任务不仅要判断当前图像的所属类别,还要通过包围框(bounding box)标出图像中目标的具体位置。目标检测问题由来已久,基于深度学习的发展从2013年R-CNN算法的提出开始,不断演变出了一系列多步检测网络。之后很多研究学者对网络进行了改进,提出了单步检测,将分类、定位、检测功能都集成在一个网络中,如Yolo、SSD等。目标检测任务的应用十分广泛,经常应用于电力系统检测、医疗影像检测等。目标检测任务根据问题的复杂性,衍生出了人脸检测问题。与传统目标检测问题不同的是,人脸检测需要实现人脸关键点的定位和检测,现在移动设备中应用比较广泛的人脸识别系统就是基于这一任务研究而来。

目标分割(Target Segmentation),就是将一张图像中的特定目标的区域分割出来。在深度学习领域中,目标分割的研究方向主要分为两类:语义分割和实例分割。所谓语义分割就是针对图像中的每个像素点进行分类,即判断图像中哪些像素属于哪个目标。而实例分割是语义分割的进阶版,它不仅要判断哪些像素属于目标,而且要判断哪些像素属于第一个目标,哪些像素属于第二个目标,目前在医疗影像项目中的关键就是对人体器官的分割。常见的图像目标分割网络有FCN和U-Net,其中,U-Net常用于医疗图像分割。

目标跟踪(Target Tracking)是一个基于时间序列的目标定位问题,通常是基于视频数据的任务,常用于智能监控系统、嫌疑犯追逃等。首先是在第一帧图像中锁定目标,在之后的时序数据中,不断地对目标进行重定位。这是一个非常复杂的问题,需要用到目标检测和分割任务,而且根据时序相关性进行有效建模,可以减少定位过程中的计算量,提高追踪效率。

我们介绍了这么多计算机视觉的定义及任务,那么它与图像处理有什么异同呢?严格来讲,图像处理是一种数字信号处理,它不涉及对图像内容的理解,一般是通过数学函数等对图像进行变换或增强,如归一化图像、图像预处理、消除图像噪声等;而计算机视觉是使用计算机模拟人类视觉,该模拟过程包括学习以及推理能力。计算机视觉离不开图像处理操作,因此可以将图像处理看成计算机视觉的一个子集,当目标是对图像进行增强时,可以称为图像处理,当目标是检测和分割等时,则称为计算机视觉。

计算机视觉任务看似容易,但也存在很多潜在的挑战。因为我们人眼每天看到的景象是错综复杂的,我们的视觉和大脑的判别是同步进行的,但对于计算机而言,虽然经过了很多学者的研究,其仍无法达到人类视觉的能力。而且,感官世界极其复杂,任何光照条件或者遮挡都可能会造成计算机识别任务的失败。因此,计算机视觉仍然有很长的一段路要走。

1.4.2 自然语言处理

如果说计算机视觉是模拟人类“看”的能力,那么自然语言处理(Natural Language Processing,NLP)就是模拟人类的“语言”能力,这里的“语言”是指说话和写作能力。站在专业的角度来讲,NLP就是以一种智能高效的方式对人类创造的文本数据进行系统地分析、理解和提取信息的过程。

NLP的研究任务很广泛,在本书中我们将它分为5大类:词法分析、句子分析、语义分析、信息抽取和顶层任务。词法分析就是以词为单位对数据进行分析,这是NLP中最基本的工作。常见的词性标注和拼写校正任务就属于词法分析。句子分析就是以句子为单位的分析任务。语义分析就是通过对文本数据的分析,生成对应文本数据的语义信息的形式化表示,常见任务有词义消歧等。信息抽取是NLP任务中应用最广泛的一个,简单理解就是从非结构化的文本数据中抽取出用户所需的结构化信息。常见任务有命名实体消除、情感分析、实体消歧等。所谓顶层任务就是直接面向用户的任务,比如机器翻译或文本摘要,它需要多种任务结合生成对应的可以直接读取的输出结果。另外顶级任务还包括对话系统、阅读理解等。

NLP机制涉及两个流程:自然语言理解和自然语言生成。我们都知道文本数据是非结构化语言,而计算机擅长处理的是结构化数据。所以在NLP机制中,计算机首先需要从非结构化数据中进行读取,转化成结构化数据,通过语法知识和规则进行理解,然后将结构化数据进行组合,生成通顺的非结构化文本。

NLP的应用非常广泛,比如微博的热点推荐,就是通过用户对应的信息和经常浏览的信息进行情感分析,个性化推荐当前热点。另外邮件的垃圾分类、用户体验反馈等也都是通过自然语言处理技术实现的。

1.4.3 语音识别

我们的目标不仅仅是让计算机有“看”和“语言”的能力,还要让计算机拥有“听”和“说”的能力,因此还需要语音识别(Voice Recognition)。语音识别的目标是将一段自然语言通过声学信号的形式传给计算机,由计算机理解并且做出回应。语音识别系统主要包含特征提取、声学模型、语言模型、字典与解码4大部分。其中特征提取需要对采集的声音信号进行滤波、分帧等音频预处理工作,目的是将要进行分析的音频信号合适地从原始信号中提取出来。语音识别的过程可以概括如下:根据特征提取将声音信号从时域转换到频域,从而为声学模型提供合适的特征向量;再由声学模型根据特征向量来判断其属于哪个声学符号;然后利用语言模型来判断声学符号可能属于哪个词组序列;最后根据已有字典对词组序列进行解码,从而得到最后的文本表示。

在人机交互的过程当中,计算机除了能通过语音识别技术来“听懂”人们对它说的话,还需要能够将文本信息用人们能听懂的方式表达出来。在这样的需求下,语音合成技术应运而生。语音合成技术能够利用计算机等设备将文本信息转换为人们能听懂的音频数据,再通过语音的方式播放出来。

声纹识别是语音识别领域的又一个研究方向。与语音识别不同,声纹识别属于生物识别技术的一种,它根据语音波形中反映说话者生理和行为特征的语音参数,通过连接声纹数据库来鉴别人的身份。因此,声纹识别不注重语音信号的语义理解,而是从语音信号中提取个人声纹特征,并从中找出能够唯一辨别(声纹识别的理论基础是每一个声音都有自己的特征,该特征能将不同人的声音进行有效地区分)说话者身份特征的信息。

语音识别有很广阔的应用场景和发展空间,如:行车导航软件通过语音合成技术为司机指引道路、播报路况,人们甚至可以选择用自己喜欢的明星的声音来播报软件内容;智能家居系统利用语音合成技术能够实现与用户的实时交流,人们可以从智能家居的“嘴”中得知家中的一些基本情况,大大提高了生活质量;在智能教学领域,学生能够利用语音合成技术跟读单词、句子,语音辅导软件的出现大大方便了教学过程,提高了教学质量。

1.5 下一代人工智能

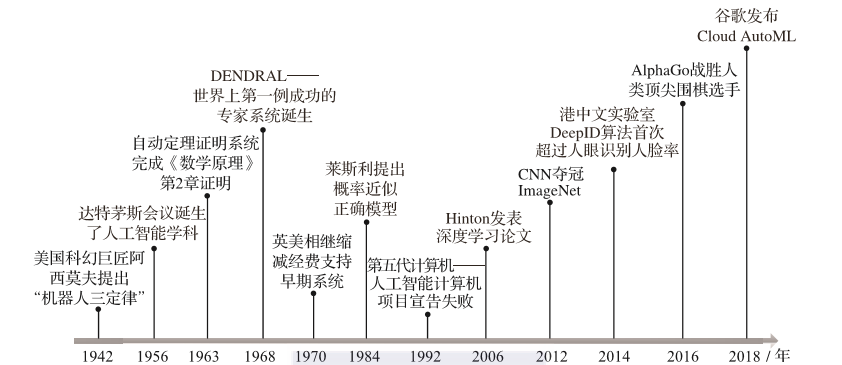

我们首先通过图1-6来回顾一下人工智能的发展历程。

图1-6 人工智能发展历程

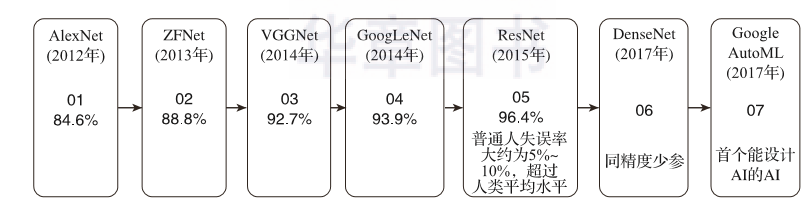

到目前为止,人工智能按照总体向上的发展历程,可以大致分为4个发展阶段,分别为精耕细作的诞生期、急功近利的产业期、集腋成裘的爆发期,以及现在逐渐用AutoML来自动产生神经网络的未来发展期。早期由于受到计算机算力的限制,机器学习处于慢速发展阶段,人们更注重于将逻辑推理能力和人类总结的知识赋予计算机。但随着计算机硬件的发展,尤其是GPU在机器学习中的应用,计算机可以从海量的数据中学习各种数据特征,从而很好地完成人类分配给它的各种基本任务。此时,深度学习开始在语音、图像等领域大获成功,各种深度学习网络层出不穷,完成相关任务的准确率也不断提升。同时,深度学习神经网络朝着深度更深、结构更加巧妙复杂的方向推进,GPU的研发与应用也随着神经网络对算力要求的不断提高而持续快速向前推进。图1-7展示了近年来主要神经网络的发展。

图1-7 主要深度神经网络的发展

2012年,AlexNet为了充分利用多个GPU的算力,创新性地将深度神经网络设计成两部分,使网络可以在两个GPU上进行训练。2013年,ZFNet又进一步解决了Feature Map可视化的问题,将深度神经网络的理解推进了一大步。2014年,VGGNet通过进一步增加网络的深度而获得了更高的准确率;同年,GoogLeNet的发明引入了重复模块Inception Model,使得准确率进一步提升。而2015年ResNet将重复模块的思想更深层次地发展,从而获得了超越人类水平的分辨能力。这时,由于深度神经网络层数的不断加深,需要训练的参数过于庞大,为了在不牺牲精度的同时减少需要训练的参数个数,2017年DenceNet应运而生。

随着深度神经网络的不断发展,各种模型和新颖模块的不断发明利用,人们逐渐意识到开发一种新的神经网络结构越来越费时费力,为什么不让机器自己在不断的学习过程中创造出新的神经网络呢?出于这个构思,2017年Google推出了AutoML—一个能自主设计深度神经网络的AI网络,紧接着在2018年1月发布第一个产品,并将它作为云服务开放出来,称为Cloud AutoML。自此,人工智能又有了更进一步的发展,人们开始探索如何利用已有的机器学习知识和神经网络框架来让人工智能自主搭建适合业务场景的网络,人工智能的另一扇大门被打开。

1.6 参考文献

[1]MCCARTHY J, MINSKY M L,ROCHESTER N, et al. A proposal for the Dartmouth summer research project on artificial intelligence[EB/OL]. (1955-08-31)[2019-05-30].https://www.aaai.org/ojs/index.php/aimagazine/article/view/1904.

[2]MOORJ.The Dartmouth college artificial intelligence conference: the next fifty years[J]. AI Magazine,2006, 27(4): 87-89.

[3]KLINE R. Cybernetics, automata studies and the Dartmouth conference on artificial intelligence[J]. IEEE Annals of the History of Computing, 2011, 33(4).

[4]SOLOMONOFF R J. The time scale of artificial intelligence: reflections on social effects[J]. Human Systems Management, 1985, 5(2): 149-153.

[5]MUEHLHAUSER L.Ben Goertzel on AGI as a field[EB/OL]. (2013-10-18) [2019-05-30].http://intelligence.org/2013/10/18/ben-goertzel/.

[6]DVORSKY G. How much longer before our first AI catastrophe?[EB/OL]. (2013-04-01) [2019-05-30]. https://io9.gizmodo.com/howmuch-longer-before-our-first-ai-catastrophe-464043243.

[7]KURZWEIL R. The singularity is near[M]//SANDLER R L. Ethics and emerging technologies.London:Palgrave Macmillan, 2014: 393-406.

[8]CHALMERS D. The singularity: a philosophical analysis[J]. Journal of Consciousness Studies, 2010, 17(9-10): 7-65.

[9]WEI L K. AI concepts in architectural design[C]//IOPscience. IOP conference series: materials science and engineering. Bristol:IOP Publishing, 2018, 392(6): 062016.

[10]KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//NIPS. Advances in neural information processing systems 25. New York: Curran Associates, 2012: 1097-1105.

[11]LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//IEEE. Proceedings of the IEEE conference on computer vision and pattern recognition. Boston: IEEE, 2015: 3431-3440.

[12]DEVLIN J, CHANG M W, LEE K, et al. Bert: Pre-training of deep bidirectional transformers for language understanding[J]. arXiv:1810.04805, 2018.