引言

从计算到感知再到认知是业内学者都认同的人工智能技术发展路径。机器具备认知智能,进而实现推理、规划乃至联想和创作,在一定程度上需要一个充满知识的大脑,而信息抽取是获取知识的重要途径之一。 在具体的业务场景如搜索推荐,结构化的领域知识有利于实现细粒度文本理解,有利于实现精准的复杂问答,有利于召回更相关的文档。在医疗、法律、金融等垂直领域,构建高质量的垂直知识图谱,是实现知识赋能搜索、问答、推荐等业务场景的基石,而信息抽取则是构建图谱最为重要的环节之一。然而什么是信息抽取?它有哪些挑战?发展状况如何?未来趋势又是怎么样?本文旨在回答以上几个问题。

什么是信息抽取?

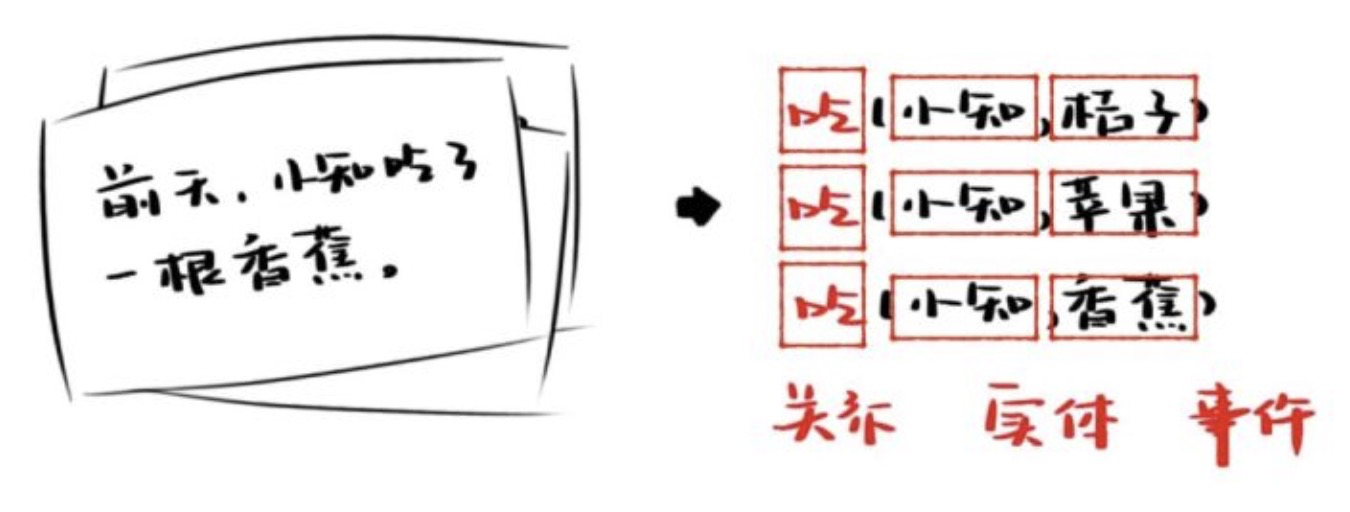

信息抽取(information extraction),即从自然语言文本中,抽取出特定的事件或事实信息,帮助我们将海量内容自动分类、提取和重构。 这些信息通常包括实体(entity)、关系(relation)、事件(event)如下所示。

通常而言,信息抽取技术主要包含命名实体识别、关系/属性抽取、事件抽取等任务。命名实体识别(NER)一般是一个序列标注任务,如对于文本"娃娃(PEO)进娃娃机抓娃娃",在上下文语境下,实体识别任务需要对第一个娃娃标注为PEO。关系/属性抽取一般为分类任务,如给定实体对和文本,判断在上下文语境下实体之间是什么关系。比如,给定实体“特朗普”、实体“纽约”和文本“特朗普出生于纽约”,关系抽取需要抽取“出生于”这个关系。事件抽取最为复杂,一般分为事件识别(Trigger Identification/ Classification)、元素分类(Argument Identication)、元素角色分类(Argument Role Classification)等几个子任务。例如,对于文本“贾乃亮离婚后现身综艺!谈及家人满脸心酸,前妻李小璐” 事件抽取需要首先识别触发词"离婚"并分类为"离婚事件",再识别元素"贾乃亮"和"李小璐"并分类为"丈夫"和"妻子"。

信息抽取的挑战

命名实体识别任务是信息抽取中发展最为成熟的任务,从古老的HMM、CRF到BiLSTM-CRF,再到Lattice LSTM ,TENNER[1],实体识别任务在标准数据集上取得了很大的进步,在BERT等预训练模型出现后,实体识别更获得了进一步的提升。 而关系抽取任务,由于标准数据获取的困难,效果相对较差。关系抽取任务一般采用有监督或远监督分类模型,在深度学习出现之前主要通过人工特征和基于核函数的模型;在深度学习时代,主流模型有CNN、PCNN等。事件抽取最为困难,方法发展和关系抽取类似,代表研究有中科院陈玉博研究员提出的DMCNN[2]等。除此之外,信息抽取还包含通用领域信息抽取,代表工作有TextRunner,Open IE等。

信息抽取主要面临以下几个挑战:

- 样本获取困难。如何在有限的标注样本下训练高质量的信息抽取模型是一个严峻的挑战。比如,垂直领域如医疗标注命名实体需要专业的知识,标注成本极高;获取关系抽取、事件抽取样本也代价高昂。

- 文本语义复杂。如何在复杂歧义的上下文和长文本语境抽取实体、关系、事件是一个严峻的挑战。比如“姨妈(人物)来了大姨妈(生理)怎么办”,“纽约是美国首都”同时包含了“首都” 和“位于” 两个关系,"李小璐和贾乃亮会复婚吗" 根本没有包含触发词。

- 泛化能力差。如何训练一个能在数据、标签分布不同的真实场景仍具有较好泛化能力的模型是一个严峻的挑战。比如,如果训练样本仅有短文本Title、Query,模型在预测长文本文档时性能会大打折扣,又比如对于新出现的关系、事件、实体类型,信息抽取模型性能也会严重下降。

- 实用性差。如何训练一个通用模型进行端到端的信息抽取是一个严峻的挑战。目前现有的信息抽取模型分为pipeline、end2end、join inferecne 、 joint modeling等,一般需要多个模型进行级联,极其复杂,不同方法各有优劣,训练一个通用的信息抽取模型同时抽取实体、关系、事件是非常困难的。

低资源信息抽取

低资源信息抽取旨在基于少量标注样本和大量无标注样本,获得高性能的信息抽取模型,技术路线主要包含基于元学习的方法、基于迁移学习的方法、引入外部数据的方法、基于预训练的方法和基于样本增广的方法等。本质上,低资源信息抽取方法主要目标是获得更加鲁棒的表征和更多的样本来实现低资源场景下模型性能的提升。下面介绍几篇代表性工作。

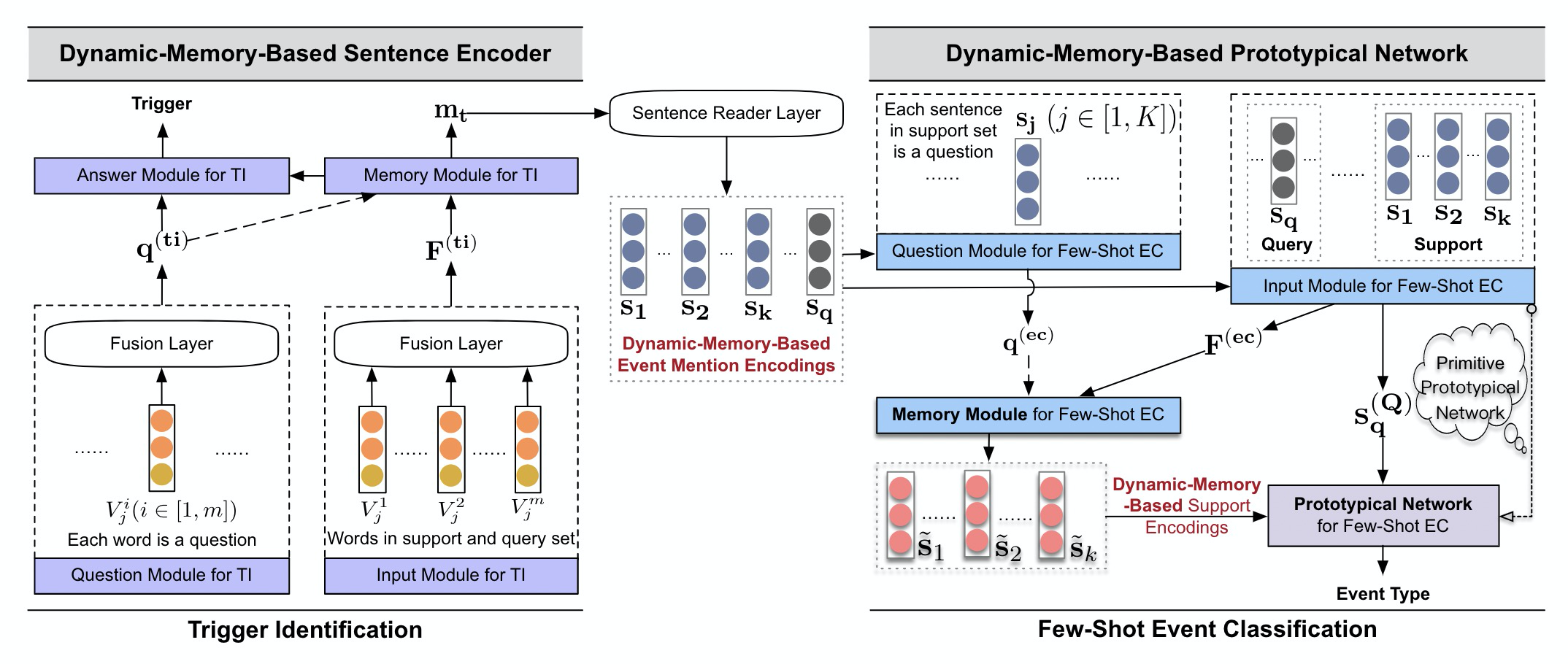

DMB-PN(WSDM2020)[3]

考虑到现实世界中的新事件层出不穷,本人及合作者将事件检测建模成少样本学习任务,并提出了一个基于动态记忆的原型网络模型。

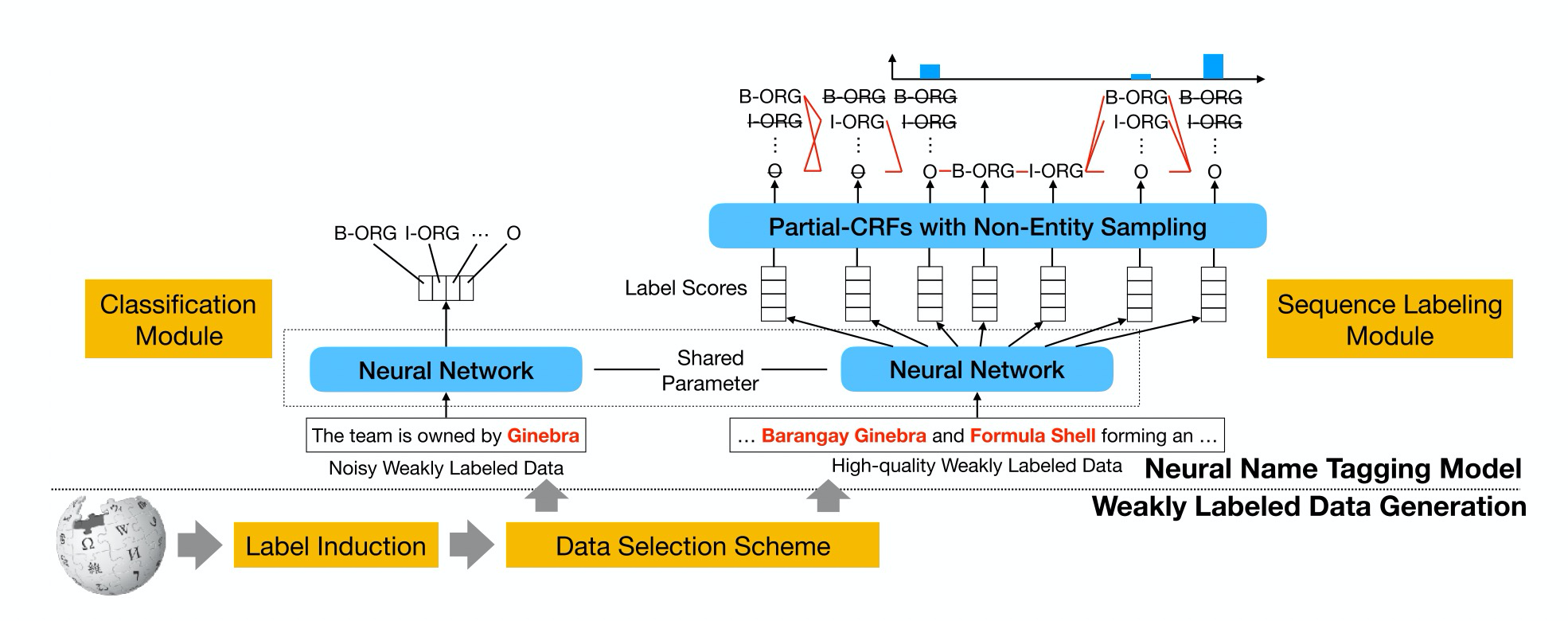

LW-BiLSTM-PCRF(EMNLP2019) [4]

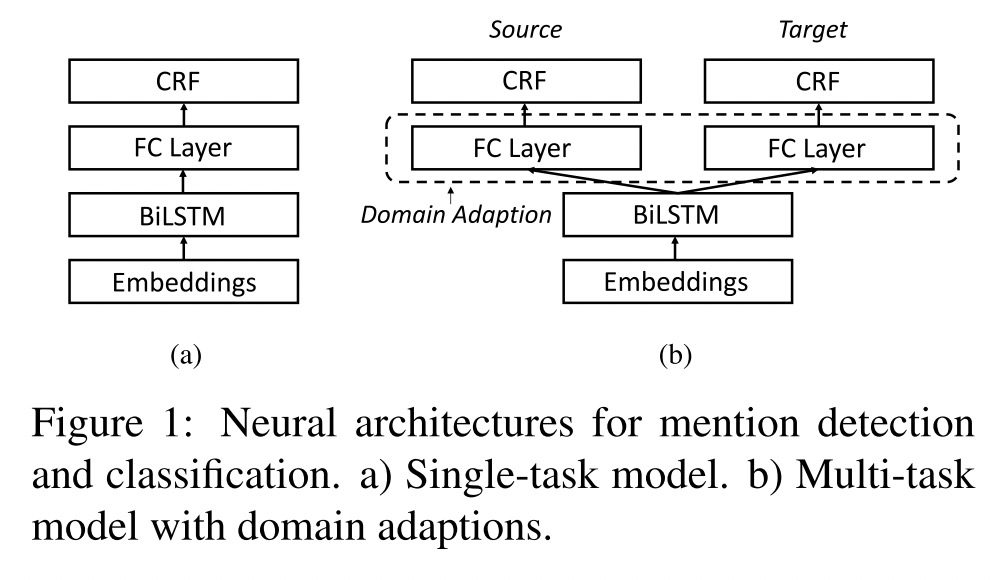

UIUC Ji heng 组提出了基于弱监督标签的实体识别模型,模型主要通过同时使用高质量和低质量的弱监督数据并共享参数训练Partial-BiLSTM-CRF模型,本质上这是一个迁移学习过程。

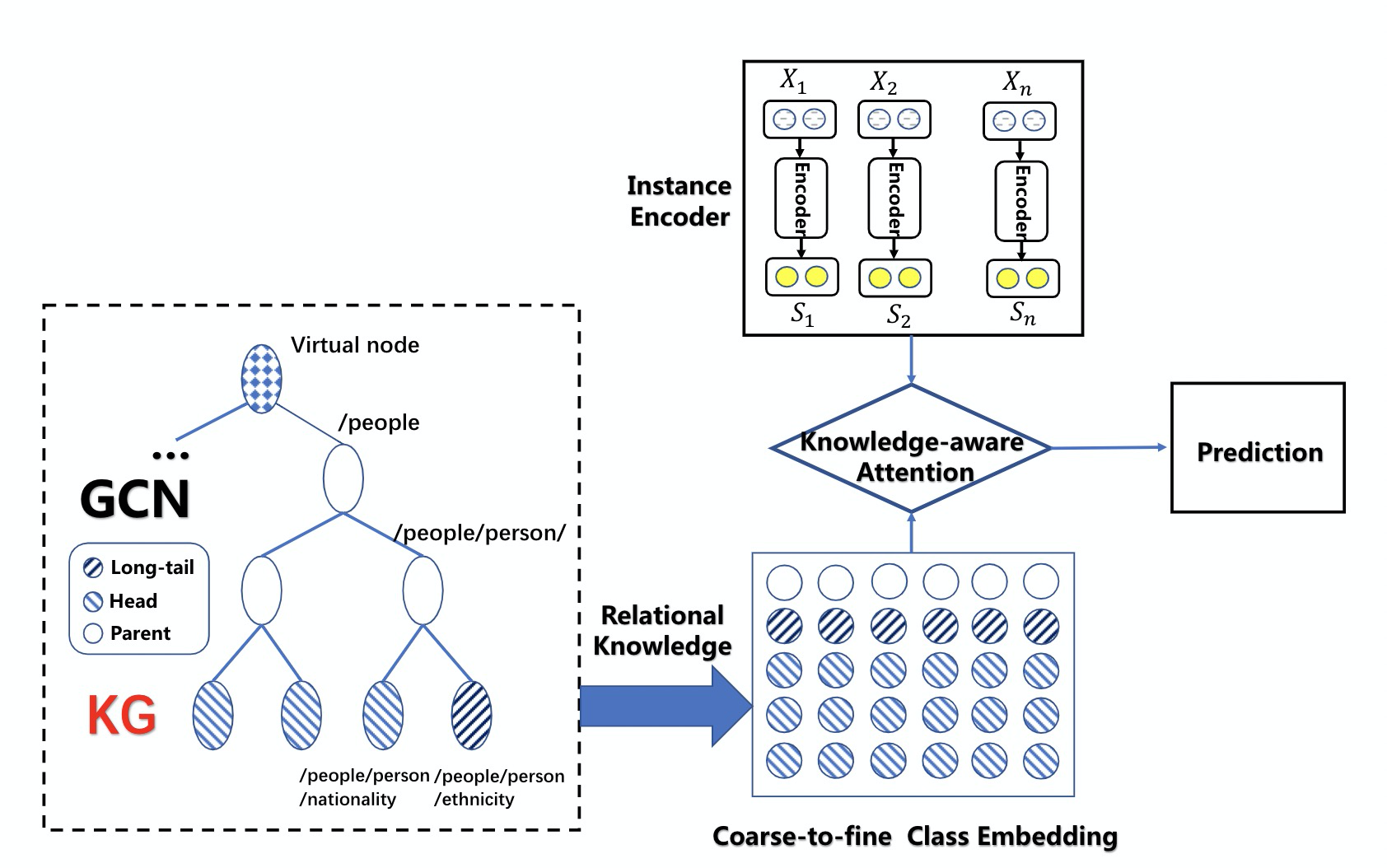

GCNRE(NAACL2019)[5]

针对关系抽取中大量长尾关系抽取难的特点,本人基于关系之间的显式关联和知识图谱隐式知识,提出基于图神经网络的关系抽取模型,在长尾关系抽取中取得较好效果。

Match Blank(ACL2019)[6]

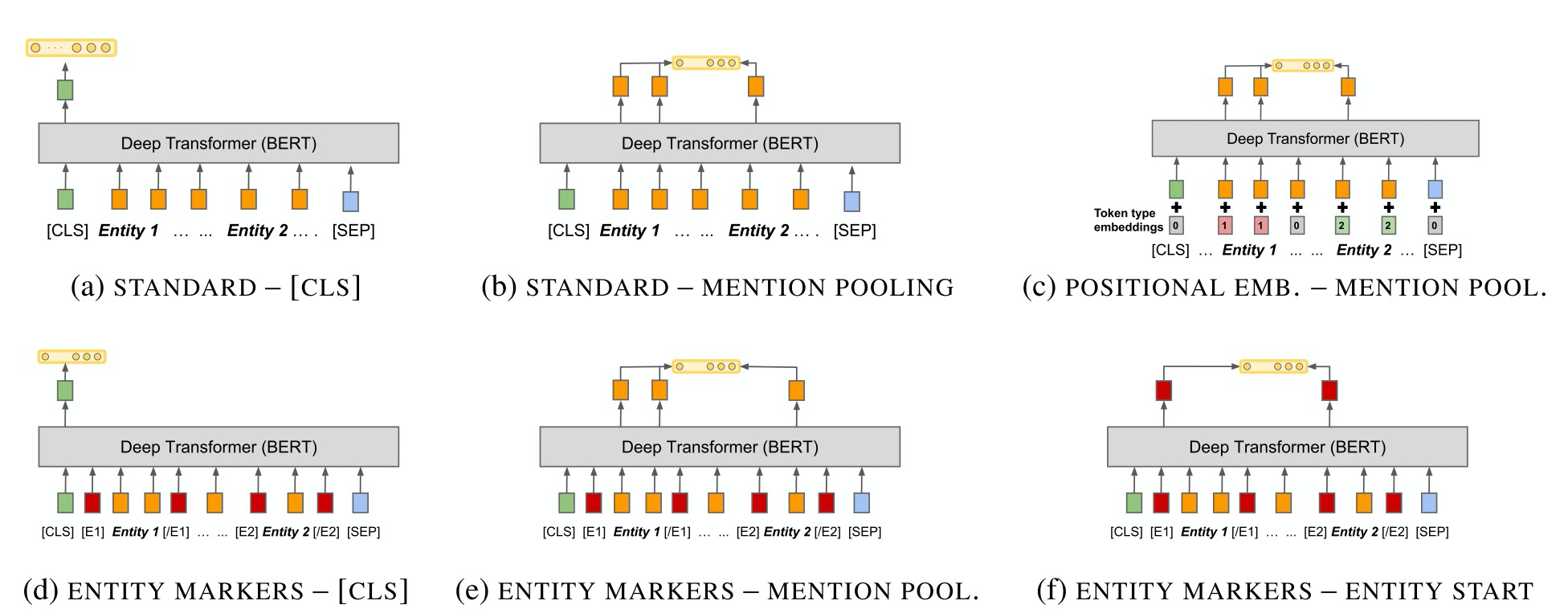

谷歌团队提出的一种关系抽取算法,本文贡献主要在于新颖的预训练模式和多种encoder的经验结果。此方法效果极好,且在FewRel数据集超过人类,然而中文领域仍缺乏此类预训练模型。

MTDS(NAACL2019)[7]

阿里达摩院司罗老师团队提出了基于一致性的数据选择和知识驱动和生成的实体识别算法,此算法本质上也是一种新颖的迁移学习算法,具有一定的实用价值。

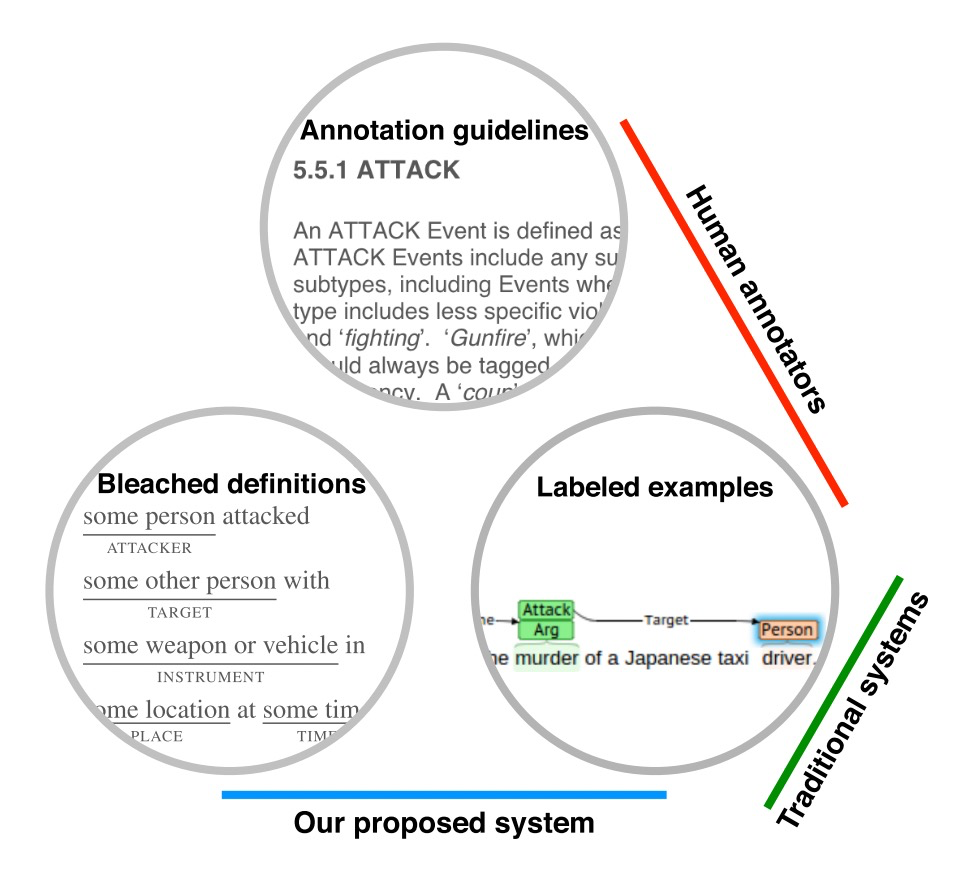

Reading the Manual(AAAI2020)[8]

约翰霍普金斯大学的学者提出了一个新颖的事件抽取模型,核心想法是引入标注的规则文本,此方法类似数据增广,在低资源场景效果较好。

复杂语境下信息抽取

复杂语境下信息抽取的难点首先是overlapping, 如存在实体之间互相包含、关系互相重叠。其次是远程监督带来的噪音以及长文档跨句带来的表征学习困难。

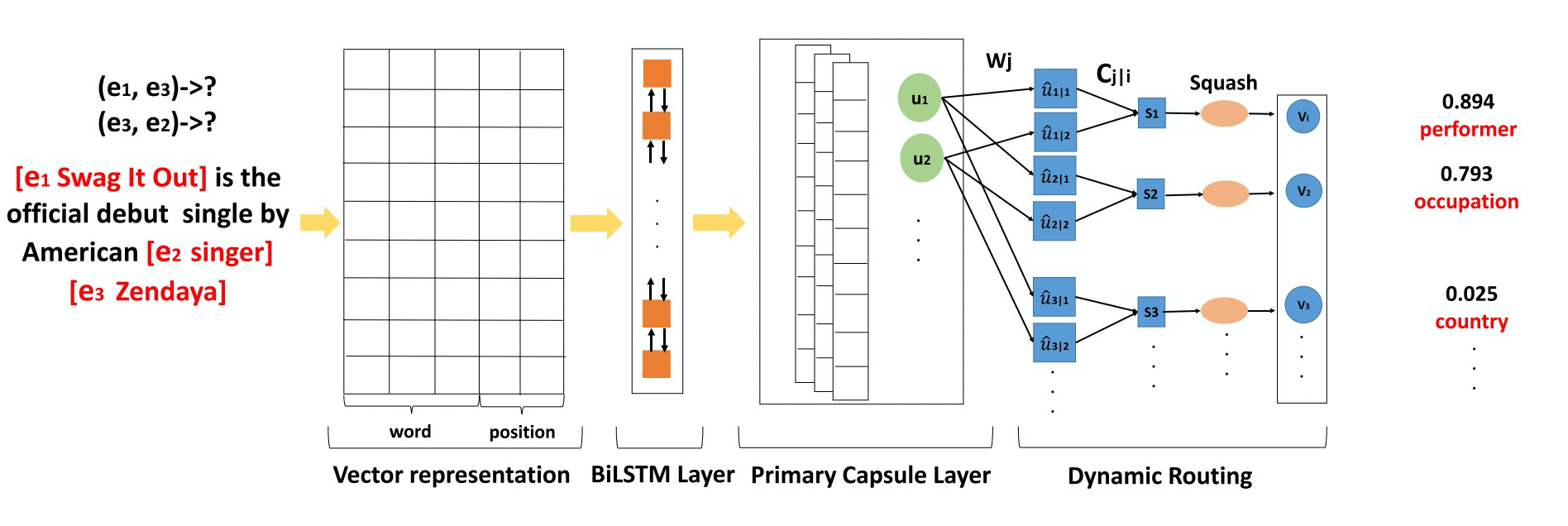

Capsule(EMNLP2018)[9]

关系抽取中存在大量的多关系情况,样本分布不均衡的数据集上很难进行实体对中的多关系抽取,本人提出了基于胶囊网络的多关系抽取模型,此模型基于无监督路由算法学习关系的鲁棒向量,以减轻不均衡样本对表征的影响,在多关系抽取取得较好的效果。

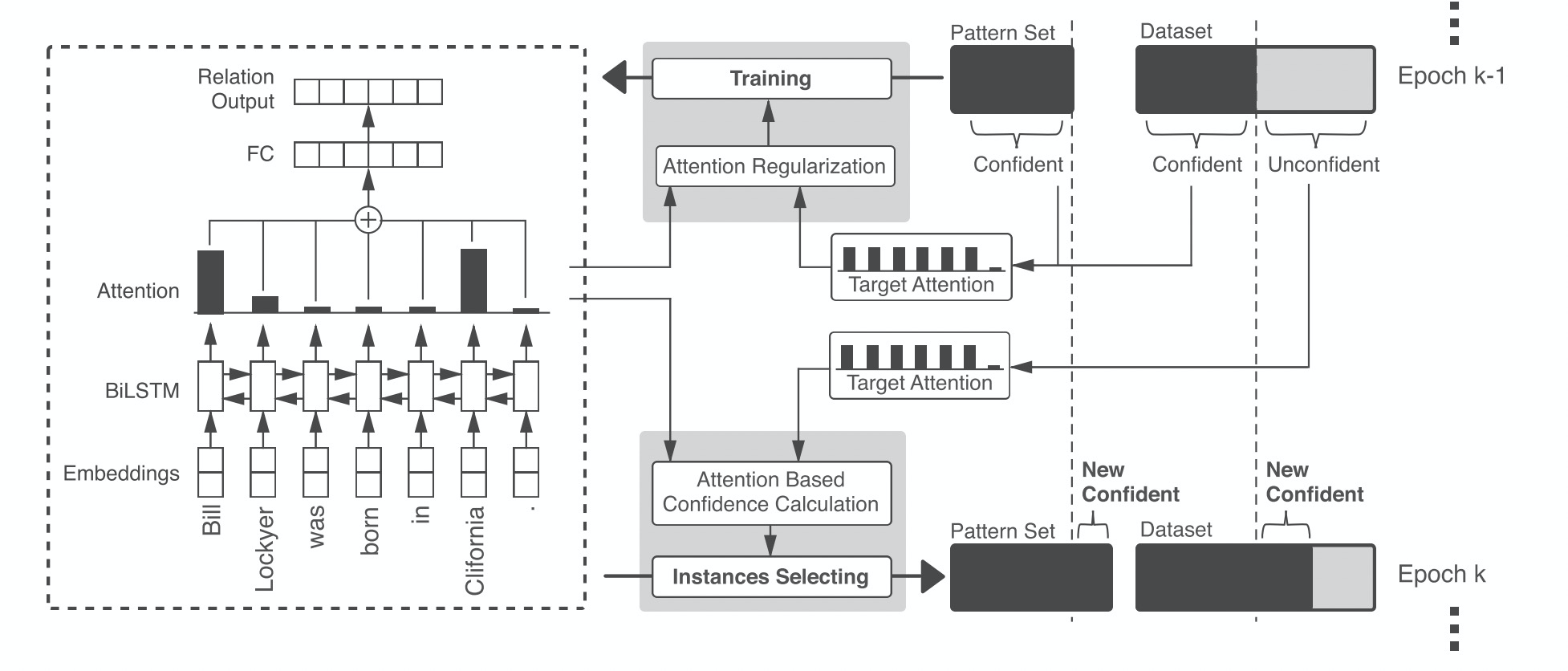

ARNOR(ACL2019)[10]

针对关系抽取远监督导致的噪音问题,百度学者提出了基于模板匹配和注意力正则的降噪方法。

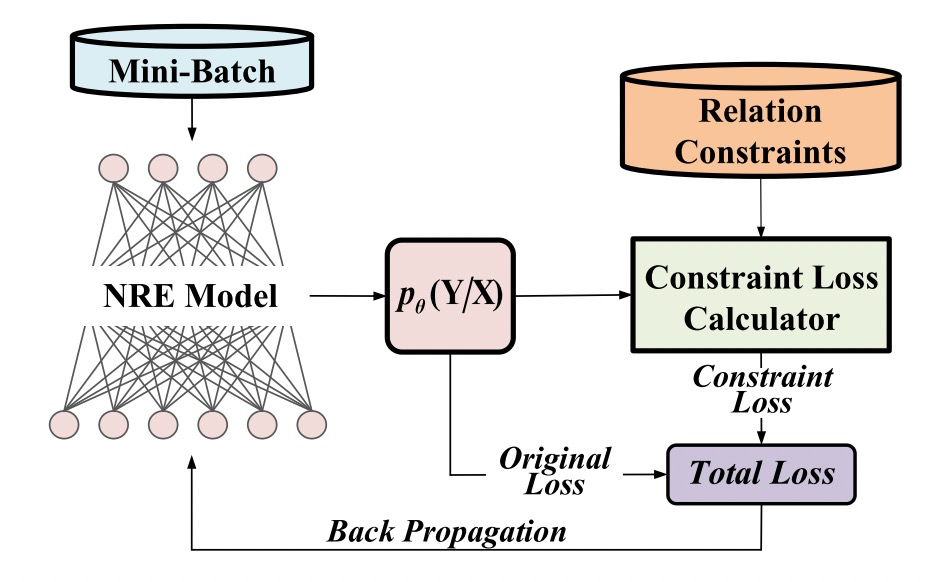

ConstrainRE(AAAI2020)[11]

关系抽取中,某些关系之间存在很强的语义先验约束,比如如果存在关系"首都"则大概率会存在关系"位于",北大的学者提出了ConstrainRE,通过显式引入关系之间的约束Loss来增强关系抽取性能。

Out of Distribution信息抽取

对于未知实体、关系等的信息抽取,可采取前面提到的低资源信息抽取模型,也可以采用开放域信息抽取的方法。

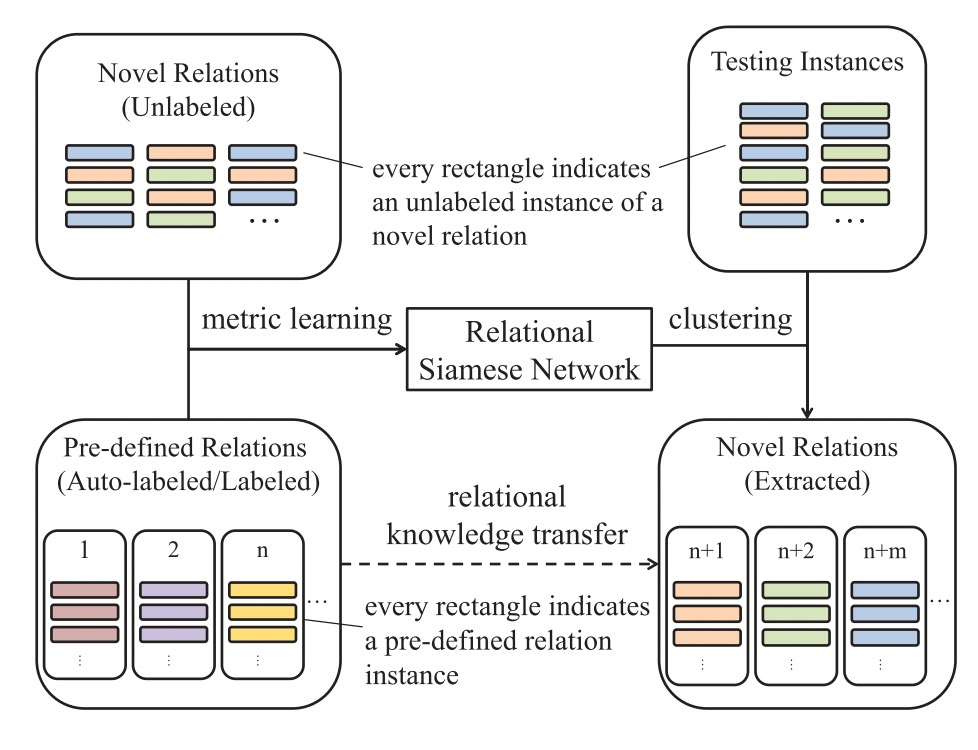

RSN(EMNLP2019)[12]

清华刘知远老师团队提出了基于关系孪生网络的开放领域关系抽取模型,此方法主要动机为迁移已有的远监督关系知识到未知的开放领域关系,并通过Metric Learning 和聚类实现未知关系的抽取。

联合信息抽取

联合信息抽取主要分为实体、关系联合抽取,实体事件联合抽取等。

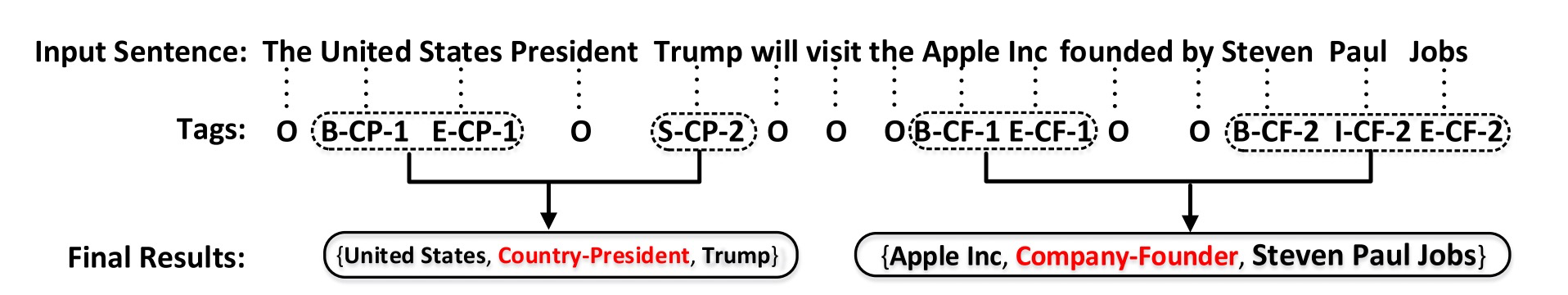

Novel Tagging(ACL2017) [13]

针对关系抽取和实体识别联合抽取任务,中科院自动化所的学者提出了一种新颖的标注方法,开创了实体关系联合抽取的先河,并启发了一系列联合抽取工作,然而此方法无法抽取overlapping的元组。

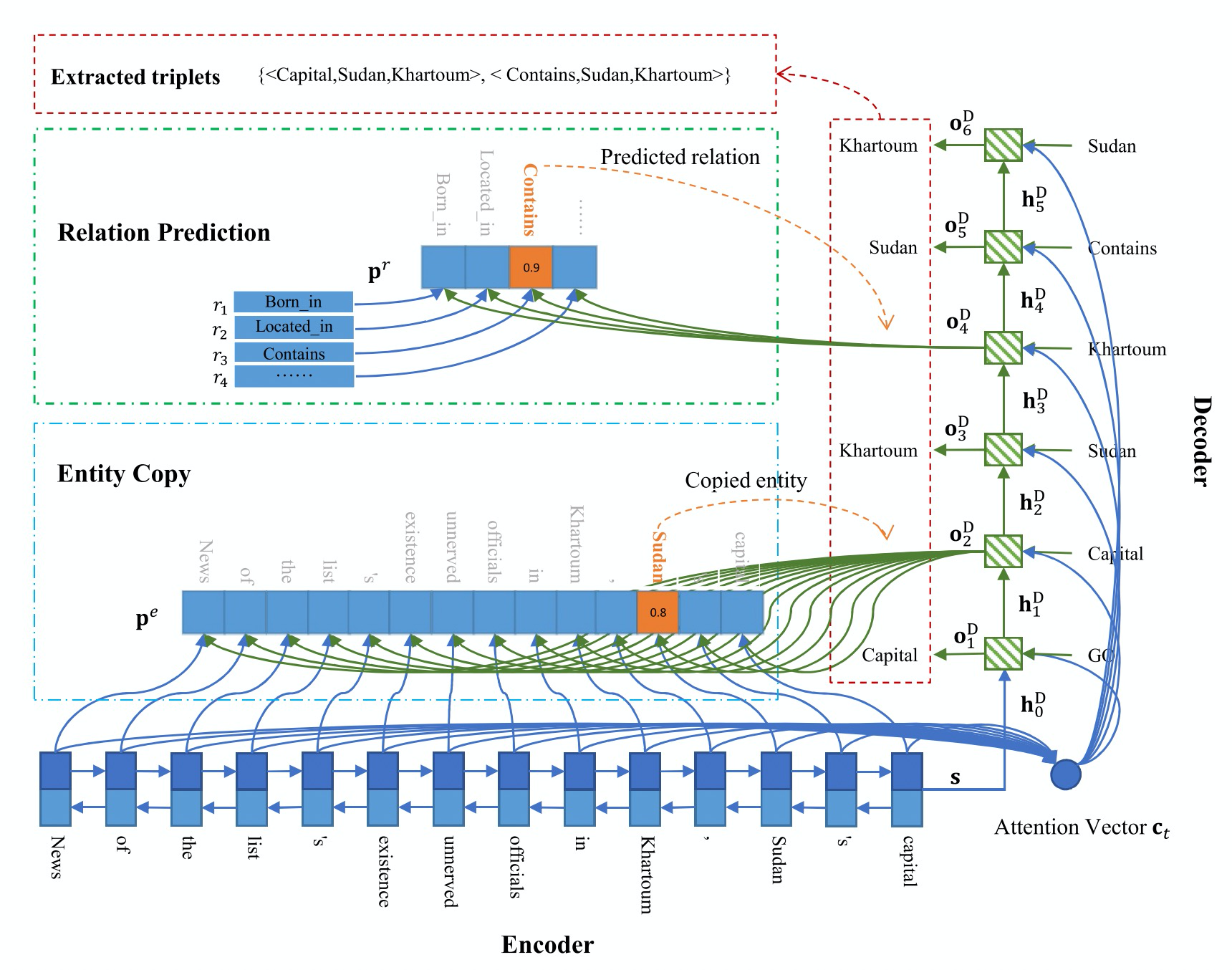

CopyRE (ACL2018) [14]

中科院学者创新得将实体关系抽取任务定义为seq2seq任务,并实现多关系多实体联合抽取,且能够处理overlapping问题。

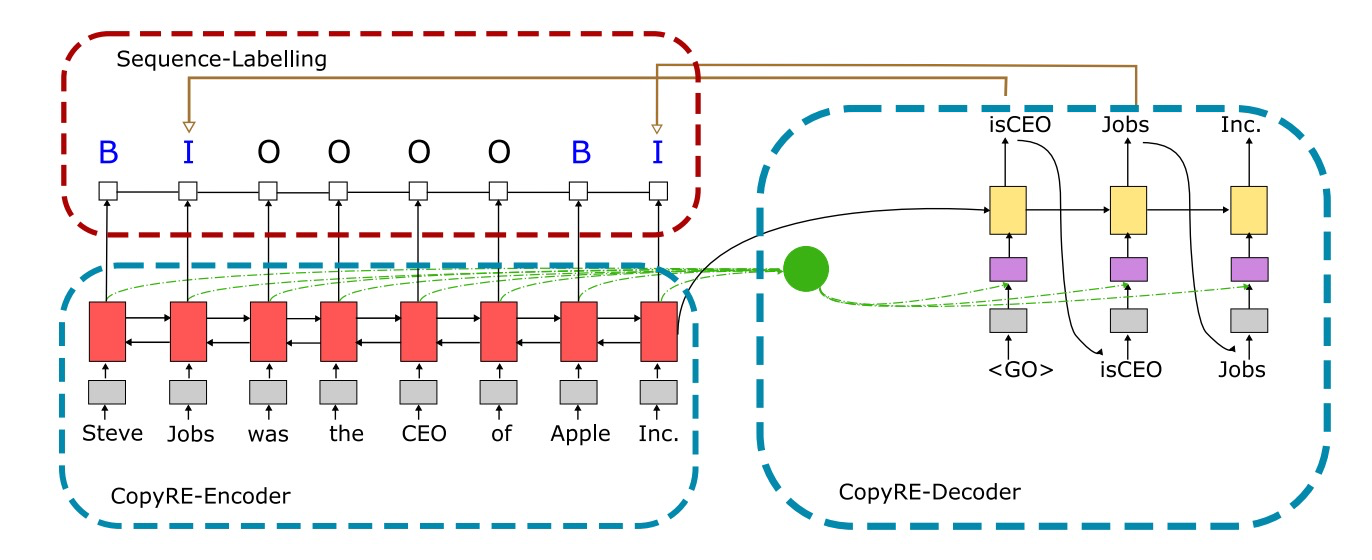

CopyMTL(AAAI2020)[15]

针对CopyRE存在无法区分头尾实体和无法预测多个token的实体的问题,UIUC学者提出了CopyMTL模型,此模型主要通过多任务学习方式,将实体抽取部分单独作为序列标注任务,方法简单易懂,效果不错。

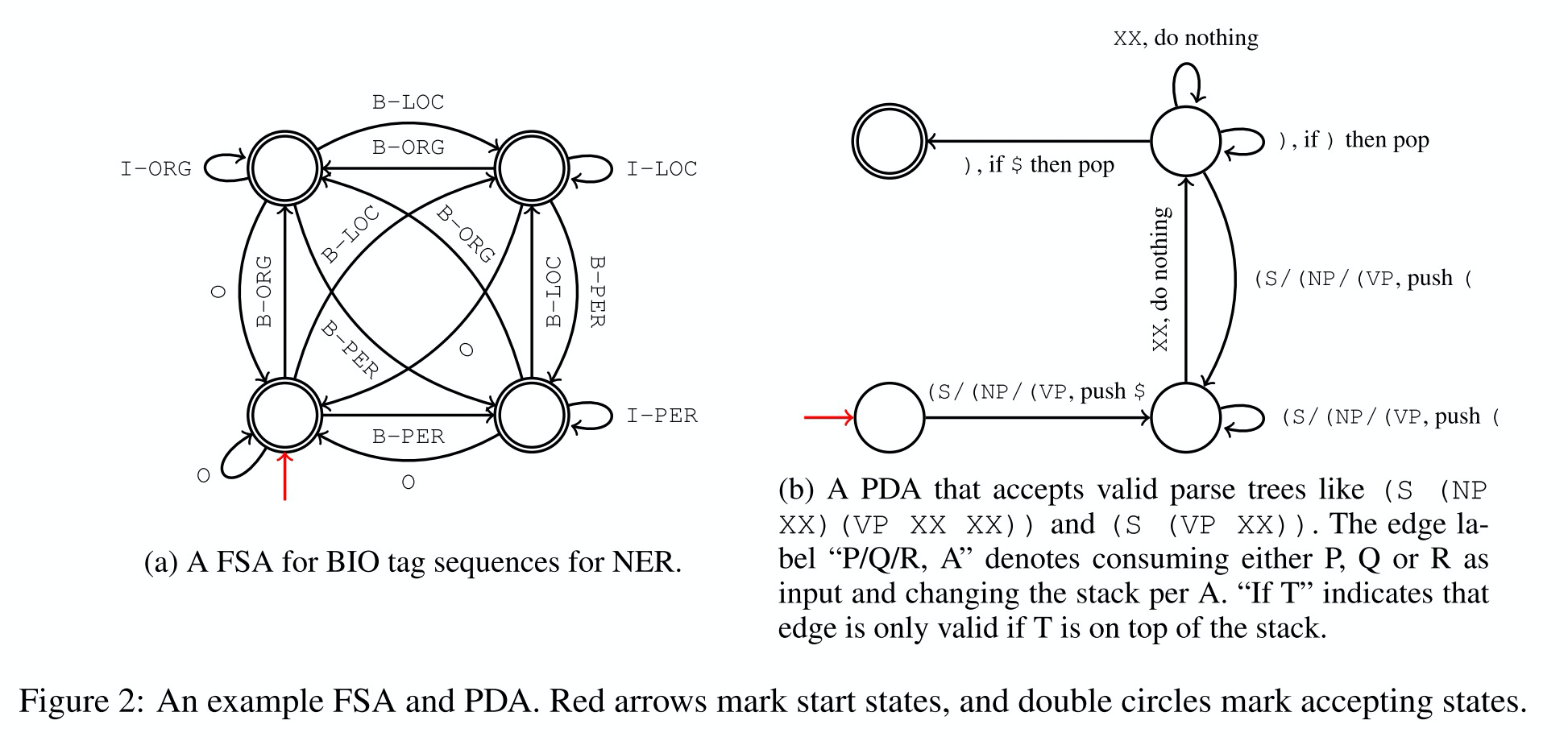

FSA&PDA(EMNLP2019)[16]

针对标签之间存在一定强关系约束的特点,谷歌和宾夕法尼亚大学学者提出了基于自动机约束的序列预测模型,此模型虽然仅应用在序列标注任务,且存在一定的局限性,但是模型的思考角度非常新颖,且自动机的自动学习和约束机制带来的很大的启发,这种机制是否可以应用在关系、事件抽取值得探索。

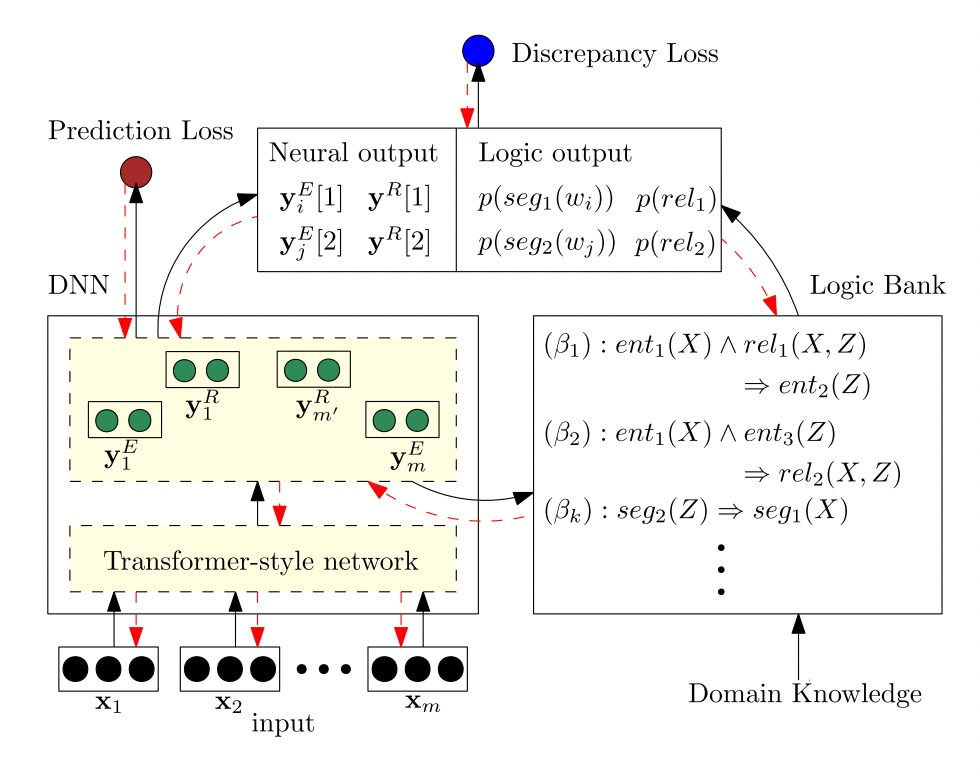

LogicRE(AAAI2020)[17]

针对实体识别和关系抽取之间存在一定的逻辑约束现象,南洋理工大学王文雅老师团队提出了基于描述逻辑的实体识别和关系抽取模型,此方法也是少有的融合符号主义和联结主义的工作,值得一读。

信息抽取新的征程

随着NLP的不断发展,也涌现了一些新的信息抽取路线,这里总结如下:

基于预训练模型的直接信息抽取

这里的方法主要是通过预训练模型以构造完形填空或序列标注的方式直接抽取元组,代表工作有COMET[18] , 这些方法一般直接基于Transformer,有些类似于通用信息抽取, 详见 [从感知到认知:浅谈知识赋能自然语言处理]()

基于阅读理解的信息抽取

香浓科技学者在ACL2019论文[19]将实体、关系抽取改造成为机器阅读理解任务,角度新颖,然而对于长文档此方法存在信息遗忘和性能问题。

基于序列生成的文本信息抽取

此类方法将抽取任务定义为seq2seq任务,主要代表方法有CopyRE和CopyMTL等。

开源工具

实体识别

bert-ner https://github.com/macanv/BERT-BiLSTM-CRF-NER

关系抽取

DeepNRE 清华刘志远老师团队https://github.com/thunlp/OpenNRE

DeepKE 浙大陈华钧老师团队 https://github.com/zjunlp/deepke

通用工具

StanfordNLP https://stanfordnlp.github.io/stanfordnlp/

DeepDive http://deepdive.stanford.edu/

Snorkel https://github.com/snorkel-team/snorkel

OpenIE https://nlp.stanford.edu/software/openie.html

Textrunner http://openie.cs.washington.edu/

Fastnlp https://github.com/fastnlp/fastNLP

中文开放领关系抽取 https://github.com/lemonhu/open-entity-relation-extraction

哈工大LTP https://www.ltp-cloud.com/

Snownlp https://github.com/isnowfy/snownlp

HanLP https://github.com/hankcs/HanLP

数据集

CoNLL2003 https://github.com/synalp/NER/tree/master/corpus/CoNLL-2003

OntoNotes https://github.com/yhcc/OntoNotes-5.0-NER

MSRA https://github.com/buppt/ChineseNER/tree/master/data/MSRA

Weibo NER https://github.com/OYE93/Chinese-NLP-Corpus/tree/master/NER/Weibo

Resume NER https://github.com/jiesutd/LatticeLSTM/tree/master/ResumeNER

Fewer、 semeval 、Wiki80、NYT10 https://github.com/thunlp/OpenNRE/tree/master/benchmark

TECRED https://nlp.stanford.edu/projects/tacred/

ACE05 (实体、关系、事件抽取) https://catalog.ldc.upenn.edu/LDC2006T06

下一代信息抽取系统畅想

- 更少的样本,更强的泛化能力。未来的信息抽取模型也许只需要少量的样本就可以获得更好的性能和更强的泛化能力。

- 多模态信息抽取。未来的信息抽取模型也许可以从图像、视频、音频等数据中抽取知识。

- 自动化端到端。未来的信息抽取模型可以自动进行网络架构设计、自动超参数优化,实现AutoML based Information Extraction 。

- 通用信息抽取。未来信息抽取也许范围更广,可以实现细粒度情感标签、通用槽位、观点等信息的抽取。

- 可解释信息抽取。未来信息抽取也许可以生成可解释的抽取规则、预测结果的置信度等,实现模型的可解释、可控制。

[1]TENER: Adapting Transformer Encoder for Named Entity Recognition

[2]Event Extraction via Dynamic Multi-Pooling Convolutional Neural Networks

[3]Meta-Learning with Dynamic-Memory-Based Prototypical Network for Few-Shot Event Detection

[4]Low-Resource Name Tagging Learned with Weakly Labeled Data

[5]Long-tail Relation Extraction via Knowledge Graph Embeddings and Graph Convolution Networks

[6]Matching the Blanks : Distributional Similarity for Relation Learning

[7]Improve Neural Entity Recognition via Multi-Task Data Selection and Constrained Decoding

[8]Reading the Manual : Event Extraction as Definition Comprehension

[9]Attention-Based Capsule Networks with Dynamic Routing for Relation Extraction

[10]ARNOR : Attention Regularization based Noise Reduction for Distant Supervision Relation Classification

[11]Integrating Relation Constraints with Neural Relation Extractors

[12]Open Relation Extraction : Relational Knowledge Transfer from Supervised Data to Unsupervised Data

[13]Joint Extraction of Entities and Relations Based on a Novel Tagging Scheme

[14]Extracting Relational Facts by an End-to-End Neural Model with Copy Mechanism

[15]CopyMTL: Copy Mechanism for Joint Extraction of Entities and Relations with Multi-Task Learning

[16]A General-Purpose Algorithm for Constrained Sequential Inference

[17]Integrating Deep Learning with Logic Fusion for Information Extraction

[18]COMET: Commonsense Transformers for Automatic Knowledge Graph Construction

[19]Entity-Relation Extraction as Multi-Turn Question Answering