來源 阿里語音AI 公眾號

“ 對未來十年作出預測,絕對是一件冒險的事情。事實已經無數次證明,科技的發展往往遠遠超過人們的想象,且近年來各類技術進展的加速度,更有不斷加快的趨勢。

站在一個全新十年的節點上,我們不妨回望過去,再試圖展望未來。試著通過這些回望和展望,能夠尋覓到技術新十年的蛛絲馬跡。

回望過去,在語音技術的應用和研究領域發生了許多有意義的標誌性事件。”

第一,手機場景被“解鎖”。

語音技術的應用一直以來都是一個不斷突破並“解鎖”新的場景的過程。眾所周知,語音是人與人之間最自然的交互方式。人類對語音的聽清、聽懂,幾乎是“放之四海而皆準”的。

應對不同的背景噪音、口音、說話方式、主題等等,人類都能幾乎無障礙的使用語音進行交流。例如,即使在一個雞尾酒會上,人類說話人之間仍能交談自如(Cocktailparty effect)。

然而對機器來說,聽清、聽懂人類語音,到目前為止仍是遠未解決的問題。過去我們笑稱“脫離現實場景去空談識別準確率都是耍流氓”

語音識別的準確率直接決定了後續的語義理解、對話等交互技術的性能,因此,不斷提升語音識別在各類複雜場景下的準確率、不斷讓此前做不了或做不好的場景變得可能,一直是無數研究者和實踐者孜孜以求的課題。

過去,以Siri發佈開始,到Googlevoice search的推出,再到shortmessage dictation(例如今天的一些手機語音輸入法),手機場景的語音交互正式跨過了門檻,被逐漸解鎖。

要知道在此前,語音識別技術頂多能夠在close-talking microphone(近講麥克風)條件下,做speaker-independent(說話人無關)的、有限場景的聽寫任務,且準確率有限(典型的英文word errorrate在30%左右)。更不要說類似Siri的手機語音助手交互式應用了。

實現這一“解鎖”,主要歸功於移動互聯網的發展,讓大規模手機語音數據的收集變得可能;其次是以深度學習為代表的機器學習技術應用於語音領域,並持續的取得發展;再次是以GPGPU、分佈式計算集群為代表的算力的大幅提升;最後是與語音交互有關的部分NLP技術的長足進展,包括超大規模語言模型、NLU等。

第二,遠場語音交互被“解鎖”。

與上述手機場景一樣,以Amazon Echo及其背後的Alexa的發佈為代表,遠場語音交互在過去的十年被“解鎖”。這主要得益於麥克風陣列信號處理、語音喚醒技術及IoT硬件的突破。當前,智能音箱已經不陌生,各類帶有遠場語音交互能力的IoT硬件也正如雨後春筍般層出不窮。

今天,如果加上手機、智能音箱等,全球預計有超過30億語音助手在為人類服務。我們正通過這種人與人之間最自然的交互方式,獲取移動互聯網上的內容和服務。

沿著遠場語音交互的路徑,以麥克風陣列、多模態技術為加持的公共空間嘈雜環境下的語音交互也在逐漸得到解鎖。

今天我們可以看到,即使在嘈雜的地鐵站、餐廳,一些語音售票問詢機、語音點餐機等,都逐步得到應用。

這類場景此前因為噪聲、特別是人聲噪聲的干擾問題,通常無法得到理想的語音交互體驗。實踐者的探索目前已延申至這個領域,並取得了初步的成功。

第三,語音合成“成長的煩惱”

以前,每一位從事語音合成的技術人員,都夢想有朝一日由機器合成的語音可以接近真人發音。

今天,隨著技術的突破性進展,我們已經從努力追求真人發音,到開始擔心機器語音合成技術過於逼真、以致“以假亂真”的冒用問題,大家可以去體驗當前最新的語音合成技術能夠達到的水平。

今天,定製一個高品質聲音所需的成本(錄音的時間和資金)已經比十年前降低了至少一個數量級。定製一個較低音質、娛樂性的、普通人的聲音,只需要用手機錄製大約20句話。

這意味著在未來,我們每個人都有望定製一個自己的“聲替”,保存自己的聲音特徵,或替你去回答別人打來的電話等等。

第四,Smooth-talkingAI assistant正走進人類的生活

以Google的Duplex demo為起點,smooth-talking AIassistant被MITTechnology Review評選為2019年十大科技進展,阿里巴巴的名字因為菜鳥語音助手的成功應用也被提及。

今天越來越多的電話是由機器人接起,或由機器人呼出的。不知各位在過去的一年是否也有接到過AI打來的電話呢?

第五,語音技術在研究領域的進展未曾停止

歷史上語音技術在研究領域的進展通常脈衝式的。以語音識別準確率為例,通常一個新的技術被提出後,會帶來突破性的進展,伴隨它的則又是長達10年的沉寂期。

例如,隨著80年代末大詞彙量說話人無關連續語音識別系統被提出,一直到90年代末,各類discriminativetraining準則才再一次將語音識別準確率推向下一個高度,隨後又是10年左右的沉寂。

語音合成也類似,從2000年左右HMM-basedTTS開始,也經歷了類似長度的沉寂期。

過去,我們欣喜的看到,在語音技術領域的創新,表現在語音識別準確率、語音合成自然度等指標上,不再是脈衝式的靈光一現,更像是細水長流式的持續演進。而且從十年的尺度上回看,日積月累的進步竟累積成了突飛猛進。

在語音識別上,DNN、CNN、RNN、(B)LSTM、FSMN、CTC、attention、transformer等不斷刷新準確率;語音合成上,DNN、RNN、WaveNet、Tacotron等不斷刷新自然度;聲紋上,i-vector、x-vector等技術不斷推動其取得更高精度。相應的,與語音交互有關的NLP技術,也隨著NLP大方向上的進展而持續取得進步,且語音與NLP的基礎技術(例如transformer)有逐漸融合的趨勢。

第六,語音技術開始展現出更廣闊的商業化前景

以前,在工業界的語音應用幾乎沒有什麼太大的商業價值。很多時候甚至是為軟件系統的accessibility功能而存在的(例如為TTS為視障、ASR為殘障人士提供操作界面)。這也間接造成世界上只有一些大公司玩得起語音技術。由於招聘規模有限,語音方面人才的培養也逐漸降溫。

今天,伴隨著AI技術又一春,以及語音技術本身水平的提升,語音已經開始展現出比以往任何時候都廣闊的商業化前景。隨著而來的,是大公司加大投入,以及一批創業公司的誕生、發展,直至語音技術領域人才的炙手可熱。

今天在電話客服、司法政務、教育、互聯網、IoT、電力等等行業,語音技術的應用方興未艾。在語音技術的應用方面,中國也逐步實現了從趕到超的跨越,在很多方面走在世界前列,也發展出眾多的傳統語音技術提供商及雲上的語音技術提供商。

第七,公民個人隱私等問題正日益受到重視

隨著語音助手類應用越來越多走進人們的日常生活,語音技術在公民個人隱私、數據合規、反騷擾甚至詐騙等方面正日益受到更高的重視,相關的熱點事件偶有發生,行業規範和法律法規亟待完善。

可以預見隨著下一個十年的到來,這方面的規範會逐漸加強,人們仍需尋找技術進步、安全,與個人隱私方面的平衡和共識。

下面我們逐一來看一下各個語音相關技術能力上的過去回顧和未來展望。

語音識別研究

語音識別的研究由來已久,最早可以追溯到上世紀50年代,但是在過去很長時間語音識別普遍採用的是基於混合高斯模型-隱馬爾可夫模型(Gaussian Mixture Model-Hidden Markov Model, GMM-HMM)的框架。

2009年,深度學習技術被應用於語音識別,基於混合深度神經網絡-隱馬爾可夫模型(DNN-HMM)的框架替代了原來的GMM-HMM框架。

進一步的, 通過結合大數據,計算力,更強建模能力的神經網絡結構,基於神經網絡的語音識別系統性能達到了實用化的要求,在智能交互系統裡得到廣泛的使用。

近幾年,語音識別的研究主要的方向是如果構建端到端的語音識別系統(End-to-End ASR)。傳統的語音識別裡,包含聲學模型、語言模型和發音詞典,整個識別系統的構建包含複雜的流程。

端到端語音識別的目標是簡化語音識別系統的構建流程,用一個神經網絡直接端到端建模語音信號和最終的輸出文本。

關於端到端語音識別主要的研究方向有兩個:1)基於Attention-Encoder-Decoder的端到端語音識別;2)基於RNN-Transducer的端到端語音識別。

目前端到端的語音識別的研究包含:

1)網絡結構的改進:從之前普遍採用的循環神經網絡,開始使用更多種類的網絡結構,例如深層的卷積神經網絡(DCNN),Transformer等等。

2)流式(streaming)識別:Attention-Encoder-Decoder採用的attention需要利用整句的信息沒法進行流式解碼,目前的研究主要關注在如何進行online attention。

3)小尺寸的端上語音識別模型:隨著IOT設備的普及,以及對用戶數據隱私的保護,可以運行在設備上的小尺寸的語音識別模型是一個很強的需求。

端到端的識別系統不需要使用額外的大尺寸的語言模型,剛好適合於端上語音識別的需求。

站在新的一個十年,未來構建小尺寸的流式端到端語音識別系統研究將成為工業界應用的趨勢。

除了端到端語音識別,關於多語種語音識別,多模態語音識別,複雜場景下聯合前端信號處理的語音識別也是目前語音識別研究領域關注的重點。

目前通用的中英混讀語音識別已經取得了顯著的進展,開始走向了實用化,進一步的如何擴展到更多語種,以及資源受限的語種是一個研究難點。

聯合音頻和視頻的語音識別(audio-visual ASR)在噪聲環境下展現出了很大的潛力,但是受限了訓練數據獲取的難度,目前主要還是停留於研究階段。

聯合前端信號處理的語音識別在噪聲環境下獲得了顯著的性能提升,但是讓識別系統能夠處理複雜的場景,例如雞尾酒會(Cocktail)問題,需要聯合更多的技術,例如陣列信號處理,說話人分離,語音聲學建模等。語音識別的研究由來已久,最早可以追溯到上世紀50年代,但是在過去很長時間語音識別普遍採用的是基於混合高斯模型-隱馬爾可夫模型(Gaussian Mixture Model-Hidden Markov Model, GMM-HMM)的框架。

2009年,深度學習技術被應用於語音識別,基於混合深度神經網絡-隱馬爾可夫模型(DNN-HMM)的框架替代了原來的GMM-HMM框架。

進一步的, 通過結合大數據,計算力,更強建模能力的神經網絡結構,基於神經網絡的語音識別系統性能達到了實用化的要求,在智能交互系統裡得到廣泛的使用。

近幾年,語音識別的研究主要的方向是如果構建端到端的語音識別系統(End-to-End ASR)。傳統的語音識別裡,包含聲學模型、語言模型和發音詞典,整個識別系統的構建包含複雜的流程。

端到端語音識別的目標是簡化語音識別系統的構建流程,用一個神經網絡直接端到端建模語音信號和最終的輸出文本。

關於端到端語音識別主要的研究方向有兩個:1)基於Attention-Encoder-Decoder的端到端語音識別;2)基於RNN-Transducer的端到端語音識別。

目前端到端的語音識別的研究包含:

1)網絡結構的改進:從之前普遍採用的循環神經網絡,開始使用更多種類的網絡結構,例如深層的卷積神經網絡(DCNN),Transformer等等。

2)流式(streaming)識別:Attention-Encoder-Decoder採用的attention需要利用整句的信息沒法進行流式解碼,目前的研究主要關注在如何進行online attention。

3)小尺寸的端上語音識別模型:隨著IOT設備的普及,以及對用戶數據隱私的保護,可以運行在設備上的小尺寸的語音識別模型是一個很強的需求。

端到端的識別系統不需要使用額外的大尺寸的語言模型,剛好適合於端上語音識別的需求。

站在新的一個十年,未來構建小尺寸的流式端到端語音識別系統研究將成為工業界應用的趨勢。

除了端到端語音識別,關於多語種語音識別,多模態語音識別,複雜場景下聯合前端信號處理的語音識別也是目前語音識別研究領域關注的重點。

目前通用的中英混讀語音識別已經取得了顯著的進展,開始走向了實用化,進一步的如何擴展到更多語種,以及資源受限的語種是一個研究難點。

聯合音頻和視頻的語音識別(audio-visual ASR)在噪聲環境下展現出了很大的潛力,但是受限了訓練數據獲取的難度,目前主要還是停留於研究階段。

聯合前端信號處理的語音識別在噪聲環境下獲得了顯著的性能提升,但是讓識別系統能夠處理複雜的場景,例如雞尾酒會(Cocktail)問題,需要聯合更多的技術,例如陣列信號處理,說話人分離,語音聲學建模等。

語音合成研究

最近兩年的TTS(語音合成)可謂是波瀾壯闊,整個方向的技術、產品和業務形態都發生了翻天覆地的變化。

這個變化首先是從學術界發起的。雖然整個deep learning技術在2010年後就被引入到了語音識別領域,併發揮了巨大的作用。但在TTS方向,一直應用的比較緩慢。直到2016年Google的WaveNet、2017年MILA的Char2Wav和2017年Google的Tacotron,這幾個工作的提出,才將deeplearning的強大能力賦予整個TTS方向,從音質、表現力和建模難度幾個方面都顯著的超越了過去。

以這幾個傑出工作為開端,學術界和工業界的同學也紛紛在各自領域進行了延伸,形成了目前百花齊放的局面。

而最近兩年,最大的變化是大家開始將學術界的第一流成果帶入到實際產品中,將高體驗的音質效果、接近真人的表現力和小數據量定製聲音的能力產品化。

例如Google Cloud在2018年上線了基於TPU的WaveNet產品化,Microsoft Azure在2018年上線了基於GPU的全Neural產品方案。阿里雲也在2018年上線了全Neural產品方案,並且考慮到實際客戶和業務的擴展需求,也經過大量的優化工作,該方案是目前業內唯一的完全基於CPU的全Neural產品化方案。

站在新的一個十年,隨著核心技術方案的更新換代,對應的產品和業務形態也隨之變化。

阿里巴巴集團客服和螞蟻客服已經採用了最新的TTS產品,為用戶提供更有表現力的智能客服體驗,2019年雙十一期間為數百萬用戶解答問題;天貓精靈也在2019年用最新的技術方案提供高體驗的合成效果,還能為父母根據少量數據定製父母聲音的TTS。

同時,阿里雲也在2019年對外推出新一代語音合成定製服務,可以依靠新技術提供快速低成本定製服務,例如移動端第一財經APP,就是基於用戶提供的財經新聞主播數據,定製了一款高表現力合成聲音,從而可以在APP上為實際用戶提供高體驗的新聞朗讀效果。

智能麥克風

自從100多年前發明麥克風以來到大約2010年,麥克風的形態從Ribbon,動圈,炭粒,PZT,電容, ECM到MEMS等發生了多次變化,但作為語音通信器件的功能一直沒變。

隨著近年來人工智能的發展,麥克風被賦予了新的功能,即作為自動語音識別的前端拾音器件,接收到的聲信號不再是給人耳聽的,而是給具有語音識別功能的機器聽的了,從用戶角度看,麥克風擁有了智能,即麥克風能聽懂人聲與人類交流。

例如這幾年流行的智能音箱,則是麥克風智能拾音的一個典型的產品形態。

目前,像手持麥克風,非免提的手機等場景的近場智能拾音已經基本不成問題,但遠場智能拾音仍是一個挑戰。

相對於目前火爆的視頻AI,由於聲環境的複雜性,遠場智能語音的信號鏈路更長。

首先,由於房間混響的存在,遠場麥克風收到的信號不再是純淨的目標聲源信號,而是原始聲源與房間傳遞函數卷積而來的,而且,房間傳遞函數往往由於空氣擾動,溫度的細微變化等原因是時變的,特別是在高頻頻段;

其次,由於環境聲噪聲與元器件電噪聲的存在,遠場麥克風信號的信噪比可能不高。

另外,像智能音箱場景,從揚聲器來的聲學回波會耦合到麥克風,而目前的自適應抵消器技術在一些場景下還不能完全消除回波。

最後,非目標語音的干擾人聲也帶來挑戰。

對於上述挑戰,麥克風陣列作為一個明星技術被各大廠商廣泛使用,而智能拾音的性能則很大程度上取決於陣列信號處理算法, 算法的目標函數一般是提高DRR (Direct ReverberantRatio),信號噪聲比,信號干擾比與更徹底的回波消除。

相對於單個麥克風單元,麥克風陣列由於使用多顆麥克風而大大增加了自由度,這給算法工程師提供了很大的想象空間,各廠商的算法也百花齊放,最常用的算法有MVDR (minimum variancedistortionless response), GSC(general sidelobe canceller), BSS(blind source separation), etc。

阿里達摩院則是業內首家把信號處理算法與聲學設計相融合,提出了差分指向性麥克風陣列的概念,並且通過原型機證實了可行性:在真實的複雜聲環境下與國際知名品牌對比測試,達摩線性陣列拾音器具有明顯優勢。

基於麥克風陣列的智能拾音器一般有兩種產品形態:定向拾音與全向拾音。

定向拾音器一般用於可控的聲學場景,例如司法審訊場景,審訊人員與嫌疑人的位置是固定的,並且是預設的,所以拾音器的位置固定,且只需要拾取預定幾個方向的聲源,同時抑制混響與噪聲來提高DRR與信噪比,這類拾音器一般基於線性陣列。

全向拾音這個名稱則往往會導致一些混淆,因為有一類麥克風單元也稱為全向麥克風,但DRR不高,高品質的全向拾音器則利用多顆全向/定向麥克風單元來達到全向拾音且高DRR的目標,這一般基於單環或多環的圓形陣列。達摩院基於定向單元的圓形拾音器與業界標杆做過對比,主觀評價明顯優異。

智能麥克風的陣列算法除了上述的四個目標,分角色的語音轉文字則是一個比較新的產品需求。該需要的技術難點之一在於說話人在說話時的位置可能會時變,說話時的頭的朝向也有可能會變,例如利用白板作presentation的場景,所以基於麥克風陣列角度的分角色就有可能不準確。很多廠商也在嘗試結合聲紋技術來解決這個問題。

智能拾音器的另一個趨勢是功能上的all-in-one:通信功能,智能語音功能,與錄音筆功能。這三個功能對於語音的要求很多是相同的,例如降噪,去混響。

但有些方面則不同,通信功能的要求是低延遲,低失真,高帶寬,多人說話時需要混音,以及適當的混響與舒適噪聲填充;智能語音功能的要求則對延遲,失真要求沒那麼高,但對多人同時說話需要分離出目標語音;錄音筆的要求與通信要求有些類似,但在延遲上可以放寬,不需要填充舒適噪聲。

站在新的一個十年,智能拾音器作為Speech AI鏈路中的第一個鏈條則扮演了重要角色,其聲學設計與信號處理直接影響到系統的性能,所以開始受到了業界越來越多的重視。

語音是信息的一個基本載體,有了人類以來就一直就有語音,是個歷史悠久的研究領域,在這個人工智能時代,語音必將煥發出新的生命。

語音交互

2019年,該領域一個很明顯趨勢是語音入口的總量持續增長:根據Juniper Research的數據,目前全世界已經累計有25億個語音助理存在,包含了智能家居、智能車載、智能手機和可穿戴設備等諸多品類。

其中作為最為引人關注的智能音箱品類,根據 Strategy Analytics的數據,安裝總量從2018年的1.14億臺上升到2019年的2.079億臺。

另外,智能穿戴品類中TWS耳機品類迎來大爆發,2019年全年全球出貨總量超過1億臺,其中各個主要的手機廠商是最積極的參與者,帶來的一個可能的後果就是用戶使用率本不高的手機語音助手,隨著TWS耳機的普及可能迎來一個使用率的提升。

另外,一個趨勢,就是語音入口迅速往更加多樣的設備上進行擴展,比如亞馬遜就推出帶Alexa的眼鏡、TWS耳機、微波爐、夜燈等等,並且開始支持內存小於1MB的低資源嵌入式系統設備,這些都為語音設備的擴展帶來了更多的可能。

另外一個方面,語音交互本身朝著個性化交互和更加自然的交互方向發展。在個性化服務方面,蘋果的HomePod可以根據聲音識別不同家庭成員的身份,並且根據用戶的身份生成用戶profile,提供個性化音樂、日曆、語音備忘錄和提醒等服務。

在讓交互更加自然方面,全球主要的語音交互提供商推出了連續自然對話的能力,可以做到跟設備一次喚醒,多次對話。

站在新的一個十年,隱私問題也將成為未來語音設備普及的核心問題之一。

這是因為隨著語音入口的普及,語音交互也收到了多方面的挑戰。其中最大的一個是語音設備引起的安全和隱私問題開始受到媒體和大眾的關注,2019年4月份起,媒體開始關注Alexa&GoogleAssistant 的隱私問題,對業界普遍採用的使用用戶數據進行標註和訓練的方法提出了挑戰並做了大肆報道。

在對用戶隱私及其敏感的歐洲地區(有GDPR等用戶數據保護協議),歐盟對Alexa使用用戶語音數據的行為做出了調查。最後作為應對,Alexa可以讓用戶18個月定期自動刪除錄音的功能。

模組化智能語音硬件

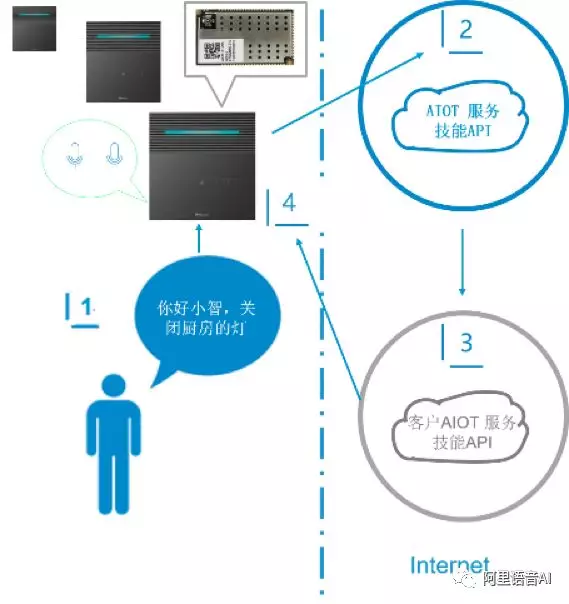

物聯網通信模組是將基帶芯片、射頻芯片、存儲芯片、電容電阻等各類元器件集成到一塊電路板上,提供標準接口,各類物聯網終端通過嵌入物聯網通信模塊快速實現通信功能。

同樣地,將智能語音涉及到的麥克風陣列拾音、遠場語音增強算法、語音喚醒、本地語音識別乃至本地語義理解等,也集成到一塊電路板上,提供標準的接口,各類智能語音設備也能通過標準化模組,快速實現語音連接功能。

1.用2個關鍵連接能力賦能

語音模組通過提供2個關鍵連接能力(語音連接能力和網絡連接能力),賦能下游終端廠商和應用廠商,無需深度的通信和聲學支持,就能快速完成一款產品的落地。

2.模組的能力架構

圖表 1. 被控型架構(傳統IoT模組)

圖表 2. 達摩院自主架構

圖1所示的傳統IoT架構,依賴音箱(或網關)作為控制中心,只能在有限的空間,提供比較單一的服務。

如圖2所示,我們將語音和網絡能力集成模組中。下游廠商在同時獲得語音和網路連接能力的同時,還能開發自己的BOT,形成設備自助工作、甚至多種設備系統控制的能力架構。並且,在我們各種形態的模組,都能該系統能力架構。

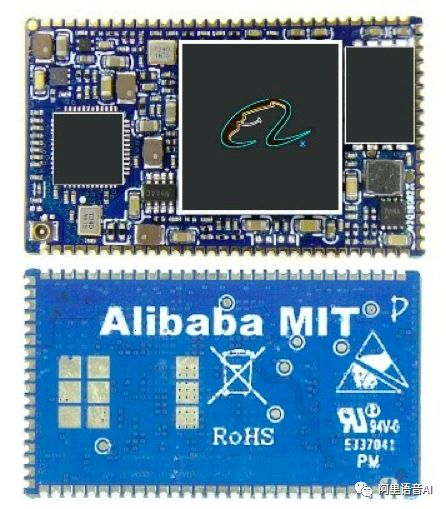

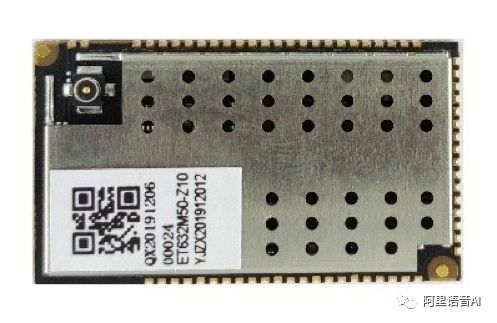

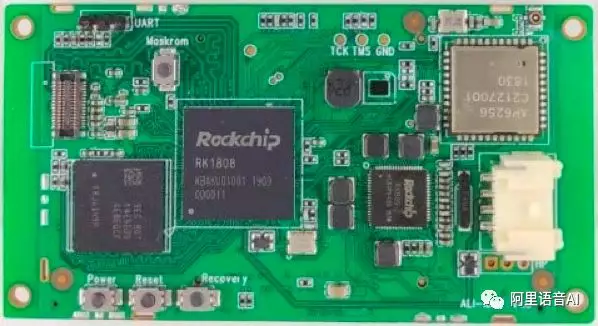

3.模組的產品形態

圖表 3. Linux版高配模組

圖表 4. RTOS低資源模組

圖表 5.音視頻多模態模組

隨著無處不在的語音智能戰略的推進,以電視、音箱、故事機、售票機為代表的設備智能化趨勢明顯,遠場和多模態語音交互技術發展進入深水區,語音實驗室前端處理組在低於-30dB的極低信回比、低於-15dB的極低信噪比、公眾空間等場景的語音增強算法得到進一步錘鍊,持續在最具挑戰的各類邊界場景能力保持業界領先。

同時隨著接入語音交互能力的設備進一步進入算力低端化,邊緣語音交互算法的資源(內存、算力、功耗等)開銷要求逐步嚴格,對語音交互高性能的算法設計和工程優化提出了更高要求,達摩院語音實驗室結合領先的算法設計、對理論和場景的深入理解,結合模組和芯片戰略,與平頭哥深入合作,軟硬芯一體化深度優化,推動達摩院領先算法與平頭哥「無劍SoC平臺」融合,助力語音算法從芯片端開始的技術普惠生態建立。

站在新的一個十年,隨著深度學習技術的深入,芯片和模組上的前端處理算法會進一步融合基於數理方程的信號處理和基於深度神經網絡的機器學習方法,甚至進一步的,會出現完整的端到端建模的神經網絡模型,實現回聲消除、降噪、語音喚醒和語音識別等交互功能在統一低資源模型上的落地。

感知計算與認知計算會取得突破性進展,通過創新的聲學設計、信號處理和深度學習,「雞尾酒聚會」問題將會得到解決。創新的算法進展也會進一步推動軟硬一體、感知認知一體的深入,芯片等硬件會出現認知反饋型的設計,存算一體、類腦計算取得實質性突破。

公眾場所智能語音技術應用

公眾場所強噪音環境下的語音識別一直是個比較困難的問題,也極大的限制了語音交互技術在公眾場所的應用和普及。

之前國內的主要語音廠商都曾嘗試過在公眾場所應用語音識別,但是都因為無法解決噪音干擾問題而失敗。自2017年底阿里巴巴達摩院通過結合多模態、改進信號處理、以及語音識別、語義理解等方面全鏈路的優化,成功的解決了公眾場所噪音環境的下的語音識別問題。

在2018年初將這項技術迅速的從實驗室落地到生產環境中,推出第一代面向公眾場所的語音交互技術方案。這套語音交互技術實現了強噪音環境下的語音識別,能在85-90db背景噪音下實現90%以上的語音識別率,並且支持免喚醒語音交互,流式多輪多意圖語義理解等功能。

在2019年達摩院又再次在第一代的技術的基礎上,推出了第二代多模態語言交互技術方案。第二代相對於第一代在成本,功耗,性能,體積,集成度都有巨大的進步,還增加普通話和方言的自動區分識別,高擬真度語音合成等新功能,整個技術水平相對競品整整領先一代。

隨著公眾場所強噪音環境下語音識別技術的突破,原本難以實現的在公眾場所用語音交互也變的可行和成熟。公眾場所可能未來會成為家居和車載以外另一個語音交互應用的重要場景。

在這些場所中,交通領域對於語音交互應用走在了最前面。目前以語音售票機和語音問詢機為代表的公眾空間語音交互產品正在越來越為交通行業所接受和認可。目前已經在全國一些城市的多個交通樞紐都部署了語音售票機,並在過去的一年中服務了上百萬旅客,得到各方好評。現在越來越多的城市開始進一步嘗試運用語音問詢機去解答客戶問題,解放人力,提高服務效率。同時在類似黨建,稅務,醫院,景區等場景也逐漸開始運用語音交互為客戶服務。

語音識別“自學習”技術

在語音AI技術浪潮中,場景化和碎片化仍然是阻礙AI產業化落地的難題,即便常規AI廠商投入大量人力和財力來進行領域模型和重點項目專項調優的建設,但也僅僅只能覆蓋非常有限的場景。

為了從根本上解決這一語音技術供給問題,達摩院語音實驗室17年專有云發佈了自學習平臺這一語音技術供給基礎設施,並在18年公共雲正式上線,提供人名/地名、業務關鍵詞、句子&篇章級定製優化能力。它把傳統模型優化調參、評估、上線的複雜過程變成了數據驅動的點擊動作,使得識別效果優化不再依賴於語音識別廠商的專家服務,讓每一個合作伙伴甚至最終客戶的運營人員無需瞭解AI技術即可自主自助快速顯著提升自己場景的識別準確率以滿足業務需求,樹立了系列標杆案例。

在過去的一年裡,一方面我們發佈了自學習平臺2.0,正式將聲學定製優化加入到自學習序列,並開始探索從數據抽取到上線的全鏈路服務能力。

另一方面生態夥伴的力量開始逐漸爆發,在自學習平臺的支持下,優化問題開始逐漸降維成數據問題,不少擁有數據的合作伙伴紛紛加盟,開始建立其自己行業領域模型,大幅改善識別效果,語音AI在行業落地的“最後一公里”問題開始逐漸得以更好解決。

更讓人高興的是越來越多的友商開始加入我們改變語音供求關係的行列。微軟在2019年正式發佈了Custom Speech對外提供聲學和語言模型的定製能力,並以預覽版地方式在Office 365中提供組織級別的場景話術和人名的優化能力,這一做法也與我們從18年開始在釘釘的探索不約而同。同樣,百度也在今年4月正式發佈了語音識別自訓練平臺,提供對於語言模型的定製能力。

聲紋及音頻分析技術

達摩院語音實驗室聲紋及音頻分析技術團隊,近一年來集中對深度神經網絡框架結構進行創新,將發音內容引入到網絡建模中,在公開的聲紋識別測試數據集上,系統性能取得非常顯著的提升。同時,探討了具有多會話註冊和噪音的魯棒聲紋識別技術,重點在於對註冊和開發數據中呈現的聲紋信息的組織和利用;長時無關任務下,與當前最先進的系統相比,為基於低維i-Vector建模探索出一套更多樣化的解決方案,實現了建模前信息配置多樣化,從而支持多模型混合部署,降低了計算成本。

達摩院語音實驗室開創性地解決了聲紋識別技術在大規模應用過程中遇到的數據標註難題,通過循環學習方法,讓模型具備從“簡“到“難“學習並掌握不同數據、不同信道、不同文本內容的能力。這種非監督自學習的訓練框架,在顯著提升系統識別性能的同時,大幅降低建模數據標註成本,使得聲紋識別技術在智能語音交互領域得到大規模應用。

下一個十年,語音AI必將無處不在

站在新的一個十年做“預測”,我們還是從過去尋找一些脈絡。

語音技術在研究領域預計將持續取得“量變”的進展。這意味著語音識別的準確率會持續刷新,語音合成的自然度會持續提升,語音交互的智能度會越來越讓人感到驚訝。語音技術在逐步解決感知智能層面的問題後,會越來越將中心放到認知智能層面,並期待有新的具備“質變”性質的研究會推動後者大步向前。

語音技術將再次“解鎖”此前做不好、做不了的場景。在手機、遠場、電話等場景被“解鎖”後,以會議為代表的諸多更困難的場景,預計會在下一個十年被陸續“解鎖”。

語音技術將成為人人可獲得的“水電煤”。語音技術被供給的方式將在下一個十年完全雲化。任何人只要需要,哪怕他沒有太多的語音技術專業知識,都可以從雲上獲得開箱即用並可自主自助優化的語音技術。就像今天任何一個開發者都可以從雲上獲得虛擬主機、雲存儲一樣,語音技術不再掌握在少數人或少數大公司手中,而是成為通用的、標品的、雲上的技術。

人類更多包含語音的活動,將被數字化、結構化並存檔。無論是演講、電話、訪談、會議、研討,越來越多的語音將被記錄下來。因為語音技術的發展,這些數據比以往任何時候都更具價值。基於對這些數據的分析、理解、搜索,有望在效率、決策等多方面為人們帶來新的價值。

語音技術在公民個人隱私方面必將受到挑戰,新的保護隱私技術將成為研究和應用的熱點。端上計算、邊緣計算等其它領域技術,將助力語音技術在隱私保護方面更進一步。隱私保護的數據交換或訓練算法將被提出。我們將努力在隱私保護與數據利用之間尋求平衡。

上一個十年開啟了語音技術大規模應用的時代。下一個十年,無論人們是在家裡、車裡、辦公室裡、公共空間,或是線上虛擬空間,隨時都會有可以與之通過語音進行交互的界面來連接人與人、人與互聯網。語音AI必將在我們身邊變得無處不在。

智能語音產品官網鏈接:https://ai.aliyun.com/nls