來源 阿里語音AI 公眾號

背景

在聲紋識別的應用中,常遇到的一個挑戰是,應用場景需求的多樣性、複雜性、以及明顯的信道差異,使得基礎聲紋模型無法適配多個場景,聲紋識別效果不理想。在跨信道、跨領域時,聲紋識別性能會明顯下降。為確保高準確率,通常需要針對應用場景精確地標註數據,從而優化訓練出特定模型。然而,昂貴的標註成本意味著無法對眾多獨立的應用場景進行數據標註。在產品更新換代速度極快的互聯網時代,人工標註的效率也時常難以跟上產品迭代的速度。因此,工業界急需一套能在無標註數據的情況下,利用海量線上未標註數據,實現非監督自我學習的訓練框架。

算法探討

作為智能家居的重要產品之一,智能音箱的聲紋技術在落地應用中遇到的挑戰是一個典型案例。自首款音箱推出起,短短兩年時間內,市場上已出現上百款不同型號的產品,以滿足不同消費者群體的需求。由於不同產品型號的硬件設備存在差異(6麥克風陣列vs. 2麥克風陣列、帶屏幕vs. 不帶屏幕,等等),信道差異對聲音信號的影響使得無法使用一套普適性的聲紋識別模型去應對不同產品和使用場景的需求。面對這個難題,為智能家居提供聲紋技術能力的算法團隊進行了一系列算法上的探索和嘗試,並取得了效果上的顯著提升。

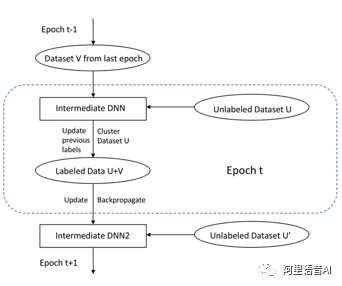

嘗試一:提出了一套基於CurriculumLearning思想的半監督訓練框架。如下圖所示,針對於智能家居場景數據,通過Curriculum Learning的方式,讓模型從簡到難學習到掌握不同數據、不同信道、不同文本內容的能力;在模型的每次迭代過程中,系統通過對未知數據的聚類打標,自我更新,並對先前標籤的糾正,逐漸增加模型魯棒性;同時,針對智能音箱特有的用戶主動註冊數據,引入了Denoising Autoencoder將遠場說話人語音映射到近場向量自空間上,來減少遠場帶來的影響。

嘗試二:上述自我打標迭代的過程中,依然無法避免錯誤labels的產生。因此,更加細化的三種regularization方法被引入到自學習過程,以減少錯誤的labels給訓練帶來的負效應。

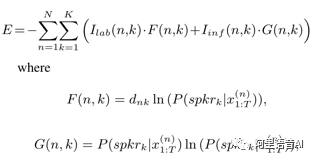

首先,在損失函數上,引入了置信度的概念,計算loss的時候,對每一條語音的後驗概率輸出加上對該label的置信度判斷。

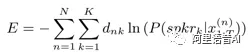

cross entropyloss:

Regularizedentropy loss:

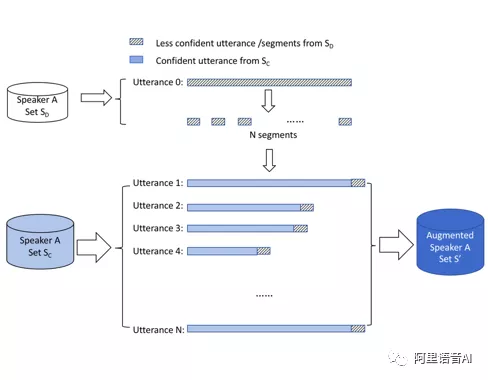

其次,通過對聚類中置信度低的音頻數據進行切片和隨機reshuffle拼接,即避免了有效信息的丟失,又起到了dataaugmentation的作用。對於置信度較低的語音,一些傳統方法會選擇直接丟棄,不進入訓練過程。這種方式損失了許多有效信息,由於這部分信息被當前模型認為置信度較低,無法確認,該信息又恰恰是對模型優化迭代最有幫助的。因此,相比於直接拋棄,採用隨機拼接的方法,保全了有效信息。同時,若是保留了錯誤信息,是否會傷害訓練效果?相關實驗結果顯示是不會的。因為在隨機拼接的片段中,即便是保留了錯誤label的信息,也能起到數據增強的作用。眾多研究已證明,在聲紋訓練數據中引入背景聲、音樂聲等噪聲進行數據增強,可以提升模型性能。使用同源干擾人噪聲作為數據增強,在特定家用智能音箱中,這種干擾人噪聲往往來自於同一家庭下的其他成員,其聲音時常作為背景噪聲出現在實際環境中,因此數據增強效果更為顯著。

最後,利用co-training的思想,通過兩套獨立空間的相互監督,進一步提升了最終系統的魯棒性。

實驗結果

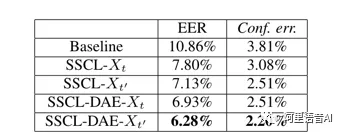

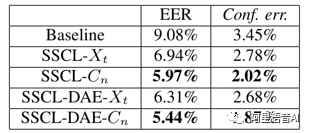

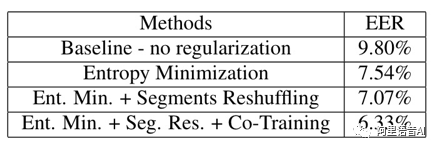

從下表中顯示,以上幾種方法,在不同測試集上,相比於傳統方法,取得了相對30%-50%的性能提升。

(1)設備型號A,使用嘗試一中提到的無監督訓練框架和算法,快速大幅度增加訓練數據,使得EER從10.86%下降到6.28%。

(2)設備型號B, 使用嘗試一中提到的無監督訓練框架和算法,快速大幅度增加訓練數據,使得EER從9.08%下降到5.44%。

(3)設備型號A+B,對比使用三種regularization方法的實驗結果。

技術應用

上述技術的落地,使得聲紋識別技術可以在原本的許多“無數據,不可用”的場景中落地應用。在無人工標註數據的情況下,通過模型的自動標籤與迭代,快速支持多款不同需求的智能音箱產品上線;基於遠場交互的聲紋識別技術,也在其它智能家居場景上成功落地應用。

參考文獻

[1] S. Zheng, G. Liu, H. Suo, and Y. Lei,“Autoencoder-based semi-supervised curriculum learning for out-of-domainspeaker verification,” in INTERSPEECH2019 – 20th Annual Conference of the International SpeechCommunication Association, September 15-19, Graz, Austria, Proceedings, 2019.

[2] S. Zheng, G. Liu, H. Suo, and Y. Lei, “TowardsA Fault-tolerant Speaker Verification System,” in INTERSPEECH 2019 – 20th Annual Conference of theInternational Speech Communication Association, September 15-19, Graz, Austria,Proceedings, 2019.