1.1. 產品亮點

1) 阿里雲支持:使得用戶在阿里雲上使用CDP,獲取CDP的功能和性能,同時實現最大的選擇和靈活性。

2) 多功能分析:解決最苛刻的業務用例 –跨數據分析生命週期集成大數據管理和分析,為大規模地應用實時流處理、數據倉庫、數據科學和迭代機器學習提供跨數據共享,可以隨時隨地的訪問數據。

3) 安全性和治理:通過通用的安全模型來控制任何雲(公有云、私有云和混合雲)上的數據,簡化了各種企業數據的數據隱私和合規性,在所有環境中提供安全性、合規性、數據遷移和元數據管理。

4) 開放:促進開源社區的創新、提供開放存儲和計算架構的選擇性以及促進廣泛的生態系統的信心和靈活性,提供開放集成,可擴展架構以及對多個數據存儲和計算架構開放。

1.2. 產品說明

CDP平臺不但提供企業級的安全性和治理能力,還同時提供多種分析功能用於數據分析,具備在內部和外部部署相同功能的能力,支持主要的公有云和私有云環境、使得用戶獲得彈性的雲體驗,並不再存在數據孤島和單一供應商鎖定的威脅。

CDP不但可以靈活地運行各種企業工作負載(例如:實時攝取和分析、數據工程、交互式SQL、企業搜索、高級分析和機器學習),還滿足企業的要求:與企業現有的系統進行集成,同時提供強大的安全性、數據治理、數據保護和管理能力。CDP是企業數據管理的新興中心。

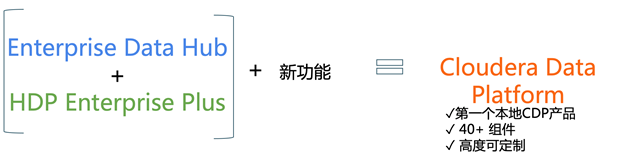

CDP是Cloudera公司的最新產品,該新產品結合了Cloudera Enterprise Data Hub和Hortonworks Data Platform Enterprise的優點,並在技術堆棧中增加了新功能和對已有技術提供了增強功能。這種統一的發行是一個可擴展且可自定義的平臺,您可以在其中安全地運行多種類型的工作負載。

除了需要企業數據雲外,企業還希望將這種強大的數據管理基礎架構遷移或添加到雲中,以提高運營效率、降低成本、提供計算和容量靈活性以及速度和敏捷性。

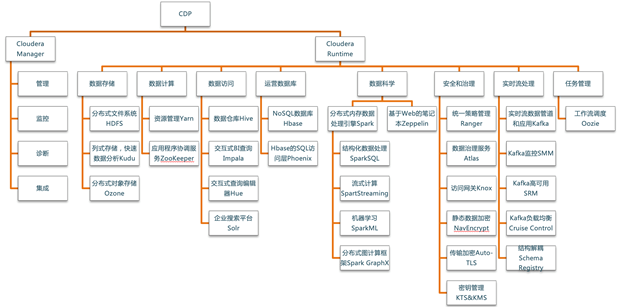

隨著組織在雲環境中採用基於Hadoop的大數據部署,他們還需要企業級的安全性和治理、多種分析功能、管理工具和技術支持-所有這些需求都是CDP平臺的一部分,下圖展示了CDP平臺的功能地圖。

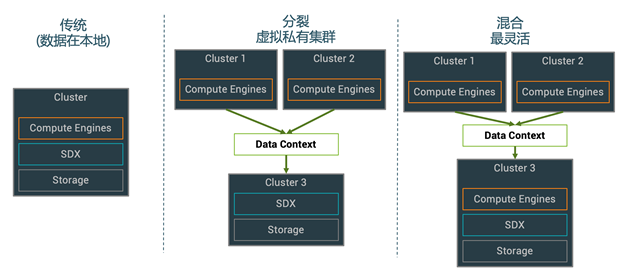

CDP支持各種混合解決方案,其中計算任務與數據存儲分離,並且可以從遠程集群訪問數據。這種混合方法通過管理存儲、表Schema、身份驗證、授權和治理,併為容器化應用程序提供了基礎。

CDP包括各種組件,例如Apache HDFS、Apache Hive 3、Apache HBase和Apache Impala,以及許多其他用於特殊工作負載的組件。您可以選擇這些服務的任意組合來創建滿足您的業務需求和工作負載的集群。幾個預配置的服務包也可用於常見的工作負載。

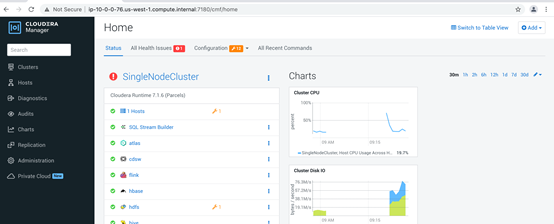

Cloudera Manager是用於管理、配置和監控CDP集群和Cloudera Runtime服務的應用程序。

Cloudera Manager服務器在CDP部署中的主機上運行,並使用在集群中每個主機上運行的Cloudera Manager代理來管理一個或多個集群。

Cloudera Manager是用於管理集群的端到端應用程序。藉助Cloudera Manager,您可以輕鬆地部署和集中操作完整的Cloudera Runtime堆棧和其他託管服務。該應用程序可自動執行安裝和升級過程,併為您提供主機和正在運行的服務的整個群集的實時視圖。Cloudera Manager管理控制檯提供了一箇中央控制檯,您可以在其中對整個集群進行配置更改,並結合了各種報告和診斷工具來幫助您優化性能和利用率。Cloudera Manager還管理安全性和加密功能。使用Cloudera Manager管理控制檯,您可以啟動和停止集群以及單個服務、配置和添加新服務、管理安全性以及升級集群。您還可以使用Cloudera Manager API以編程方式執行管理任務。

Cloudera Manager的單個實例可以管理多個集群,包括較舊版本的Cloudera Runtime和CDH。

CDP還包括以下工具來管理和保護您的部署:

· Cloudera Manager允許您使用Cloudera Manager管理控制檯的Web應用程序或Cloudera Manager API管理、監控和配置集群和服務。

· Apache Atlas提供了一組元數據管理和治理服務,使您能夠管理CDP集群資產。

· Apache Ranger通過用戶界面管理訪問控制,以確保CDP集群中一致的策略管理。

Cloudera Runtime是CDP Private Cloud Base中的核心開源軟件發行版。Cloudera Runtime包括大約50個開源項目,這些項目構成CDP中數據管理工具的核心分發。

1.2.1. CDH用戶獲得的新功能

1.2.2. HDP用戶獲得的新功能

1.2.3. CDP節點類型

Cloudera建議在生產環境中部署CDP多達四種機器類型:

·主節點-主要運行Hadoop主守護程序,例如NameNode, Standby NameNode, YARN Resource Manager and History Server, the HBase Master daemon, Ranger server, Atlas Server, and the Impala StateStore Server and Catalog Server。主節點也是Zookeeper和JournalNodes的安裝位置。守護程序可以共享一個服務器池。根據集群大小、角色可以在專用服務器上運行。Kudu Master Servers也應該部署在主節點上。生產集群建議打開高可用HA,生產集群建議在創建集群的硬件配置步驟開啟高可用。如果購買時未開啟高可用,在後續使用過程中開啟高可用功能。Master節點主要用來存儲HDFS元數據和組件Log文件,屬於計算密集型,對磁盤IO要求不高。HDFS元數據存儲在內存中,建議根據文件數量選擇32 GB以上內存空間。

·工作節點-主要用來存儲數據和執行計算,運行HDFS DataNode,、YARN NodeManager、HBase RegionServer、Impala impalad、Search worker daemons 和Kudu Tablet Servers。推薦使用SSD雲盤存儲數據。

·工具節點-運行Cloudera Manager和Cloudera Management Services。它還可以運行託管的MariaDB(或其他受支持的)數據庫實例,Cloudera Manager、Hive、Ranger和其他與Hadoop相關的項目將使用該數據庫實例。

·邊緣節點-包含所有面向客戶端的配置和服務,包括HDFS、YARN、Impala、Hive和HBase的網關配置。Hue、 Oozie、 HiveServer2和Impala HAProxy、 HiveServer2 和Impala HAProxy server充當通往外部應用程序(如商務智能(BI)工具)的網關也部署在邊緣節點上。邊緣節點也稱為網關節點。

注意:在較小的集群中邊緣和工具節點可以合併在一起。

阿里雲上的CDP存儲目前支持ESSD雲盤。底層存儲目前支持HDFS和Kudu。HDFS的數據可用性由雲盤或本地盤存儲的可靠性來保證。

1.2.4. CDP集群角色分佈

沒有啟用HA的3-10個工作節點角色分配

|

主節點 |

工具節點 |

網關節點 |

工作節點 |

|

主節點1: NameNode YARN ResourceManager JobHistory Server ZooKeeper Kudu master Spark History Server |

單一主機用於所有的工具和網關角色: Secondary NameNode Cloudera Manager Cloudera Manager Management Service Hive Metastore HiveServer2 Impala Catalog Server Impala StateStore Hue Oozie Flume Gateway configuration HBase backup master Ranger Admin, Tagsync, Usersync servers Atlas server Solr server Streams Messaging Manager Streams Replication Manager Service ZooKeeper |

3 - 10 工作節點: DataNode NodeManager Impalad Kudu tablet server |

|

啟用HA的3-20個工作節點角色分配

|

主節點 |

工具節點 |

網關節點 |

工作節點 |

|

主節點1: NameNode JournalNode FailoverController YARN ResourceManager ZooKeeper JobHistory Server Kudu master HBase master Schema Registry 主節點2: NameNode JournalNode FailoverController YARN ResourceManager ZooKeeper Kudu master HBase master Schema Registry 主節點3: Kudu master (Kudu 需要奇數節點來做HA.) Spark History Server JournalNode (需要專用磁盤) ZooKeeper |

工具節點1: Cloudera Manager Cloudera Manager Management Service Cruise Control Hive Metastore Impala Catalog Server Impala StateStore Oozie Ranger Admin, Tagsync, Usersync servers Atlas server Solr server Streams Messaging Manager Streams Replication Manager Service 工具節點2: Ranger Admin server Atlas server Solr server |

一個或者多個網關節點: Hue HiveServer2 Gateway configuration |

3 - 20 工作節點: DataNode NodeManager Impalad Kudu tablet server Kafka Broker (推薦最少3個brokers) Kafka Connect HBase RegionServer Solr server (對於Cloudera Search, 推薦至少3 臺服務器) Streams Replication Manager Driver |

1.3. 設置對基於阿里雲部署的CDP的訪問權限

在阿里雲或者內外網環境中,Cloudera的平臺產品CDP需要訪問很多Web UI,但系統網絡可能僅支持SSH訪問(22端口)。要訪問Cloudera Manager(7180端口)或者其他服務,可以通過下列兩種方式:

· 在客戶端計算機上設置SOCKS(套接字安全協議)代理。Cloudera建議您使用此選項。

· 將CDP/CDP部署到阿里雲之後,將入站規則添加到阿里雲實例中的網絡安全組。

1.3.1. 配置SOCKS代理

SOCKS5協議是作為客戶端和服務器進程實現的,它可以遍歷IP網絡防火牆。配置SOCKS代理後,瀏覽器使用公有云網絡(通過代理服務器)解析DNS查找,並允許您使用內部FQDN或專用IP地址連接到服務。

使用這種方法,您可以完成以下任務:

- 設置到網絡上主機之一的單個SSH隧道,並在主機上創建SOCKS代理。

- 更改瀏覽器配置,以通過SOCKS代理主機執行所有查找。

1.3.1.1. 網絡先決條件

在使用SOCKS代理連接到集群之前,請驗證以下先決條件:

- 您必須能夠從公共Internet或您要從其連接的網絡中訪問要代理的主機。

- 您要代理的主機必須與您要連接的Cloudera服務位於同一網絡上。例如,如果您使用的是Cloudera CDP產品,請通過SSH隧道連接到Cloudera Manager主機。

1.3.2. 啟動SOCKS代理

1.3.2.1. Linux

要通過SSH啟動SOCKS代理,請運行以下命令:

ssh -i your-key-file.pem -CND 1080

the_username_you_specified@publicIP_of_VM

該命令使用以下參數:

- -i your-key-file.pem指定SSH到Cloudera CDP/EDH服務器所需的私鑰的路徑。如果使用SSH密碼,則省略。

- C 設置壓縮。

- N 建立後禁止執行任何命令。

- D 在端口上設置SOCKS代理。

- 1080 用於在本地設置SOCKS代理的端口。

1.3.2.2. Windows

1.3.3. 配置Google Chrome瀏覽器以使用代理

默認情況下,Chrome瀏覽器會按配置文件使用系統範圍的代理設置。要在沒有這些設置的情況下啟動Chrome,請通過命令行打開Chrome並指定以下內容:

- SOCKS代理端口。該端口必須與啟動代理時使用的端口相同。

- 配置文件。下面的示例創建了一個新的配置文件。

使用以下命令之一創建配置文件並啟動與當前任何正在運行的Chrome實例不衝突的Chrome的新實例。

1.3.3.1. Linux

/usr/bin/google-chrome \

--user-data-dir="$HOME/chrome-with-proxy" \

--proxy-server="socks5://localhost:1080"

1.3.3.2. Mac OS X

"/Applications/Google Chrome.app/Contents/MacOS/Google Chrome" \

--user-data-dir="$HOME/chrome-with-proxy" \

--proxy-server="socks5://localhost:1080"

1.3.3.3. 微軟Windows

"C:\Program Files (x86)\Google\Chrome\Application\chrome.exe" ^

--user-data-dir="%USERPROFILE%\chrome-with-proxy" ^

--proxy-server="socks5://localhost:1080"

在此Chrome會話中,您可以使用私有IP地址或內部FQDN連接到Cloudera CDP可訪問的任何主機。

這樣就可以通過內網訪問Cloudera Manager和其他Web UI了

也可以通過CM中的web UI跳轉直接跳轉過去。

1.3.4. 網絡安全組

警告:除概念驗證以外,不建議將此方法用於任何其他目的。如果沒有仔細鎖定數據,那麼黑客和惡意實體將可以訪問這些數據。

1.4. 用例場景

CDP提供全球首個企業數據雲的願景和戰略,使我們的客戶能夠管理從Edge到AI的整個數據生命週期。

通過對用戶的數據分析使用場景進行分析,發現所有的數據分析都可以歸納為這樣六個步驟,六個步驟為:

1) 數據收集–邊緣端的數據攝取和監控(邊緣端可能是工業傳感器,也可能是實體零售店中的人員或者終端服務器等)

2) 數據豐富–能實現處理、聚合和管理的數據管道,準備數據以進行進一步完善

3) 報告–提供企業的業務見解(例如:銷售分析和預測、市場研究、預算編制)

4) 服務–控制和運行基本的業務操作 (例如:ATM交易、零售結帳或生產監控)

5) 預測分析–基於AI和機器學習的預測分析(例如:欺詐檢測、預測性維護、基於需求的庫存優化為例)

6) 安全與治理–在整個數據生命週期中的一組集成的安全、管理和治理技術

通過這六個步驟,能夠管理從Edge到AI的整個數據生命週期,使得企業能夠在同一個平臺上進行整個數據生命週期的分析,避免產生各種數據孤島,減少了數據在不同平臺之間的移動時間,從而加速用戶的業務實現。

企業裡面有各種各樣的數據,包括實時數據和非實時交易數據,包括結構化數據、半結構化數據和非結構化數據、以及外部數據等等;這些數據通過企業數據雲提供的完整的數據分析生命週期能力進行數據收集、數據加工、然後提供各種各樣數據的使用,包括分析報表、數據服務和機器學習;通過企業數據雲的支持,企業就可以在上面去構建各種各樣的用例,在製造業中例如預測性維護、供應鏈優化、全面優化等,在金融業有客戶畫像、風控等,在零售業有交叉營銷、客戶推薦等用例。

1.4.1. 現代數據倉庫

構建現代化數據倉庫來替代傳統數據倉庫以解決企業對數據來源、數據量及數據服務時效的需求,使得現代化數據倉庫可以使用強大的自助服務工具來為數千名BI分析用戶提供支持,同時系統提供快速和大規模的嚮導和自動化管理工具,並且存儲所有的數據(包括各種類型和數據量的數據)。

1.4.2. 流式消息處理

Apache Kafka是一個高性能、高可用性的冗餘流消息平臺,可以替代更傳統的消息代理。消息代理的使用有多種原因(將數據生成和處理分離,緩衝未處理的消息等)。與大多數消息傳遞系統相比,Kafka具有更好的吞吐量、內置分區、複製和容錯功能,這使其成為大規模消息處理應用程序的理想解決方案。

在CDP中提供了Kafka及其周邊的小夥伴,來使得Kafka更易用,更好用。

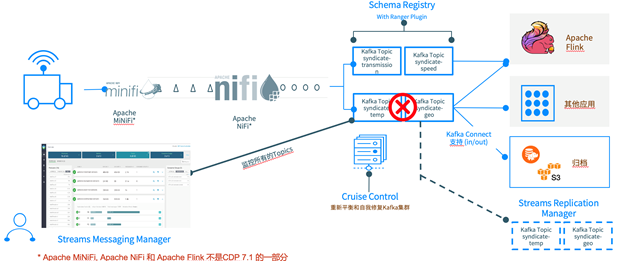

該圖是一種簡化的動態數據參考架構,在邊緣端顯示為Apache MiNiFi,它從移動資產中提取了機器生成的數據。Apache NiFi收集數據並轉換、解析和過濾到Kafka的主題,以便Apache Flink/Spark Streaming等流處理引擎和其他應用程序可以快速構建和運行分析。

1) 使用CDP7.1,您將獲得最新的Kafka服務。

2) Kafka Connect支持可用於增強與HDFS、S3和Kafka Streams的連接。可以直接將Kafka的數據寫入到對應的存儲中。

3) Schema Registry將在整個Kafka集群中存儲和訪問您的Schema。它與Apache Ranger集成,來支持對Schema Registry的訪問控制。

4) Stream Replication Manager可實現業務連續性,該業務連續性支持您的Kafka群集的複製,以實現災難恢復和高可用性需求。

5) Cruise Control支持提供基於API的工具,以監視和協助Kafka集群和主題的重新平衡和擴展。

6) Streams Messaging Manager用於監控和管理髮布者、代理、使用者和主題。

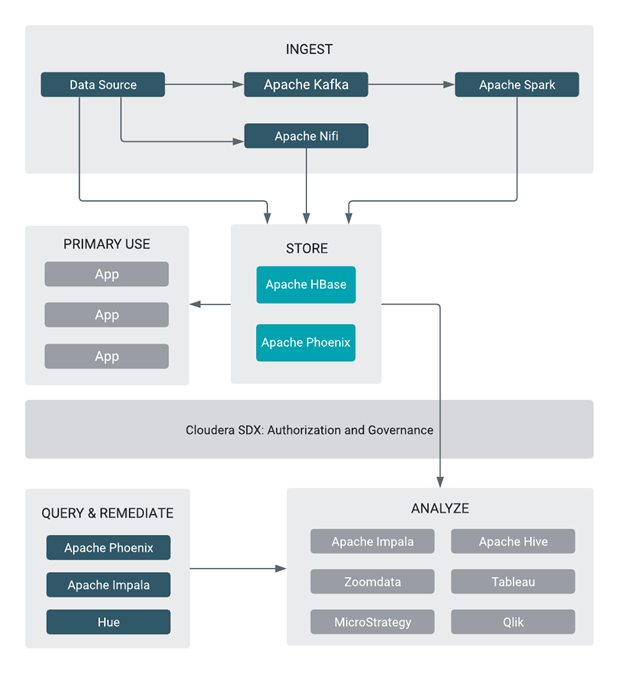

1.4.3. 運營數據庫

Cloudera運營數據庫提供了實時的、始終可用的、可擴展的運營數據庫,該數據庫在統一的運營和倉儲平臺中為傳統結構化數據和非結構化數據提供服務。運營數據庫由Apache HBase和Apache Phoenix提供支持。

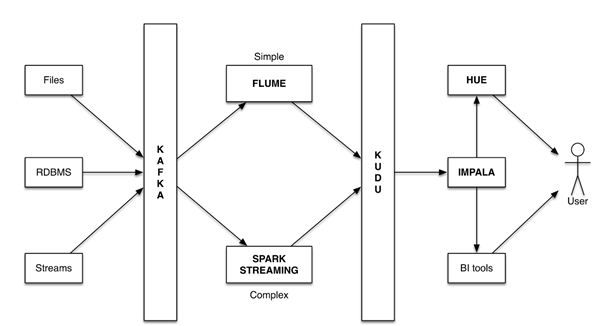

1.4.4. 準實時分析

準實時分析需要對變化中的數據提供快速分析能力,包括結合歷史數據和實時流數據進行彙總分析、預測和明細查詢。

準實時分析的典型場景需要同時支持順序和隨機讀/寫的應用場景,包括:

· 在線交互式BI分析/決策輔助

o 場景舉例: 貸後風險實時監測,實時資產偏好視圖,歷史風險偏好趨勢,市場監測

o 應用類型: 需要準實時的同步插入/修改,同時彙總分析和單條查詢

· 時間序列數據

o 場景舉例: 股市行情數據; 欺詐檢測和預防; 風險監控;線上實時反欺詐

o 應用類型:需要實時捕獲流數據,同時結合已有的T+1數據進行彙總、分析和計算

· 機器日誌數據分析

o 場景舉例: 臺機監控、故障預警

o 應用類型:需要過濾大量流數據,同時結合已有的T+1數據進行彙總、分析和計算

在CDP平臺上通過使用Kudu+Impala的架構來提供準實時數據分析,這裡只使用一套系統,不再需要後臺定時的批處理任務來同步數據,可以輕鬆應對數據延遲和數據修復工作,新數據可以立即用於分析和業務運營。

1.4.5. 多租戶和虛擬專用集群

虛擬專用集群使用Cloudera共享數據體驗(SDX)來簡化內部部署和基於雲的應用程序的部署,並使在不同集群中運行的工作負載能夠安全靈活地共享數據。

藉助虛擬專用集群和SDX框架,Cloudera Manager中提供了一種稱為計算集群的新型集群。 Compute集群運行諸如Hive Execution Service、Spark或YARN之類的計算服務,但是您可以配置這些服務以訪問託管在另一個稱為Base集群的常規群集中的數據。使用此體系結構,您可以通過多種方式分離計算和存儲資源,以靈活地最大化資源。