--------點擊屏幕右側或者屏幕底部“+訂閱”,關注我,隨時分享機器智能最新行業動態及技術乾貨----------

不久前,人力資源社會保障部發布了一種炙手可熱的新職業:AI 訓練師。沒想到,浙江大學與阿里安全的人工智能訓練師馬上創造出一個 “AI 訓練師助手”,高效打造 AI 深度模型,應對海量應用場景的增加,讓 AI 訓練模型面對新場景時不用從頭學習,直接從已經存在的模型上遷移,迅速獲得別人的知識、能力,成為全新的AI模型,而且能將模型週期從一個月縮短為一天。隨後,闡述這種讓 AI 訓練 AI,提升模型生產效率的論文被計算機視覺頂會 CVPR 2020 接收 (Oral)。

現在,視頻、直播成為互聯網內容消費的重要載體,內容創作爆發,創作形式自由度高帶來了許多潛在安全威脅。好消息是,AI 深度模型被大規模用於多媒體內容的識別、檢測、理解上,用以狙擊含有不良內容的傳播。為了提升檢測的準確性,面向不同場景必須使用不同的 AI 模型。但是,由於媒體場景、細分領域多,如何才能高效生產不同 AI 深度模型?

目前實現這一目標最流行的方法是遷移學習。浙江大學和阿里安全發現,兩個預訓練深度模型所提取的特徵之間的遷移能力可由它們對應的深度歸因圖譜之間的相似性來衡量。相似程度越高,從不同的預訓練深度模型中獲得的特徵相關性就越大,特徵的相互遷移能力也就越強。而且,“AI 訓練師助手”還知道從什麼模型遷移知識,用模型的哪個部分遷移能最好地完成任務。也就是說,他們發現了讓小白模型向 AI 深度模型學習的高效學習方法。

問題:如何才能取得最優遷移效果

得益於大量高質量標註數據、高容量的模型架構、高效率的優化算法以及高性能計算硬件的發展,過去十年裡深度學習在計算機視覺、自然語言處理以及生物信息學等領域取得了舉世矚目的進步。隨著深度學習取得了前所未有的成功,越來越多的科研人員和工業工作者願意開源他們訓練好的模型來鼓勵業界進一步的研究。目前,預訓練好的深度學習模型可以說是無處不在。

阿里安全圖靈實驗室高級算法專家析策認為,我們不僅處在一個大數據時代,同時也正在步入一個“大模型”時代。

與大數據相似,海量模型形成的模型倉庫也蘊含了巨大的潛在價值。這些預訓練的深度模型已經消耗了大量的訓練時間以及大規模高質量的標註數據等昂貴的計算資源。如果這些預訓練的模型能夠被合理地重新使用,那麼在解決新任務時的對訓練時間以及訓練數據的依賴就會顯著降低。目前實現這一目標最流行的方法就是遷移學習。在基於深度模型的跨任務的遷移學習中,模型微調是一種使用最廣泛並且有效的方法。

該方法以一個預先訓練的模型作為起點,固定模型的一部分參數以降低模型優化空間,利用新任務有限的數據訓練剩餘的參數,使得模型能夠在新任務上獲得成功。

雖然這種方法在一些具體問題中取得了一定的成效,但是當前這些遷移學習方法忽略了兩個重要的問題:面對海量的預訓練好的深度模型,選擇哪個模型解決當前任務能夠取得最好的效果;給定一個預訓練好的模型,應該固定哪些層的參數以及優化哪些層才能夠取得最優的遷移效果。

目前的模型選擇通常是盲目地採用 ImageNet 的預訓練模型。然而,ImageNet 預訓練的模型並不總是對所有任務產生令人滿意的性能,特別是當任務與 ImageNet 數據上定義的任務有顯著差異時。而模型微調時參數優化臨界點的選擇往往依賴於經驗。但是,由於最優的優化臨界點取決於各種因素,如任務相關性和目標數據量等,依賴經驗做出的選擇往往很難保證最優。

不同任務下深度神經網絡提取特徵的可遷移性

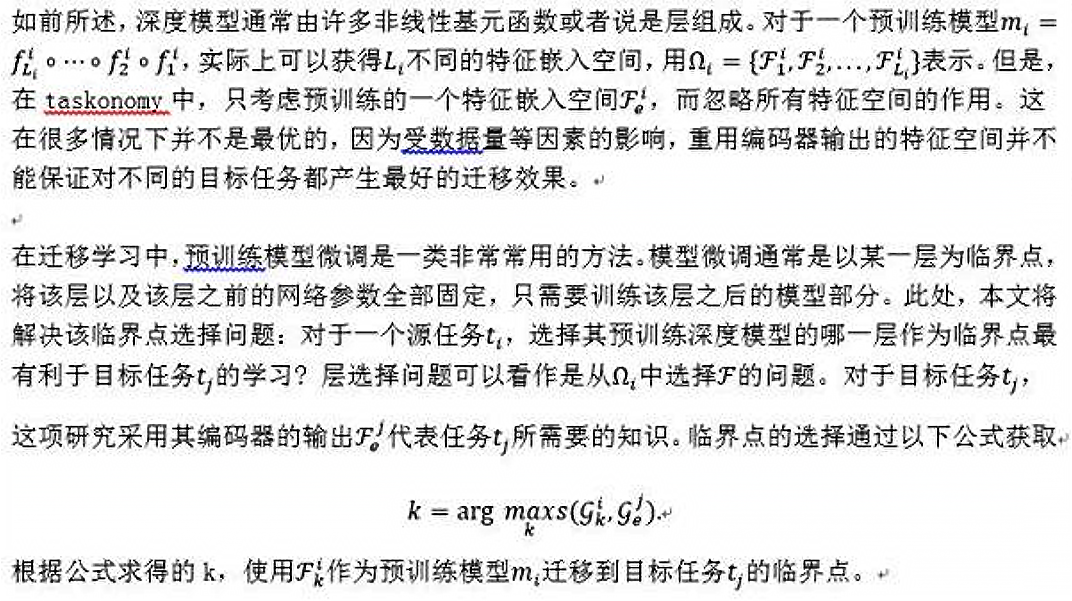

為了解決上述問題,浙江大學和阿里安全發起了這項研究:在不同任務下訓練的深度神經網絡提取的特徵之間的可遷移性。Zamir 等人[1]對不同任務間的遷移關係作了初步的研究。他們提出了一種全計算的方法,稱為 taskonomy,來測量任務的可遷移性。然而, taskonomy 中有三個不可忽視的侷限性,極大地阻礙了它在現實問題中的應用。

首先,它的計算成本高得令人望而卻步。在計算給定任務集合中兩兩任務之間的遷移關係時,計算成本會隨集合中任務數量的增加而呈平方性地增長,當任務數量很大時,計算成本會變得非常昂貴。

第二個限制是,它採用遷移學習來建立任務之間的遷移關係,這仍然需要大量的標記數據來訓練轉移模型。然而,在許多情況下,我們只能獲取訓練好的模型,並不能夠獲取到相應的訓練數據。最後,taskonomy 只考慮不同模型或任務之間的可遷移性,而忽略了不同層之間的可遷移性,不能夠用來解決微調模型時臨界點的選擇問題。

衡量從不同預訓練深度模型中提取到特徵間的可遷移性,主要障礙是深度模型自身的黑箱性質。由於從不同的預訓練深度模型中學習到的特徵是不可解釋的,而且處在不同的嵌入空間中,直接計算特徵間的可遷移性非常困難。

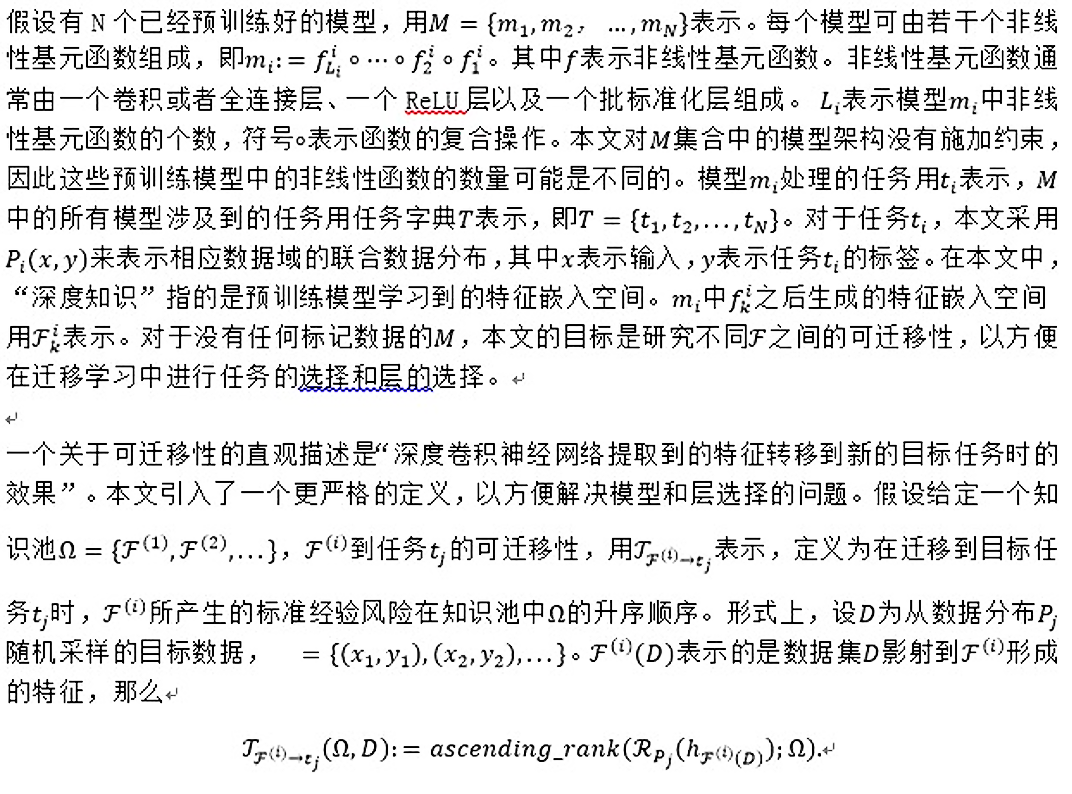

為了推導預訓練深度模型中提取到特徵間的可遷移性,研究者們首先給出了可遷移性的嚴格定義。

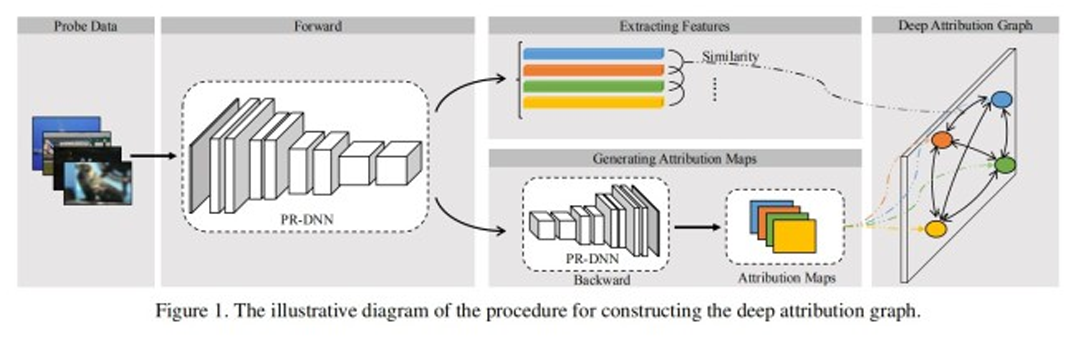

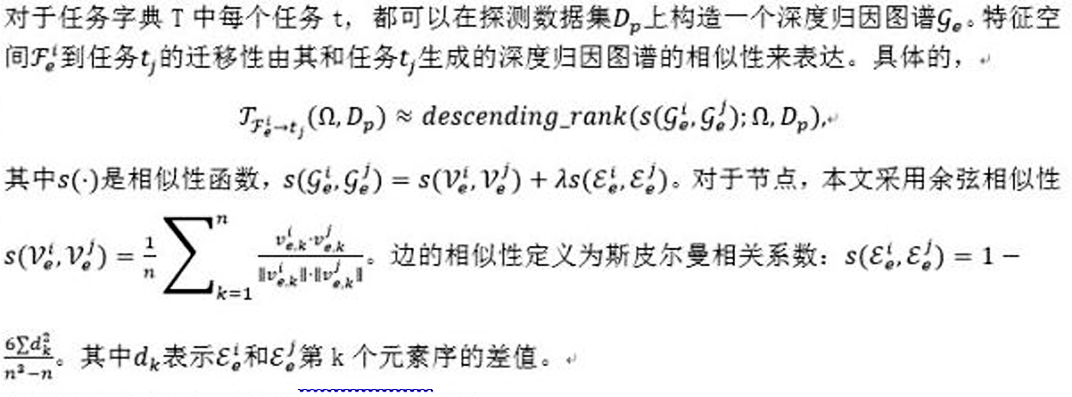

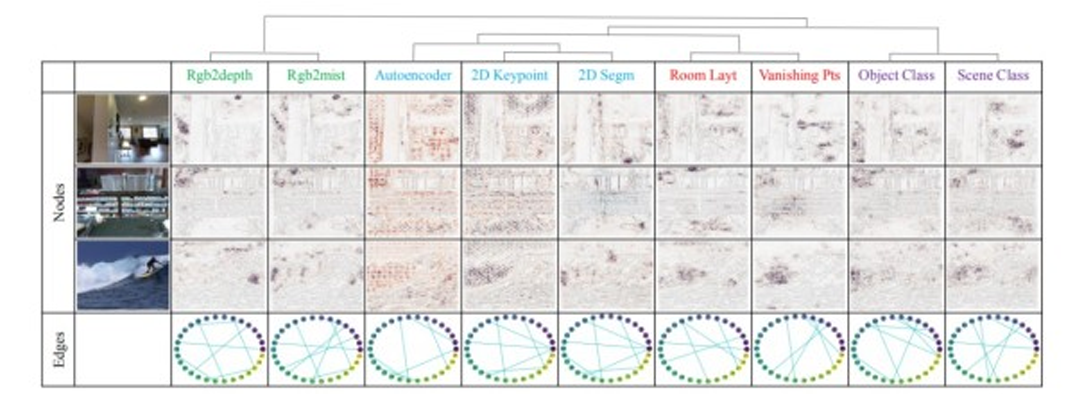

在該定義下,預訓練模型的選擇和模型微調時臨界點的選擇實際上是該遷移性定義下的兩個特例。然後,這篇論文提出了深度歸因圖譜( DEeP Attribution gRAph, DEPARA )來表示在預訓練深度模型中學習到的知識。在深度歸因圖譜中,節點對應於輸入,並由模型在輸入數據上歸因形成的歸因圖[2]來表達。邊表示輸入數據之間的關聯,通過它們在預訓練深度模型特徵空間中的相似度來度量,如圖1所示。由於不同預訓練深度模型中的深度歸因圖譜是在相同的輸入集上定義的,它們實際上處於相同的空間內,因此兩個預訓練深度模型所提取的特徵之間的遷移能力可直接由它們對應的深度歸因圖譜之間的相似性來衡量。相似程度越高,從不同的預訓練深度模型中獲得的特徵相關性就越大,特徵的相互遷移能力也就越強。這項研究通過大量實驗證明了該方法應用於任務間遷移關係度量以及模型微調時臨界點選擇的有效性。

問題描述

直接計算上述公式定義的遷移性需要大量標註數據且非常耗時。本文提出通過計算影響遷移性的兩個重要因素,來做近似估計。

- 包含性:要使得特徵遷移在目標任務上取得較為理想的效果,源任務的訓練的模型生成的特徵空間應該包含解決目標任務所需的足夠信息。包容性是遷移學習取得成功的一個比較基本的條件。

- 易用性:特徵空間應該已經經過充分的學習並抽象到比較高的層次,這樣才能夠在有限的標註數據下很好地解決目標任務。如果不要求特徵的易用性,那麼原始的輸入總是比經過深度網路處理的特徵包含更多的信息。然而由於原始的數據沒有經過任何知識提取與抽象,並不能夠很好的遷移到新任務中。

深度歸因圖譜

如何利用深度歸因圖來解決兩個遷移性問題

1、任務之間的遷移性

2、層的遷移性

實驗

DEPARA的可視化

上圖是對於不同視覺任務所生成的深度歸因圖的可視化結果。從圖中可以看出有一些任務生成非常相似的歸因圖以及樣本之間的關係,然而有些生成的結果則非常不同。例如,Rgb2depth 和 Rgb2mist 生成了非常相似的歸因圖和關係圖,然而它們的結果和自編碼器的結果非常不同。事實上,在任務分類法中,Rgb2depth 和 Rgb2mist 彼此間具有很高的遷移性,但它們到自編碼器的遷移性相對較低。此外,任務分類法採用層次聚類的方式把任務劃分為四組:2D 任務(藍色),3D 任務(綠色),幾何任務(紅色)以及語義任務(品紅色)。圖中選取了 2 個 3D 任務,3 個 2D 任務,2 個幾何任務以及 2 個語義任務作可視化。任務分類法在這些任務上生成的任務相似樹繪製在任務名稱的上方。從圖可以看出,在每個任務組內部,深度歸因圖譜生成較為相似的節點以及邊。

模型遷移度量

論文中採用 PR 曲線來評估方法效果,實驗結果如上圖,可以看到論文中提出的深度歸因圖方法 (DEPARA) 與 taskonomy(Oracle) 實驗的結果具有很高的相似性,且通過消融實驗可知,只採用圖中節點相似性 (DEPARA-V) 和只採用圖中邊相似性 (DEPARA-E) 計算得到的遷移性準確度都遠遠不如圖相似性 (DEPARA),這意味著節點和邊都對結果起著重要作用,是不可分割的。另外,論文中的方法 (DEPARA) 好於 SOTA(RSA),證明了這是一種更加有效的計算遷移性的方案。

層遷移度量

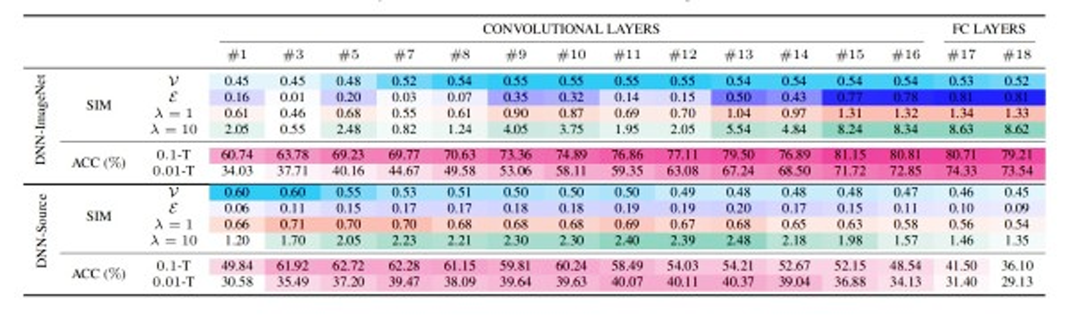

在 Syn2Real-C 數據集(包含有合成圖像的數據域以及真實圖像的數據域)上進行層遷移的實驗,分別考慮了兩種源模型(在合成數據域上訓練的模型和在 ImageNet[6] 上預訓練的模型)來進行遷移至真實數據域。在遷移時,只利用了 1%(0.01-T) 和 10%(0.1-T) 的標註數據來進行訓練,觀察遷移效果和深度歸因圖相似性之間的關係。根據上圖中顏色的深淺可知,對於兩種不同的源模型,遷移效果越好的層,計算得到的深度歸因圖相似性越高,遷移效果越差的層,計算得到的深度歸因圖相似性也越低,驗證了論文中方法的準確性。有趣的是,對於在 ImageNet 上預訓練和合成數據域上預訓練的源模型來說,儘管具有最好的遷移效果的層並不相同,但是論文中的方法都能很好地進行指示。而且,對於 1% 和 10% 兩種不同的模式,這種方法通過設定不同的λ超參數,也依舊能挑選出遷移效果最好的那些層。

從效果上來看,無論是從節點V還是邊E的相似性比較來看,DNN-ImageNet 都比 DNN-Source 具有更好的遷移性,這是因為儘管 DNN-Source 和目標任務學習的是同一物體的圖像,但是他們的數據域相差太大,導致需要花費更多的成本去重建目標任務的特徵空間。值得注意的是,有些層用於遷移甚至出現了負遷移的現象,負遷移經常出現在當用於遷移的源數據域和目標數據域相差很大的情況下,這說明在實驗中,挑選一個合適的層用於遷移是十分重要的。

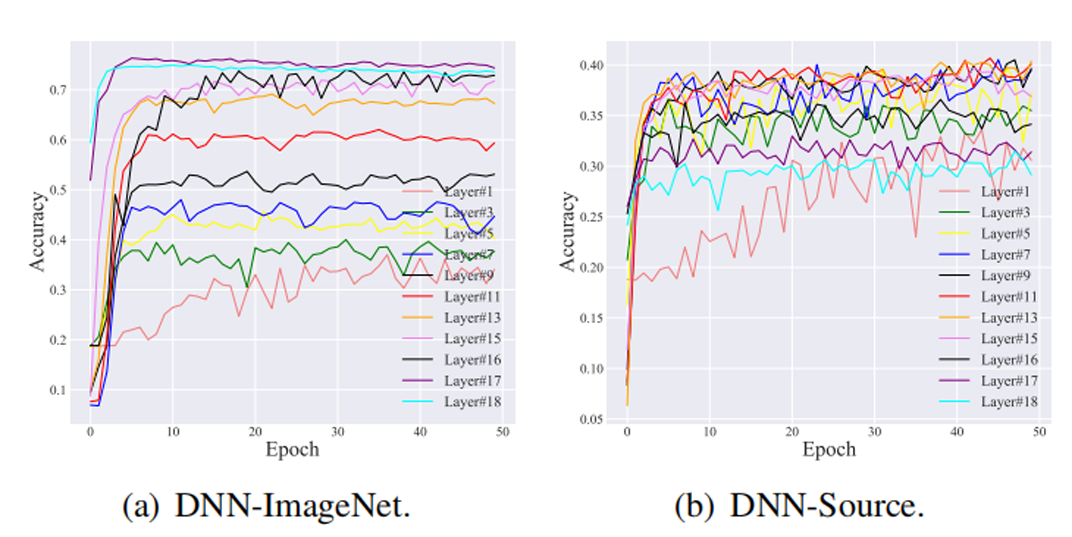

上圖是層遷移實驗中的訓練曲線,可以看到,由 DEPARA 挑選出來的層,遷移效果要好於其他層。而且,相比於 DNN-Source、DNN-ImageNet 中的訓練曲線明顯更加地平滑,這也恰恰證明了遷移性越好的模型,在遷移時所花費的重訓練的成本就越低,也越容易地遷移至目標任務。

“在‘AI 訓練師助手’的指導下,單個 AI 模型的生產週期從 1 個月降到 1 天,我們就能更快地發現不同的內容風險。”析策希望,欺凌、色情、暴力、誤導等不良內容不會成為人們消費大量圖像視頻內容付出的代價,AI 技術可以更快地把不良內容擋在第一線。

關於更多方法上以及實驗上的細節和結果,請閱讀論文原文。

論文地址:https://arxiv.org/abs/2003.07496

代碼地址:https://github.com/zju-vipa/DEPARA

業務應用

阿里安全圖靈實驗室,通過多年的在阿里經濟體內和雲上客戶的多領域、多場景的廣泛應用和不斷優化,提供風險和治理領域的圖像視頻識別、定位、檢索等全面服務能力,與此同時形成了一整套深度模型生產體系,以應對複雜業務需求。本文的研究為模型遷移性提供了理論和實驗支撐,從而挖掘和建立海量模型間的關係圖譜,極大提升模型生產的效率。

原文連接:https://yqh.aliyun.com/detail/8066

Reference:

[1] Amir R. Zamir, Alexander Sax, William Shen, Leonidas J.Guibas, Jitendra Malik, and Silvio Savarese. Taskonomy: Disentangling task transfer learning. In CVPR 2018, June 2018.

[2] Avanti Shrikumar, Peyton Greenside, Anna Shcherbina, and Anshul Kundaje. Not just a black box: Learning important features through propagating activation differences. CoRR, abs/1605.01713, 2016.