新零售智能引擎事業群出品

電子商務領域的視頻推薦對於獲取新客戶有著重要作用。例如,許多消費者會在商品評論區上傳視頻已分享他們獨特的購物體驗,這些獨特的商品呈現方式或獨特的商品使用方法可能會吸引潛在買家購買相同或類似的產品。相比於賣家秀視頻(如廣告),買家秀視頻具有數量大和個性化強的優勢,因此,將買家秀視頻推薦給潛在感興趣的消費者可以增強電子商務場景下視頻推薦的有效性。

在這種應用需求下,我們設計了買家秀視頻標題自動生成模型,並從以下數據中抽取、關聯和聚合有用的信息:1)買家秀視頻本身。視頻以動態圖像的形式展現了買家偏好的商品視覺特徵以及拍攝主題;2)買家撰寫的評論。雖然評論有較多的噪聲信息,不能直接作為視頻標題呈現,但是其內容可能蘊含了買家對產品特點的偏好以及使用體驗。3)關聯商品的屬性信息。來自商品評論區的買家秀視頻會與一個特定的商品關聯,我們提取了關聯商品的屬性信息,如中長款(連衣裙),作為輸入。屬性結構化的展現了商品的主要特點。接下來本文將介紹Gavotte的重要組成結構以及主要的實驗和分析。

本文“Comprehensive Information Integration Modeling Framework for Video Titling”已被KDD 2020錄用。

2. Gavotte: Graph based Video Title Generator

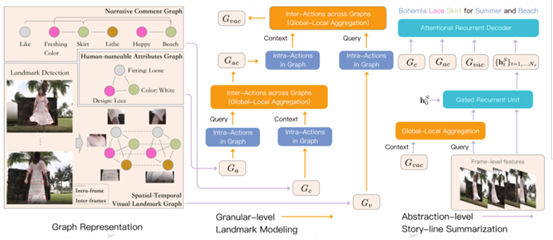

2.1 圖表示

首先我們介紹一下Gavotte如何將三種輸入表示成圖結構。

- 商品視頻信息:我們首先使用了Landmark Detection技術(Liu et al. 2018)檢測衣服類商品的商品部位特徵,每一幀的每一個部位都視為圖節點。我們將同幀的商品部位節點進行全連接,不同幀相同部位節點進行全連接,這種連接方式一方面有利於我們捕捉同幀商品部位間的交互和商品整體風格,另一方面能夠捕捉每一個商品部位跨越時間線的動態變化以及不同視點(pointview)下對商品部位的全面感知。為了增強空間-時序視覺商品部位圖的時序性和部位特點,我們給每一個節點都加上了位置嵌入(Position Embedding)(Jonas et al. 2017)和類型嵌入(Type Embedding),即最終的節點表徵為:

- 視頻評論信息:我們將評論中的每一個詞作為圖節點,並將有語法依賴關係的節點進行連接,我們發現相比於時序關係,捕捉評論中和商品有關的語義信息對生成標題更有價值。

- 關聯商品的屬性信息:我們將每一個屬性值(如 白色)作為圖節點,並對所有節點進行全連接,屬性間本身沒有時序關係,使用圖建模可以更好的探索屬性間的特殊交互作用。

2.2 細粒度交互建模

如上圖所示,細粒度交互建模對三個異構圖的圖內關係(Intra-Actions in Graph)和圖間關係(Inter-Actions across Graphs)進行了建模。

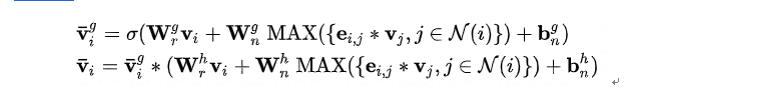

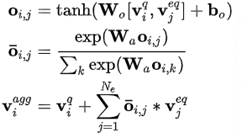

- 圖內關係建模注重和商品有關的細粒度特徵的識別。我們採用了常用而有效的圖神經網絡作為圖內關係建模的可訓練框架結構,和最原始的圖神經網絡相比,本文對信息傳播時的根節點和鄰居節點進行了單獨建模,並採用了自門控機制(Self Gating)。

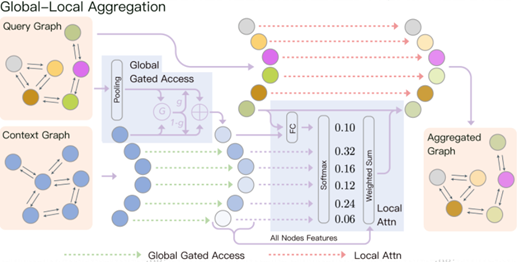

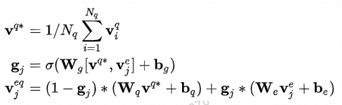

- 圖間關係建模注重異構圖之間商品有關細粒度特徵的關聯和聚合。根據其實際的物理意義,我們將圖間關係建模模塊稱為全局-局部聚合模塊(Global-Local Aggregation,GLA)。GLA包含全局門控訪問(Global Gated Access)和局部注意(Local Attention)兩個子模塊。GLA的輸入為查詢圖(Query Graph)和上下文圖(Context Graph),輸出的聚合圖(Aggregated Graph)的結構與查詢圖一致。

- 全局門控訪問用來加強上下文圖中與查詢圖全局相關的信息(可以視為初步篩選過程),並抑制毫不相關的信息。

- 局部注意力機制在局部層面(節點級別)篩選上下文圖中和查詢圖節點相關的內容並聚合到該查詢圖節點上。

2.3 故事線摘要模塊

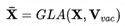

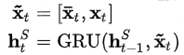

故事線摘要建模關注幀級別和視頻級別的信息,因此採用幀特徵和RNN來進行序列建模。首先我們利用全局-局部模塊將細粒度信息和幀信息進行信息融合。這是因為我們發現視頻幀建模(如商品-背景交互)和視頻建模(如視頻故事主題)和商品的細節特點息息相關。

之後我們採用RNN對視頻幀進行序列建模。

2.4 解碼器

在解碼器部分我們採用常用的注意力增強的RNN結構(Li et al. 2015),我們在每一步解碼階段都會關注細粒度圖信息和幀信息。

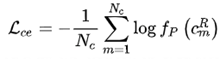

2.5 學習目標

我們採用了常用的交叉熵損失進行訓練。

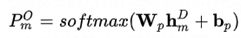

我們發現對於視頻標題的生成,重複詞的出現總是有損視頻標題的整體吸引程度,因此我們參考了文本摘要(See et al. 2017)中常用的注意力覆蓋損失,並提出了生成覆蓋損失,用以懲罰和抑制重複詞的生成。

3. 實驗和分析

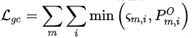

我們摘選了主要的實驗結果

可以看到,我們的模型在兩個淘寶商品數據集(T-VTD服飾類商品數據,和其他商品類別數據)上去得了最佳的效果。我們的模型在T-VTD上提升顯著,在其他商品類別數據上提升會相對弱一些,但這是合理的結果,因為服飾類商品有良好的商品部位定義,我們在其他類別上採用了近似的方法(細節可關注論文)。

該圖展示了Gavotte和其他兩個典型模型(基於RNN的SOTA模型 M-Recnet (Wang et al. 2018),和基於Transformer的SOTA模型 M-Livebot (Ma et al. 2019))的生成案例對比。具體而言,第一個案例中M-Recnet生成標題有意義信息較少,第二個案例中M-LiveBot生成標題出現未完成和損壞的情況,Gavotte則生成了網絡熱詞(如 出街、搶鏡),生成句子更為流暢,更有吸引力。同時,Gavotte可以識別商品細節級別信息(如 破洞),商品級別信息(如 牛仔褲),商品與背景交互信息(如 出街搶鏡)和視頻級別故事情節信息(如 這樣穿)。

4. 結果與展望

在這次分享中,我們介紹了買家秀視頻標題生成模型,Gavotte,以為推薦場景下的買家秀視頻自動配上有吸引力的標題。實驗證明Gavotte在生成質量上相比一般性的視頻描述生成方法取得了顯著的提升,並在案例分析中能夠捕捉 商品細節、商品整體、商品-背景交互和視頻故事情節信息。

5. 參考文獻

Liu, Jingyuan, and Hong Lu. "Deep fashion analysis with feature map upsampling and landmark-driven attention." In Proceedings of the European Conference on Computer Vision (ECCV), pp. 0-0. 2018.

Gehring, Jonas, Michael Auli, David Grangier, Denis Yarats, and Yann N. Dauphin. "Convolutional sequence to sequence learning." In Proceedings of the 34th International Conference on Machine Learning-Volume 70, pp. 1243-1252. JMLR. org, 2017.

Yao, Li, Atousa Torabi, Kyunghyun Cho, Nicolas Ballas, Christopher Pal, Hugo Larochelle, and Aaron Courville. "Describing videos by exploiting temporal structure." In Proceedings of the IEEE international conference on computer vision, pp. 4507-4515. 2015.

Abigail See, Peter J. Liu, Christopher D. Manning. "Get To The Point: Summarization with Pointer-Generator Networks". ACL (1), pp. 1073-1083. 2017.

Wang, Bairui, Lin Ma, Wei Zhang, and Wei Liu. "Reconstruction network for video captioning." In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 7622-7631. 2018.

Ma, Shuming, Lei Cui, Damai Dai, Furu Wei, and Xu Sun. "Livebot: Generating live video comments based on visual and textual contexts." In Proceedings of the AAAI Conference on Artificial Intelligence, vol. 33, pp. 6810-6817. 2019.

更多數據挖掘領域內容請查看:《KDD精華論文解讀》