一、人臉識別技術介紹

人臉識別作為一種生物特徵識別技術,具有非侵擾性、非接觸性、友好性和便捷性等優點。早在二十世紀初期,人臉識別已經出現,於二十世紀中期,發展成為獨立的學科。人臉識別真正進入應用階段是在90年代後期。人臉識別屬於人臉匹配的領域,人臉匹配的方法主要包括特徵表示和相似性度量。

人臉識別通用的流程主要包括人臉檢測、人臉裁剪、人臉校正、特徵提取和人臉識別。人臉檢測是從獲取的圖像中去除干擾,提取人臉信息,獲取人臉圖像位置,檢測的成功率主要受圖像質量,光線強弱和遮擋等因素影響。獲取人臉後,人臉裁剪是根據實際需求,裁剪部分或整體的人臉,進一步精確化人臉圖像。為提高人臉識別準確率,人臉校正可以儘可能的降低由於姿態和表情導致的人臉變化,獲取正面或者平靜狀態下的人臉照片。特徵提取利用不同的特徵,對圖片進行相似度的衡量和評價。人臉識別主要包括一對一或者一對多的應用場景,對目標人臉進行識別和驗證。

人臉表達模型主要分為2D,2.5D,3D。2D人臉指的是RGB,灰度和紅外圖像,是確定視角下表徵顏色或紋理的圖像,不包括深度信息。2.5D是在某一視角下拍攝獲取的人臉深度數據,但是曲面信息不連續,沒有被遮擋部分的深度數據信息。3D人臉由多張不同角度的深度圖像合成,具有完整連續的曲面信息,包含深度信息。2D圖像人臉識別的研究時間較長,軟硬件技術較為完備,得到了廣泛的應用。但是由於2D圖像反映二維平面信息,不包含深度數據,不能夠完整的表達出真實人臉模型。相比於二維人臉圖像,三維圖像不受光照等影響,具有更強的描述能力,能夠更為真實的反映人臉信息,在人臉合成、人臉遷移、三維人臉識別等場景中應用。3D人臉識別一般採用深度相機獲取人臉深度信息,主要包括雙目相機,基於結構光原理的RGB-D相機和基於光飛行時間原理的TOF相機。常見的三維人臉識別算法主要包括傳統識別方法和深度學習識別方法。

1.傳統識別方法

(1)基於點雲數據的人臉識別

點雲是3D人臉數據的一種表徵方式,每一個點都對應一個三維座標,掃描設備使用這種數據格式存儲採集的三維人臉信息,甚至可以將稀疏座標也拼接到形狀信息上,更為完善的反映人臉信息。基於點雲數據的3D人臉識別直接使用三維點雲進行匹配,常見方法有ICP(Iterative Closest Point)和Hausdorff距離。前者可以修正點雲信息中平移和旋轉變換的誤差,後者利用三維點雲之間的距離最大值,匹配人臉,但是兩者均存在魯棒性不足的問題。

(2)基於面部特徵的3D人臉識別

人臉的面部特徵主要包括局部特徵和全局特徵,局部特徵可以選擇從深度圖像上提取關於面部關鍵點的特徵信息,全局特徵是對整張人臉進行變換提取特徵,例如球面諧波特徵或者稀疏係數特徵。

2.深度學習識別方法

(1)基於深度圖的人臉識別

深度圖像中三維數據的z值被投影至二維平面,形成平滑的三維曲面。可使用歸一化網絡和特徵提取網絡實現深度圖人臉識別,歸一化網絡將輸入的深度圖像轉化為HHA圖像,再使用卷積神經網絡迴歸用於獲取歸一化深度圖的參數,特徵提取網絡用於獲取表徵深度圖人臉的特徵向量。

(2)基於RGB-3DMM的人臉識別

3DMM是指三維人臉變形統計模型,其最早是用於解決從二維人臉圖像恢復三維形狀的問題,現多被用於對深度圖像或彩色圖像進行人臉模型迴歸,實現識別任務。

(3)基於RGB-D的人臉識別

RGB-D圖像是包含了彩色圖像和深度圖,前者是從紅、綠、藍顏色通道獲取的圖像,後者是指包含與視點的場景對象的表面的距離有關的圖像通道,兩者之間是相互配準。通過對彩色圖像和多幀融合後的深度圖像分別進行預訓練和遷移學習,在特徵層進行融合,提高人臉識別率。

二、表情識別最新研究

1) Facial Emotion Recognition with Noisy Multi-task Annotations

摘要

從面部表情可以推斷出人類的情感。但是,在常見的情感編碼模型中,包括分類和維度模型,面部表情的註釋通常會非常嘈雜。為了減少人為標註多任務標籤的工作量,文中引入了帶有嘈雜的多任務註釋的面部表情識別新問題。對於這個新問題,文中建議從聯合分佈匹配的角度進行計算,其目的是學習原始人臉圖像和多任務標籤之間更可靠的關聯,從而減少噪聲影響。採用一種新方法來在統一的對抗性學習遊戲中啟用情緒預測和聯合分佈學習。在廣泛的實驗中進行的評估研究了所提出的新問題的實際設置,以及所提出的方法在合成嘈雜的帶標籤CIFAR-10或實際嘈雜的多點干擾方法上優於最新競爭方法的明顯優勢標記為RAF和AffectNet的任務。

本文探討的是嘈雜的多任務標籤中面部表情識別的問題。實際應用中,兩種最常用的面部情緒編碼模型是分類和維數,但是通過從可用的情感標籤中進行模型的學習容易產生不好的結果,因此,文中提出的公式是從聯合分佈匹配的角度解決此問題的,旨在利用數據和多任務標籤之間的相關性來減少標籤噪聲的影響。

該文為解決人臉情感識別的實際案例提供了一些貢獻,主要可概括為以下三點:(1)提出了一個帶有嘈雜的多任務標籤的面部表情識別新問題,該問題的目標是易於獲得的廉價多任務註釋;(2)提出了一種廣義化的公式,在數據和異構多任務標籤之間具有明確的聯合和邊際分佈匹配;(3)引入了一種新的對抗學習模型,以基於聯合和邊際分佈的約束條件來優化對情緒預測的訓練,這被證明適合於新提出的問題。

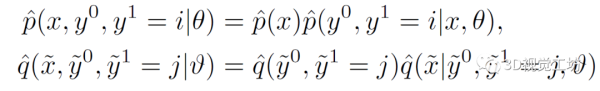

帶有噪音標籤的面部情感識別僅在帶有噪音標籤的面部圖像上訓練魯棒模型。傳統的方法是直接用噪聲標籤分佈對噪聲建模,但是傳統的條件概率建模具有幾個明顯的缺點,例如轉換矩陣缺乏約束條件收斂到真值等。針對於此,本文利用匹配兩個聯合分佈的關鍵思想,考慮在兩對數據和標籤上的以下兩個聯合概率分佈:

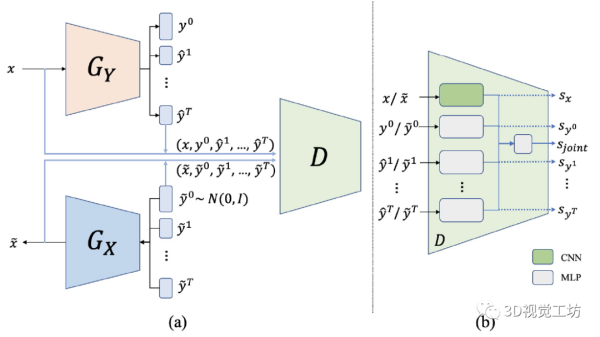

由於對現實世界數據的數據分佈的顯式概率密度函數進行建模難以計算,因此將兩個聯合分佈與精確建模進行匹配通常是不可行的。為克服該問題,本文采用了生成對抗模型方法。其中,編碼器的學習函數以從輸入圖像中推斷出乾淨的標籤,解碼器的學習函數以生成面部圖像,來自嘈雜標籤的對應表達式。整體架構如下圖所示:

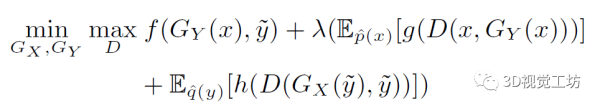

為了匹配編碼器和解碼器捕獲的聯合分佈,在生成器和鑑別器之間進行對抗遊戲。鑑別器是專門為匹配面部圖像,噪聲矢量以及GY和GX的多任務標籤的組的聯合分佈而設計。對於聯合分佈對齊,一種自然的方法是將分別從編碼器和解碼器採樣的數據在網絡中以進行對抗訓練。但是,每個組中的數據是高度異構的,因此直接串聯是不合適的。為了減少數據和多任務標籤之間的異質性,本文采用多個網絡流,並將所有網絡流的輸出送入網絡,完整的目標函數如下,

文中提出的生成器和鑑別器能夠在統一框架內優化基於情緒預測的損失和基於分佈匹配的約束。文中根據此方案設計了最小—最大目標函數:

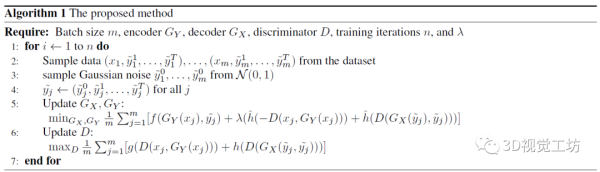

在該文中,由於將面部情感識別視為目標任務,因此將情感預測用作輔助任務,從而從圖像到標籤的關係和任務到任務的關係中使目標任務受益,該算法如下圖所示。

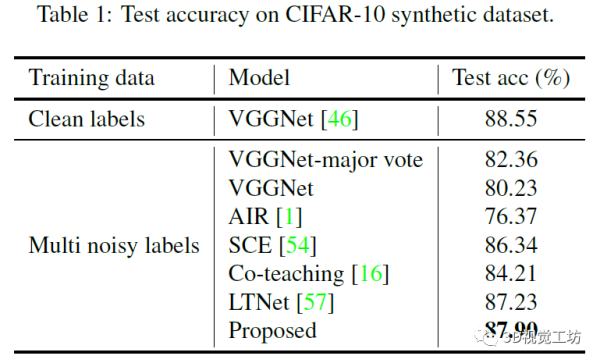

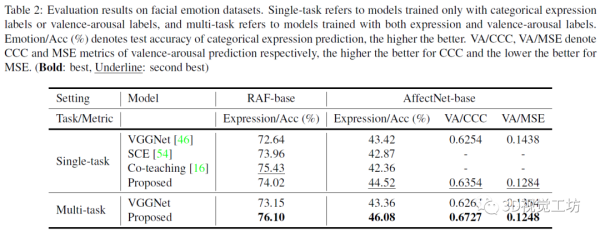

文中在兩種情況下對該模型進行評估:(1)用於圖像分類的合成噪聲標籤數據集(CIFAR-10 [25]);(2)用於面部表情識別的兩個實用的面部表情數據集(RAF和AffectNet)。

下圖為實驗1的結果,可見採用文中提出的模型使得準確率得到提高。

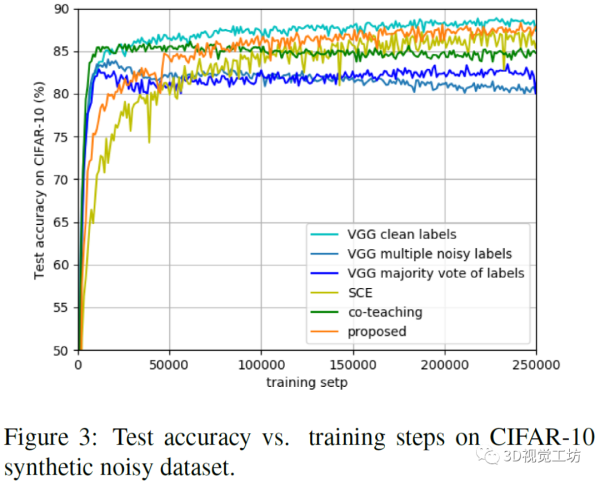

下圖為基線和在訓練步驟中提出的模型的測試準確性曲線的可視化呈現。

下圖為實驗2的面部情緒數據集的評估結果,可知在多任務情況下,運用本文提出的模型獲得的預測準確性更高。

本文介紹了一個帶有噪聲的多任務註釋的面部情緒識別的問題,在減少人為多任務學習的標籤工作方面具有很大的應用潛力。文中從聯合分配匹配的角度介紹了一種新的公式,按照該公式,採用一種新的對抗學習方法來共同優化情緒預測和聯合分佈學習。最後研究了合成噪聲標籤數據集和實用的噪聲多任務數據庫的建立,並通過對它們的評估證明了該方法在解決新問題方面的明顯優勢。

2) THIN: THrowable Information Networks and Application for Facial Expression Recognition In The Wild

摘要

對於使用深度學習技術解決的許多任務,可以識別一個外生變量,該變量會影響到不同類的外觀,並且理想分類器能夠對此變量始終保持不變。本文提出了雙重外生/內生表示法。文中設計了一個預測層,該預測層使用由外生表示條件限定的深度整體,可以學習自適應的弱預測變量的權重,並且顯式地建模外生變量和預測任務之間的依賴關係。此外,文中提出了外源性消除損失的計算,以從內源性表示中刪除外源性信息。因此,外生信息被使用了兩次,第一次是作為目標任務的條件變量,第二次是在內生表示中產生不變性。本文將該方法命名為THIN,代表THrowable Information Net-works。本文在幾種可以識別外源信息的情況下,通過實驗驗證了THIN,例如大旋轉下的數字識別和多尺度下的形狀識別。還將其應用於以身份為外生變量的FER。特別是證明了THIN在某些具有挑戰性的數據集上的性能明顯優於最新方法。

深度學習技術在計算機視覺的監督學習中取得了重大進展,允許共同學習一種表示形式和基於這種表示形式的預測變量。完善的深度學習技術構成了大多數計算機視覺問題中的最新方法,例如對象分類或檢測,語義分割或面部和身體分析。然而,在許多此類任務中,對象的外觀會受到外生變量的嚴重影響,理想情況下,任務預測應根據該變量進行不變。

但是,與此同時,從預測系統的角度來看,無論外在變量(例如受試者身份)的變化如何,都應該預測我們的目標任務(例如面部表情)。因此,本文認為與任務相關的表示(稱為內生表示)應包含儘可能少的有關外生變量的信息。

綜上所述,在這種情況下,該外生變量是數據變化的重要來源,同時也是信息的來源,從該信息中,預測變量的輸出應儘可能不變。因此,我們建議使用單獨的外在和內在表示。

本文的貢獻:(1)提出了一個外生樹狀深度集成方法,該模型使用內生和外生雙重網絡。第一個輸出表示用於預測任務,而第二個輸出的表示通過適應性和聯合學習更多相關的弱預測變量,以進行深度相關的調整;(2)提出了一種外源消除損失,通過內源表示與外源表示之間的正交性,從內源表示中消除外源變異;(3)在具有不同外生變量的多個任務上實驗性地驗證了這種方法。

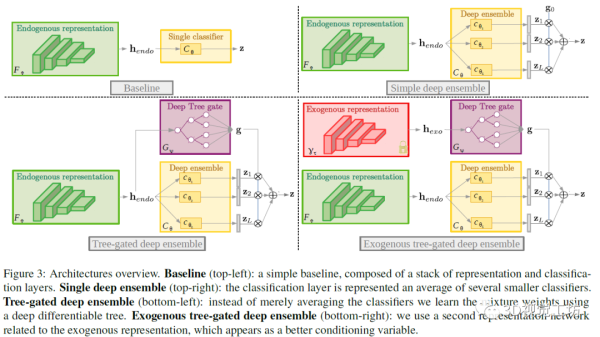

文中通過深度神經網絡對外生信息建模,然後從定義一個簡單的基線模型開始,然後逐步引入其他的架構,從而描述如何明確地合併外生表示和任務預測之間的依賴關係,整體架構如下圖所示。

如上圖所示,主要呈現了基線框架,簡單的深度集成方法框架,樹狀深度集成方法框架,外生樹狀深度集成方法框架。從基線框架開始,通過自適應加權深層集成的預測並利用外源表示來逐步改進框架的設計方法。

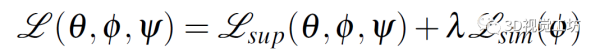

樹狀深度集成網絡通過參數優化相應的損失,然後將與外生變量有關的信息分解為內生表示中的任務,並將提取的外生和內生的特徵輸入網絡和進行輸出,通過超參數進行實驗設置,從而實現從內在表徵中去除外源性信息。

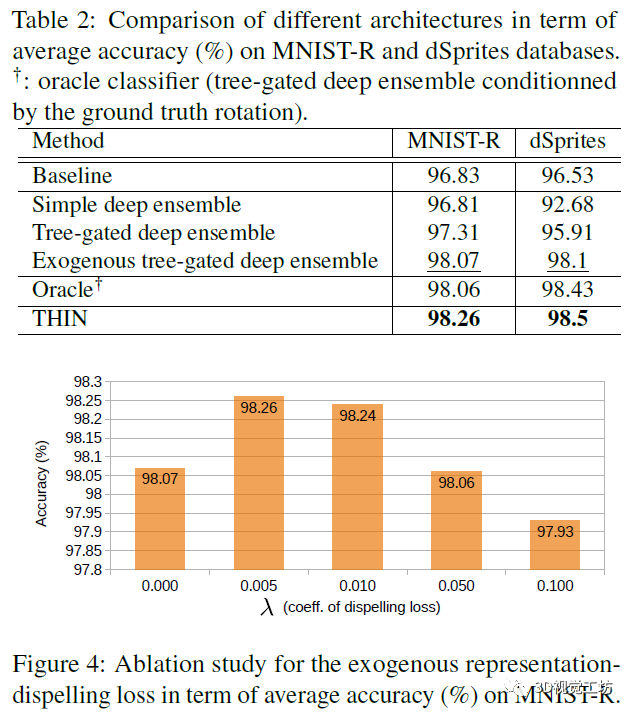

文中通過將模型在合成數據集上進行評估,從中可以清楚地識別外生變量。緊接著,在真實的FER數據集中定性和定量驗證模型,主要是介紹了用於訓練或測試所提出方法的數據集,具體的實現細節。下圖中Table 2為在MNIST-R和dSprites數據集上,根據平均準確度比較不同體系結構;Figure 4為MNIST-R以平均準確度表示的消融外源表徵消除的消融研究

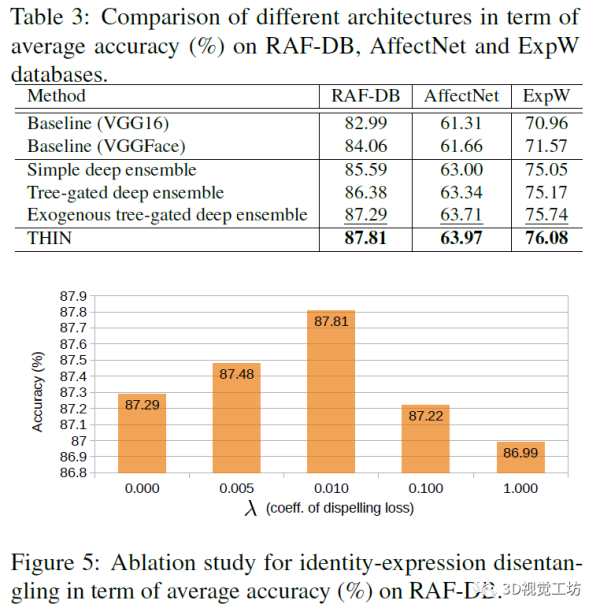

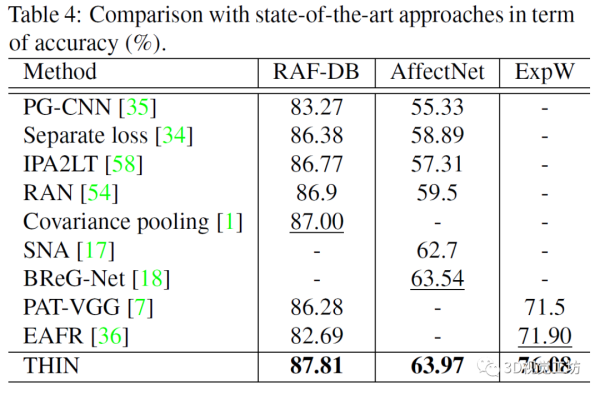

除了在MNIST數據集上之外,文中還在RAF-DB,AffectNet和ExpW數據集上進行了實驗驗證,Table 3從平均準確率上比較了不同的體系架構,Figure 5是在數據集RAF-DB上進行消融研究的結果。

最後將THIN與最新的FER方法進行了比較,證明了THIN在當今最新的,具有挑戰性的FER數據庫上的性能明顯優於最新技術。

本文中所提出的模型具有較多的應用可能性。首先,理論上可以將THIN直接應用於其他問題,例如以姿勢或比例作為外生變量的身體姿勢估計,或具有領域信息的語義分割。其次,在本文中僅使用一個外生變量來訓練THIN。但是,可以嘗試使用多個這樣的變量和表示網絡以及某種融合方案來應用。此外可以嘗試使用身份作為外生變量的THIN來預測面部表情,然後使用以面部表情作為外生變量的另一個THIN來預測身份,依此類推,以迭代地完善FER和身份預測。

參考文獻

基於深度學習的自然場景下多人臉檢測

Facial Emotion Recognition with Noisy Multi-task Annotations

THIN: THrowable Information Networks and Application for Facial Expression Recognition in the Wild

原文鏈接:https://ai.51cto.com/art/202011/631492.htm

本文轉自51CTO,本文一切觀點和視覺智能開放平臺圈子無關。

阿里雲視覺智能開放平臺(vision.aliyun.com)是基於阿里巴巴視覺智能技術實踐經驗,面向視覺智能技術的開發與應用用戶,為其提供好用、易用、普惠的視覺智能API服務的平臺,目前平臺免費開放150+種AI能力的調用權限,別猶豫啦,快來體驗吧!

釘釘掃描下方二維碼,進群免費對接百種AI能力